flink cdc读SqlServer数据,无法读取增量怎么解决? SqlServer的CDC已经开启了flink是1.13.6 CDC是2.2.1版本,

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在使用Flink CDC读取SQL Server数据时,如果无法读取增量数据,可能是由于配置或环境问题导致的。以下是详细的排查步骤和解决方案:

确保SQL Server数据库的CDC功能已正确启用,并且目标表的CDC也已开启。可以通过以下SQL语句检查:

-- 检查数据库是否启用了CDC

SELECT name, is_cdc_enabled FROM sys.databases WHERE name = '<your_database>';

-- 检查表是否启用了CDC

SELECT name, is_tracked_by_cdc FROM sys.tables WHERE name = '<your_table>';

如果未启用,可以使用以下命令启用:

-- 启用数据库CDC

EXEC sys.sp_cdc_enable_db;

-- 启用表CDC

EXEC sys.sp_cdc_enable_table

@source_schema = 'dbo',

@source_name = '<your_table>',

@role_name = NULL;

注意:确保SQL Server的CDC日志保留时间(retention)足够长,以避免增量数据丢失。

您提到使用的Flink版本为1.13.6,CDC连接器版本为2.2.1。根据知识库资料,建议确保Flink和CDC连接器版本的兼容性。如果版本不匹配,可能会导致增量读取失败。

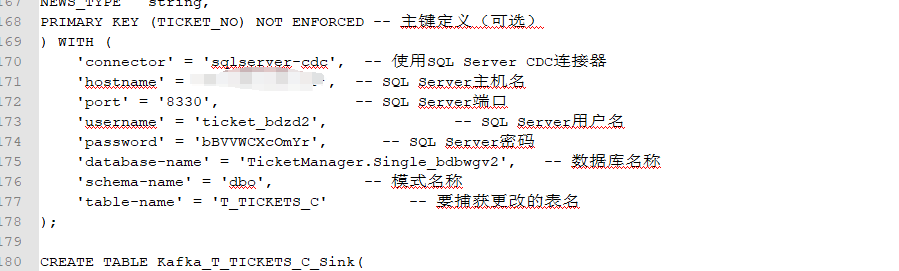

确保Flink作业中正确配置了SQL Server CDC源表参数。以下是一个典型的SQL Server CDC源表配置示例:

CREATE TABLE sqlserver_cdc_source (

id INT,

name STRING,

update_time TIMESTAMP(3),

PRIMARY KEY (id) NOT ENFORCED

) WITH (

'connector' = 'sqlserver-cdc',

'hostname' = '<your_sqlserver_host>',

'port' = '1433',

'username' = '<your_username>',

'password' = '<your_password>',

'database-name' = '<your_database>',

'table-name' = '<your_table>',

'scan.startup.mode' = 'initial', -- 或者 'latest-offset'

'debezium.snapshot.mode' = 'initial' -- 或者 'schema_only'

);

关键参数说明: - scan.startup.mode:指定启动模式。 - initial:先读取全量数据,再切换到增量读取。 - latest-offset:直接从最新的增量数据开始读取。 - debezium.snapshot.mode:指定Debezium快照模式。 - initial:在首次启动时生成快照。 - schema_only:仅读取表结构,不生成快照。

Flink CDC在从全量切换到增量读取时,需要等待一个Checkpoint完成以确保数据一致性。如果Checkpoint间隔时间过长(例如20分钟),可能导致增量读取延迟。

解决方案: - 调整Checkpoint间隔时间,建议设置为1~5分钟:

execution.checkpointing.interval: 60000 # 单位为毫秒

如果使用的是SQL Server只读实例或备库,可能存在Binlog日志不完整的问题,导致无法读取增量数据。

解决方案: - 确保使用可写实例或主库进行增量数据读取。 - 如果必须使用只读实例,建议升级SQL Server版本以支持完整的Binlog日志。

如果作业中包含多个SQL Server CDC源表,建议开启Source复用功能以减少数据库压力。可以通过以下命令启用:

SET 'table.optimizer.source-merge.enabled' = 'true';

同时,调整Source端的并发度以加快全量读取速度,避免因单个分片数据量过大导致OOM问题:

parallelism.default: 4 # 根据实际情况调整并发度

如果上述步骤仍无法解决问题,请检查Flink作业日志,重点关注以下内容: - 是否有finish split response timeout异常,这可能是因为TaskManager CPU资源不足导致的。 - 是否有OutOfMemoryError,这可能是因为分片数据量过大或内存配置不足。

解决方案: - 增加TaskManager的CPU和内存资源。 - 减少分片数据量,调整scan.incremental.snapshot.chunk.size参数。

确保SQL Server的CDC日志中确实存在增量数据。可以通过以下SQL语句查询CDC日志:

SELECT * FROM cdc.<capture_instance>_CT;

如果日志中没有增量数据,可能是SQL Server的CDC日志被清理或未正确记录。

通过以上步骤,您可以逐步排查并解决Flink CDC无法读取SQL Server增量数据的问题。如果问题仍未解决,请提供具体的错误日志以便进一步分析。您可以复制页面截图提供更多信息,我可以进一步帮您分析问题原因。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。