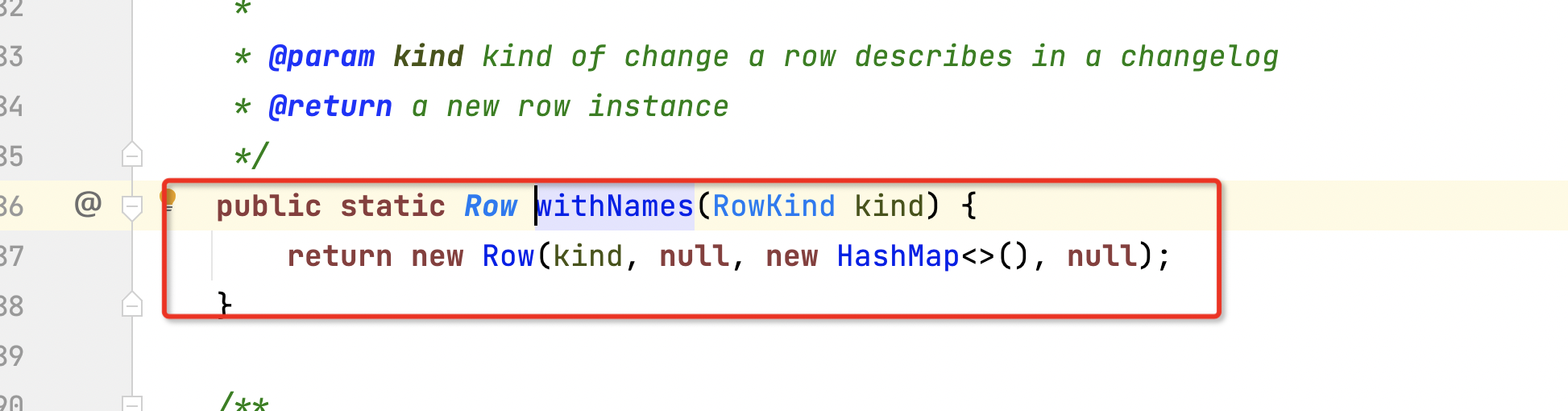

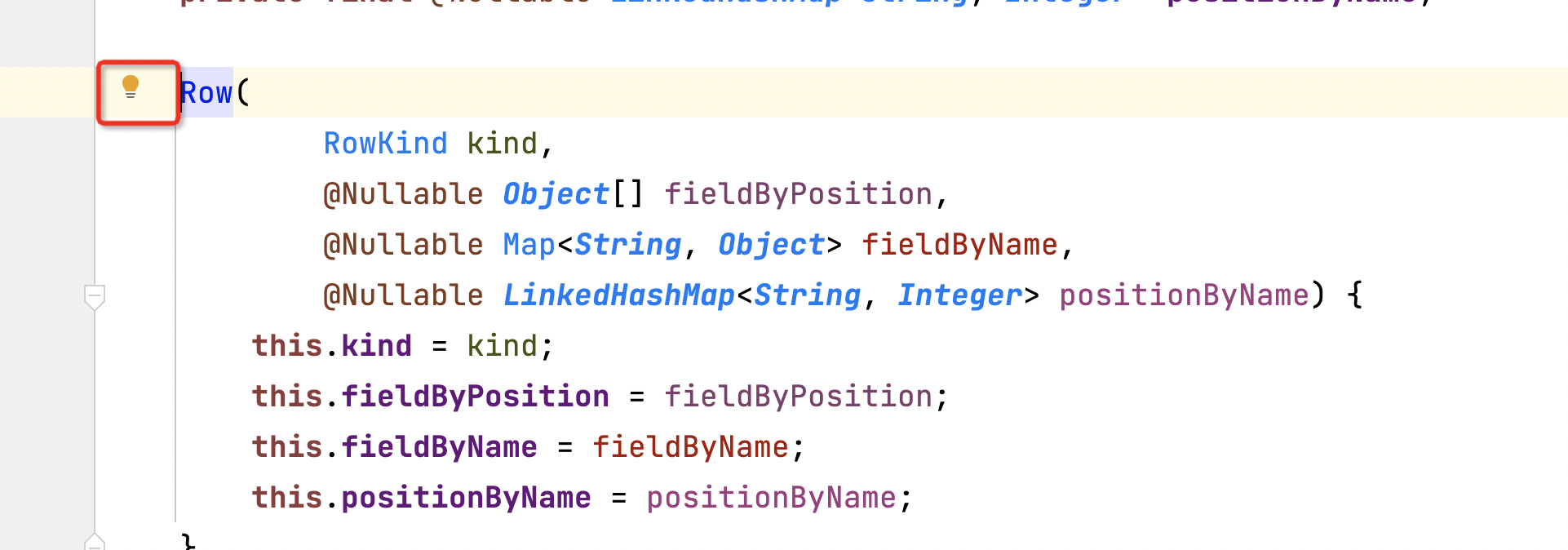

Flink暴露一个问题,使用这种方式加数据,不能指定hashMap大小?

然后这个row又是内置的,我们要动态加入 500个字段,然后导致性能急剧下降,hashmap在不停地扩容

原先能跑5万每秒,然后使用这个只能1000每秒,使用反射的话,也达不到5万,能达到2-3万多

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

根据您描述的问题,Flink在处理动态字段时,由于HashMap的扩容机制导致性能急剧下降。以下是针对该问题的详细分析和优化建议:

HashMap在初始化时如果没有指定初始容量,默认容量较小(如16)。当动态加入大量字段(如500个)时,HashMap会频繁触发扩容操作,导致性能下降。Row对象是内置的,无法直接控制其内部数据结构的初始化参数(如HashMap大小),这进一步加剧了性能瓶颈。为了避免HashMap频繁扩容,可以通过预分配足够的初始容量来减少扩容次数。具体方法如下: - 计算初始容量:根据预期字段数量(如500个),设置HashMap的初始容量为字段数 / 负载因子(默认负载因子为0.75)。例如:

int expectedFields = 500;

float loadFactor = 0.75f;

int initialCapacity = (int) (expectedFields / loadFactor) + 1;

Map<String, Object> map = new HashMap<>(initialCapacity, loadFactor);

这样可以显著减少扩容操作,提升性能。

如果Row对象的限制无法满足需求,可以考虑使用自定义数据结构替代Row,例如: - 数组存储:将字段按固定顺序存储在数组中,避免使用HashMap。例如:

Object[] fields = new Object[500];

fields[0] = value1;

fields[1] = value2;

// 动态访问字段

Object fieldValue = fields[index];

数组的访问性能远高于HashMap,但需要维护字段索引映射表。

Tuple类型,可以用于存储固定数量的字段。例如:

Tuple500 tuple = new Tuple500();

tuple.setField(value1, 0);

tuple.setField(value2, 1);

// 动态访问字段

Object fieldValue = tuple.getField(index);

对于聚合场景,开启MiniBatch可以有效减少状态更新频率,从而缓解性能瓶颈。配置如下:

table.exec.mini-batch.enabled: true

table.exec.mini-batch.allow-latency: 5s

此优化适用于对超低延迟要求不高的场景。

如果动态字段导致状态过大,可以通过以下方式减少状态大小: - 字段裁剪:仅保留必要的字段,避免存储冗余数据。 - 调整Join顺序:优先连接小数据量的流,减少状态放大效应。

Flink默认使用Kryo进行序列化,但对于动态字段场景,Kryo的性能可能不足。可以尝试以下优化: - 切换到Avro或Protobuf:这些序列化工具对动态字段的支持更好,性能也更优。 - 自定义序列化器:为动态字段实现高效的自定义序列化器,减少序列化开销。

通过增加作业的并发度,分摊单个算子的压力。可以在运行参数中配置:

parallelism.default: 16

根据实际硬件资源调整并发度。

尽量减少磁盘读取操作,优化内存使用。例如: - 启用缓存:将热点数据缓存在内存中。 - 调整Checkpoint策略:减少Checkpoint频率,降低磁盘I/O压力。

Busy和BackPressure指标,定位性能瓶颈。通过预分配HashMap容量、使用自定义数据结构、开启MiniBatch优化以及减少状态大小等方法,可以有效解决动态字段导致的性能问题。同时,结合并发度调整和高效序列化工具,能够进一步提升作业性能。建议在实施优化后,持续监控作业运行状态,确保性能稳定。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。