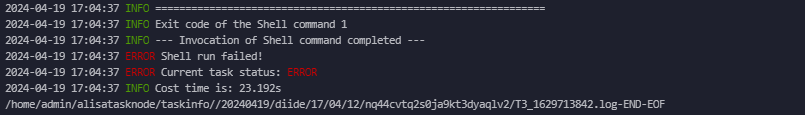

大数据计算MaxCompute我这边doris跟MySQL做数据集成的时候一直报错,但是不知道什么错,麻烦帮忙看看?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在MaxCompute与Doris、MySQL进行数据集成时,报错可能由多种原因引起。以下是根据知识库资料整理的常见问题及解决方法,供您排查和解决问题:

STRING类型字段在隐式转换为DECIMAL或DOUBLE时可能导致精度丢失或格式错误。CAST函数)来避免隐式转换带来的问题。例如:

SELECT CAST(column_name AS DECIMAL(10, 2)) FROM source_table;

partitions exceeds the specified limit。SELECT * FROM partitioned_table WHERE pt = '2023-10-01';

SELECT SUBSTR(long_field, 1, 8000000) AS part1, SUBSTR(long_field, 8000001) AS part2 FROM source_table;

Transaction timeout because cannot acquire exclusive lock。sourceIP is not in the white list。lifecycle is not specified in mandatory mode。from odps import options

options.lifecycle = 7 # 设置生命周期为7天

Perhaps the datastream from server is crushed。ORDER BY必须带LIMIT子句。ORDER BY必须带LIMIT的限制,可以通过以下方式实现:

SET odps.sql.validate.orderby.limit=false;

from odps import options

options.connect_timeout = 30 # 设置超时时间为30秒

重要提醒:

- 请确保SQL语句和数据处理逻辑符合MaxCompute的最佳实践,例如避免全排序操作(ORDER BY)对性能的影响。

- 定期检查数据质量和表结构设计,避免因字段长度、分区数量等问题导致任务失败。

希望以上内容能帮助您快速定位并解决问题!您可以复制页面截图提供更多信息,我可以进一步帮您分析问题原因。

MaxCompute(原ODPS)是一项面向分析的大数据计算服务,它以Serverless架构提供快速、全托管的在线数据仓库服务,消除传统数据平台在资源扩展性和弹性方面的限制,最小化用户运维投入,使您经济并高效的分析处理海量数据。