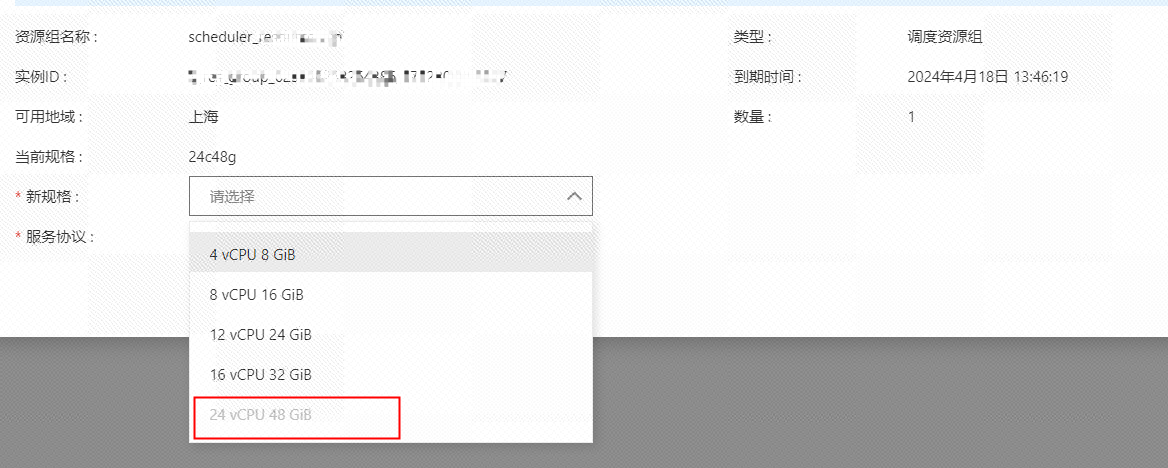

大数据计算MaxCompute目前我们在DW界面的pyodps3跑python任务, 但是py3使用的是独享调度资源,我们买的已经是最高配24c48g了,但是任务还是会oom,有没有其他办法?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在MaxCompute的DataWorks界面中运行PyODPS 3任务时,如果已经使用了最高配置的独享调度资源(24核48GB),但仍然遇到OOM(Out of Memory)问题,可以尝试以下优化方法和解决方案:

避免本地数据操作:

DataWorks建议在PyODPS节点内获取到本地处理的数据不超过50 MB。如果任务中涉及大量本地数据操作(如将数据加载到Pandas DataFrame中进行处理),可能会导致内存不足。

解决方法:尽量通过SQL或DataFrame API直接在MaxCompute上完成数据处理,减少本地数据操作。例如,使用odps.sql()执行SQL语句,或将DataFrame操作提交到MaxCompute集群执行。

分批处理数据:

如果必须在本地处理数据,可以考虑将数据分批次读取和处理,而不是一次性加载所有数据。例如,通过to_pandas()方法限制每次读取的数据量。

启用Instance Tunnel:

默认情况下,options.tunnel.use_instance_tunnel设置为False,最多只能读取一万条数据记录。如果需要读取更多数据,需手动开启Instance Tunnel。

解决方法:在代码中添加以下配置:

from odps import options

options.tunnel.use_instance_tunnel = True

这样可以提高数据读取效率,减少内存占用。

升级独享资源组:

如果当前独享资源组的创建时间较早,可能存在性能瓶颈。建议联系DataWorks技术支持,确认是否可以升级资源组以支持更高性能的任务运行。

避免加载过大第三方包:

DataWorks限制下载的第三方包总大小为100 MB。如果任务中使用了较大的第三方包,可能会导致内存不足。

解决方法:

pyodps-pack工具打包时,排除不必要的预装包(如numpy、pandas等),以减小包体积。例如:pyodps-pack -o bundle.tar.gz -exclude numpy -exclude pandas <your_package>

检查Python版本兼容性:

MaxCompute目前使用的Python 3版本为3.7。如果代码中使用了Python 3.8及以上版本的语法(如finally block),可能会导致执行失败或内存异常。

解决方法:确保代码兼容Python 3.7。

查看任务日志:

在DataWorks中,可以通过任务日志分析内存使用情况,定位具体的内存瓶颈。重点关注是否有大对象加载或长时间运行的操作。

设置调度参数:

如果任务需要访问特殊网络环境(如VPC或IDC),请确保使用独享调度资源组,并参考网络连通解决方案打通网络。

使用MaxFrame:

DataWorks的PyODPS 3节点内置了MaxFrame,可以直接用于开发和运行MaxFrame作业。MaxFrame提供了更高效的分布式计算能力,适合处理大规模数据集。

解决方法:尝试将任务迁移到MaxFrame框架下运行。

拆分复杂任务:

如果任务逻辑过于复杂,建议将其拆分为多个子任务,分别调度执行。这样可以降低单个任务的内存压力。

通过以上方法,您可以有效缓解PyODPS 3任务在独享调度资源上的OOM问题。重点在于减少本地数据操作、优化资源配置、合理使用第三方包以及分析任务日志。如果问题仍未解决,建议联系阿里云技术支持团队,提供详细的任务日志和代码示例,以便进一步排查和优化。

MaxCompute(原ODPS)是一项面向分析的大数据计算服务,它以Serverless架构提供快速、全托管的在线数据仓库服务,消除传统数据平台在资源扩展性和弹性方面的限制,最小化用户运维投入,使您经济并高效的分析处理海量数据。