Flink有没有人遇到这个问题?

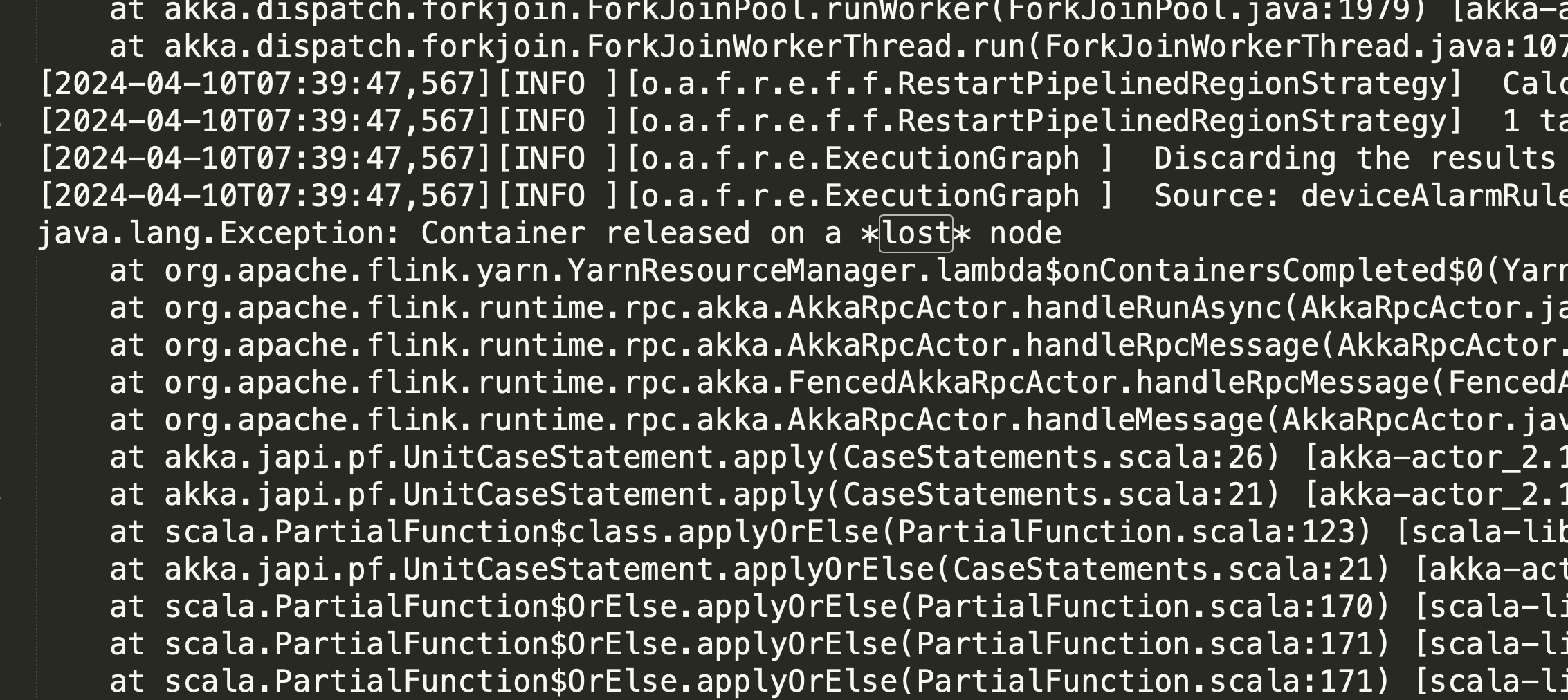

Flink有没有人遇到这个问题? Container released on a lost node

flink程序运行几个小时就挂掉了,这个应该往哪个方向排查?

展开

收起

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

阿里云 AI 助理回答

在Flink程序运行过程中,如果遇到Container released on a lost node错误,并且程序运行几个小时后挂掉,这通常与资源管理、网络连通性或节点稳定性相关。以下是排查和解决问题的方向:

1. 检查YARN资源管理器日志

- 问题原因:

Container released on a lost node通常表明某个节点(NodeManager)在运行过程中丢失了连接,可能是由于节点宕机、资源不足或网络问题导致的。 - 排查步骤:

- 查看YARN ResourceManager的日志,确认是否有节点被标记为

LOST或UNHEALTHY。 - 检查对应NodeManager的日志,分析节点丢失的具体原因(如内存不足、磁盘空间耗尽等)。

- 查看YARN ResourceManager的日志,确认是否有节点被标记为

- 解决方案:

- 如果是资源不足,增加TaskManager的内存或CPU配置。

- 如果是磁盘空间问题,参考文档中关于

No space left on device的解决建议,减少每个TaskManager上的Slot数量或提高CPU核心数以增加磁盘配额。

2. 检查网络连通性

- 问题原因:Flink作业依赖于稳定的网络连接,尤其是与Kafka、RDS等外部系统的交互。如果网络不稳定,可能导致节点丢失或任务失败。

- 排查步骤:

- 确认Flink集群与外部系统(如Kafka、RDS)之间的网络连通性是否正常。

- 使用

ping或telnet测试Flink TaskManager与外部服务的连接。

- 解决方案:

- 如果存在代理、端口转发或专线等网络机制,确保Kafka的

listeners和advertised.listeners配置正确。 - 调整网络配置,避免因网络抖动导致节点丢失。

- 如果存在代理、端口转发或专线等网络机制,确保Kafka的

3. 检查Checkpoint和Failover机制

- 问题原因:如果Checkpoint失败或Failover频繁发生,可能导致任务最终挂掉。

- 排查步骤:

- 查看Flink Web UI中的Checkpoint状态,确认是否存在Checkpoint失败或超时的情况。

- 检查Failover日志,分析是否有特定的异常信息(如数据乱序、维表缓存问题等)。

- 解决方案:

- 增加Checkpoint的超时时间或调整Checkpoint间隔。

- 启用Autopilot自动调优功能,优化作业性能。

4. 检查TaskManager的资源使用情况

- 问题原因:TaskManager的资源不足(如内存、CPU)可能导致节点崩溃。

- 排查步骤:

- 监控TaskManager的内存、CPU和线程使用情况,判断是否存在资源瓶颈。

- 检查是否存在频繁的垃圾回收(GC),这可能是内存不足的表现。

- 解决方案:

- 增加TaskManager的内存配置,减少因频繁GC导致的性能问题。

- 调整并行度与Slot数的比例,确保资源分配合理。

5. 检查数据源和Sink的稳定性

- 问题原因:如果数据源(如Kafka)或结果表(如RDS)存在性能瓶颈或配置问题,可能导致任务挂掉。

- 排查步骤:

- 确认Kafka的分区是否有数据倾斜或无数据的情况。

- 检查下游存储(如RDS)是否存在死锁或连接数限制。

- 解决方案:

- 调整Kafka分区策略,避免数据倾斜。

- 增加下游存储的连接数或TPS限制。

6. 启用算子探查功能

- 问题原因:如果数据在某个算子节点被过滤或处理异常,可能导致任务失败。

- 排查步骤:

- 使用算子探查功能,查看中间结果的输出,定位问题节点。

- 分析探查日志,确认是否存在数据丢失或处理异常。

- 解决方案:

- 根据探查结果调整SQL逻辑或数据处理方式。

7. 其他注意事项

- 重要提醒:确保Flink版本与实时计算引擎版本兼容,例如Kafka作为数据源时,需满足VVR 4.0.12及以上版本的要求。

- 监控与报警:建议开启与原任务相同级别的监控和报警设置,观察任务运行时的处理延迟、Failover情况以及Checkpoint健康状态。

通过以上步骤,您可以逐步定位并解决Container released on a lost node的问题。如果问题仍未解决,建议联系阿里云技术支持,提供详细的日志和配置信息以便进一步分析。

有帮助

无帮助

AI 助理回答生成答案可能存在不准确,仅供参考

问答分类:

问答地址:

开发者社区

>

大数据与机器学习

>

实时计算 Flink

>

问答

相关问答

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。

热门讨论

热门文章

展开全部

还有其他疑问?

咨询AI助理