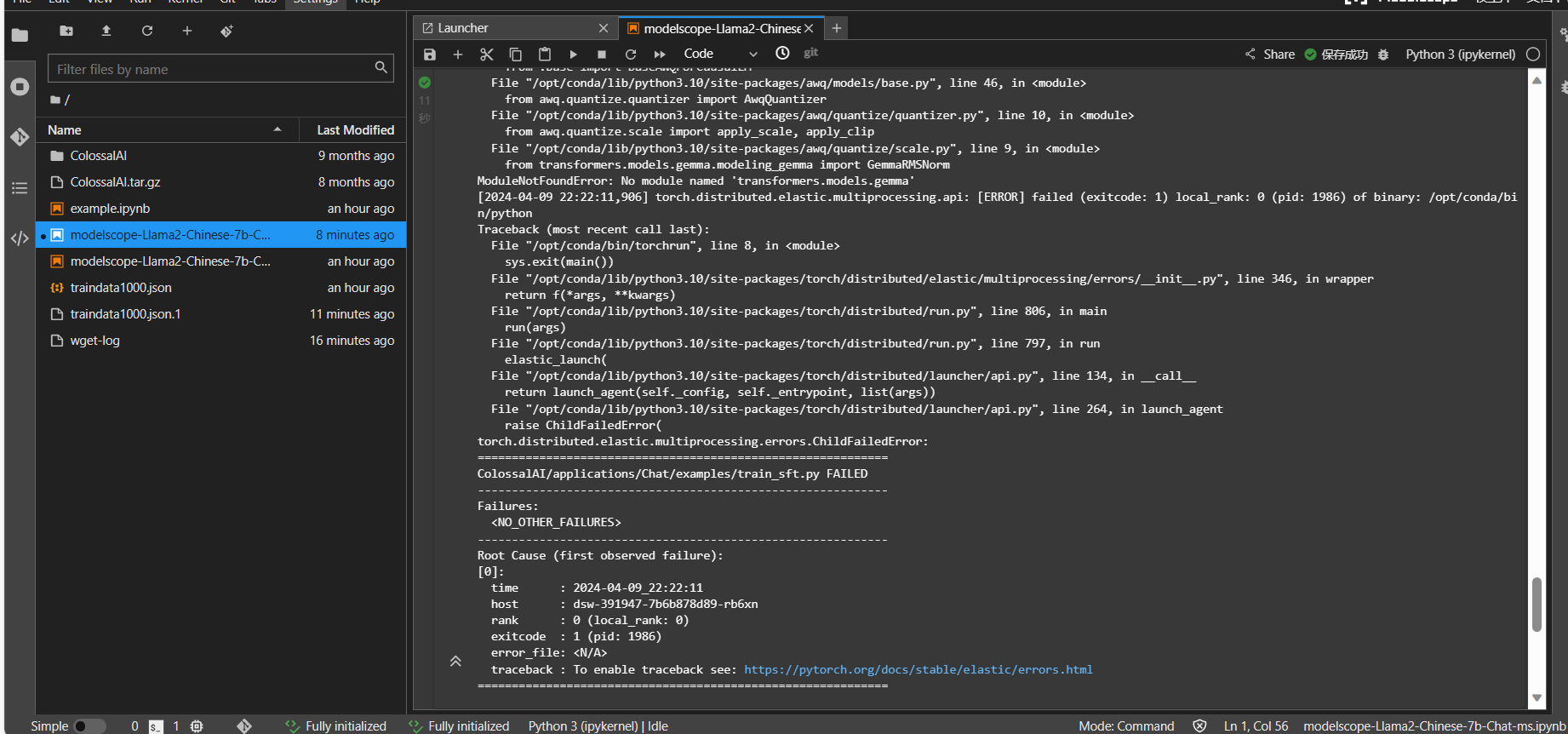

" modelscope模型微调报错怎么解决? :Warning: Could not find TensorRT2,安装环境报错:ERROR: pip's dependency resolver does not currently take into account all the packages that are installed. This behaviour is the source of the following dependency conflicts.vllm 0.3.0 requires transformers>=4.37.0, but you have transformers 4.30.0 which is incompatible.完整报错日志如下面附件

"

根据您提供的报错信息,问题主要分为两部分:TensorRT相关错误和pip依赖冲突问题。以下是针对这两类问题的解决方案。

报错信息中提到Warning: Could not find TensorRT2,这表明当前环境中未正确安装或配置TensorRT。以下是解决方法:

python -c "import tensorrt; print(tensorrt.__version__)"

如果返回版本号,则说明TensorRT已安装;如果报错,则需要安装TensorRT。

export LD_LIBRARY_PATH=$LD_LIBRARY_PATH:/path/to/TensorRT/lib

import tensorrt as trt

logger = trt.Logger(trt.Logger.WARNING)

builder = trt.Builder(logger)

print("TensorRT is successfully installed!")

报错信息中提到vllm 0.3.0 requires transformers>=4.37.0, but you have transformers 4.30.0 which is incompatible,这是由于不同库之间的版本不兼容导致的。以下是解决方法:

为了避免全局环境中的依赖冲突,建议使用virtualenv或conda创建一个独立的虚拟环境:

# 使用 virtualenv

python -m venv myenv

source myenv/bin/activate

# 或者使用 conda

conda create -n myenv python=3.8

conda activate myenv

transformers库vllm要求transformers版本不低于4.37.0。可以通过以下命令升级:

pip install --upgrade transformers>=4.37.0

pip install --force-reinstall -r requirements.txt

其中,requirements.txt是项目所需的依赖文件。

pip的--use-deprecated选项pip的旧版依赖解析器(注意:此方法仅作为临时解决方案):

pip install --use-deprecated=legacy-resolver -r requirements.txt

完成上述步骤后,建议重新运行模型微调任务,并观察是否仍有报错。如果问题依然存在,请提供完整的报错日志以便进一步分析。

通过以上步骤,您可以有效解决TensorRT和pip依赖冲突相关的报错问题。希望这些方法能够帮助您顺利完成模型微调任务!您可以复制页面截图提供更多信息,我可以进一步帮您分析问题原因。

ModelScope旨在打造下一代开源的模型即服务共享平台,为泛AI开发者提供灵活、易用、低成本的一站式模型服务产品,让模型应用更简单!欢迎加入技术交流群:微信公众号:魔搭ModelScope社区,钉钉群号:44837352