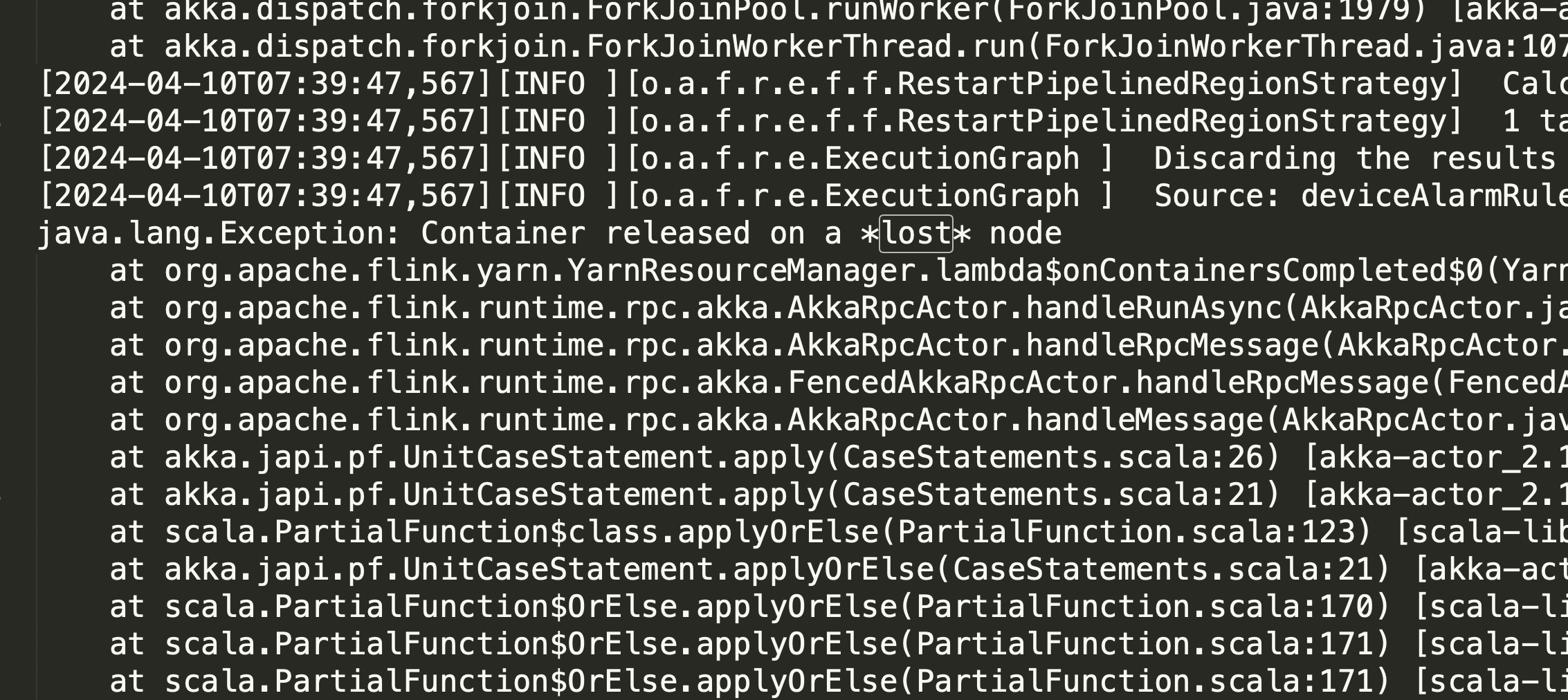

Flink CDC里有没有人遇到这个问题? Container released on a lost nodeflink程序运行几个小时就挂掉了,这个应该往哪个方向排查?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在使用Flink CDC时,遇到“Container released on a lost node”以及Flink程序运行几个小时后挂掉的问题,通常与资源管理、网络连通性或作业配置相关。以下是详细的排查方向和解决方案:

Flink作业运行过程中,如果TaskManager所在的节点发生故障(如内存不足、CPU过载等),可能会导致容器被释放,从而引发“Container released on a lost node”错误。

检查TaskManager的内存使用情况

内存不足可能导致频繁的垃圾回收(GC),进而影响作业稳定性。可以通过监控工具查看TaskManager的内存使用情况。

flink-conf.yaml中调整以下参数:taskmanager.memory.process.size: 4g

taskmanager.memory.task.heap.size: 2g

检查CPU使用率

如果某些线程占用大量CPU资源,可能会导致节点性能下降甚至崩溃。可以通过线程栈跟踪分析当前节点的瓶颈所在。

减少Slot数量

每个TaskManager上的Slot数量过多可能导致资源争用。可以尝试减少每个TaskManager的Slot数量,降低单个节点的并行任务数。

Flink作业依赖于稳定的网络连接。如果网络不稳定或存在超时问题,可能会导致节点丢失或作业失败。

测试网络连通性

使用Flink控制台的网络探测功能,检查Flink作业与上下游服务之间的网络是否连通。具体操作如下:

检查跨VPC或公网访问配置

如果Flink作业需要访问跨VPC的服务或通过公网访问,确保已正确配置NAT网关或白名单。例如:

调整连接超时时间

如果网络延迟较高,可以在DDL的WITH参数中增加connect.timeout的值。例如:

'connect.timeout' = '60s'

Flink CDC作业依赖Checkpoint机制来保证数据一致性。如果Checkpoint失败或状态恢复异常,可能会导致作业挂掉。

检查Checkpoint配置

确保Checkpoint间隔时间设置合理。如果间隔时间过长,可能会导致增量阶段卡住或状态过大。例如:

execution.checkpointing.interval: 60000 # 每60秒触发一次Checkpoint

execution.checkpointing.mode: EXACTLY_ONCE

检查Resume Token的有效性

对于MongoDB CDC等场景,如果Resume Token对应的记录在oplog.rs中不存在,可能会导致无效Token异常。建议调整oplog.rs的集合大小,确保其保留时间足够长。

启用断点续传

Flink CDC企业版支持断点续传功能,确保在网络中断或节点故障后能够从上次的状态继续消费。

通过分析Flink作业的日志,可以快速定位问题的根本原因。

查看JobManager和TaskManager日志

检查日志中是否存在以下错误信息:

No space left on device:磁盘空间不足,建议减少Slot数量或增加TaskManager的CPU核心数以提高磁盘配额。Heartbeat timeout:可能是网络延迟或节点负载过高导致心跳超时,建议优化网络配置或调整资源分配。启用DEBUG日志级别

在log4j.properties中启用DEBUG日志级别,获取更详细的错误信息。例如:

logger.flink.name = org.apache.flink

logger.flink.level = DEBUG

MySQL Binlog压力

如果MySQL实例的Binlog记录量较大,可能会导致Flink CDC读取时消耗大量带宽。建议启用CDC Source复用,减少带宽使用。

Flink版本兼容性

确保使用的Flink版本与阿里云实时计算Flink版的引擎版本兼容。不兼容的版本可能导致运行时异常。

针对“Container released on a lost node”和Flink程序运行几小时后挂掉的问题,建议从以下几个方向进行排查: 1. 资源管理:检查内存、CPU和Slot配置。 2. 网络连通性:测试网络连通性,调整超时时间。 3. Checkpoint和状态恢复:优化Checkpoint配置,确保状态恢复正常。 4. 日志分析:通过日志定位具体错误原因。 5. 其他因素:关注MySQL Binlog压力和版本兼容性。

通过以上步骤,可以有效定位并解决Flink CDC作业运行中的问题。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。