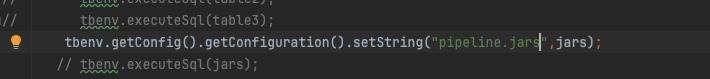

我看flink cdc 源码通过这种方式引入第三方包。但是我本地测没发引入进去。请问是什么原因啊?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在本地测试 Flink CDC 作业时,如果无法成功引入第三方包,可能是由于以下几个原因导致的。以下是详细分析和解决方案:

Flink 的运行环境默认不会包含所有依赖,因此需要确保第三方包的作用域配置正确。

pom.xml 文件中相关依赖的作用域是否为 compile 或未指定(默认为 compile)。provided。示例:

<dependency>

<groupId>com.ververica</groupId>

<artifactId>flink-connector-mysql-cdc</artifactId>

<version>${flink-cdc.version}</version>

<!-- 本地运行时注释掉下一行 -->

<!-- <scope>provided</scope> -->

</dependency>

解决方法: - 在本地调试时,注释掉 <scope>provided</scope>,以确保依赖被正确打包到本地运行环境中。 - 在部署到 Flink 集群时,取消注释 <scope>provided</scope>,并将依赖作为附加文件上传。

某些商业版连接器(如 MaxCompute、MySQL CDC 等)可能需要额外的 Uber JAR 包才能正常运行。这些 Uber JAR 包包含了运行时所需的类文件。

问题表现: 运行作业时可能会出现类似以下错误:

Caused by: java.lang.ClassNotFoundException: com.alibaba.ververica.connectors.odps.newsource.split.OdpsSourceSplitSerializer

解决方法: 1. 从 Maven 中央仓库下载对应的 Uber JAR 包。例如,对于 MySQL CDC 连接器,可以下载 flink-connector-mysql-cdc-<version>-uber.jar。 2. 在代码中通过 pipeline.classpaths 配置添加 Uber JAR 包路径。

示例代码:

Configuration conf = new Configuration();

conf.setString("pipeline.classpaths", "file:///path/to/flink-connector-mysql-cdc-<version>-uber.jar");

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment(conf);

如果您使用的是 Python 作业,并尝试引入第三方 Python 包(如 opencv-python-headless),需要确保依赖已正确编译并兼容 Flink 的运行环境。

问题表现: - 第三方 Python 包未正确安装或编译,导致运行时无法加载。 - 使用了不兼容的 Python 版本(如 Flink 默认预装的 Python 3.7 或 3.9)。

解决方法: 1. 编译第三方 Python 包: - 推荐使用 quay.io/pypa/manylinux2014_x86_64 镜像容器中的 Python 3.7 编译第三方包。 - 编译完成后,将生成的 .zip 文件上传到 Flink 集群。

Flink 集群默认不具备访问公网的能力,因此在本地调试时,可能无法直接拉取第三方依赖。

解决方法: - 将所有依赖打包到本地运行环境中。 - 使用离线模式运行作业,避免依赖外部网络。

如果上述方法仍无法解决问题,可以通过日志排查具体错误原因。

操作步骤: 1. 在代码中添加日志输出,记录依赖加载过程。

import logging

logging.info("Loading third-party dependencies...")

根据您的描述,问题可能出在依赖作用域配置、缺少 Uber JAR 包或 Python 环境兼容性上。建议按照以下步骤逐一排查: 1. 检查 pom.xml 文件中依赖的作用域配置。 2. 下载并配置对应的 Uber JAR 包。 3. 确保 Python 依赖已正确编译并上传到 Flink 集群。 4. 在本地调试时,确保所有依赖均已打包到运行环境中。

如果问题仍未解决,请提供具体的错误日志,以便进一步分析。您可以复制页面截图提供更多信息,我可以进一步帮您分析问题原因。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。