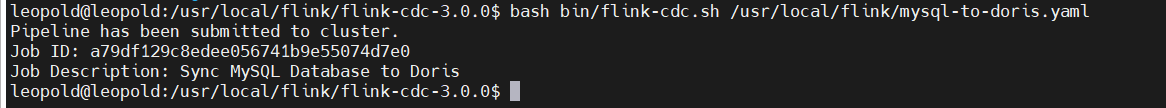

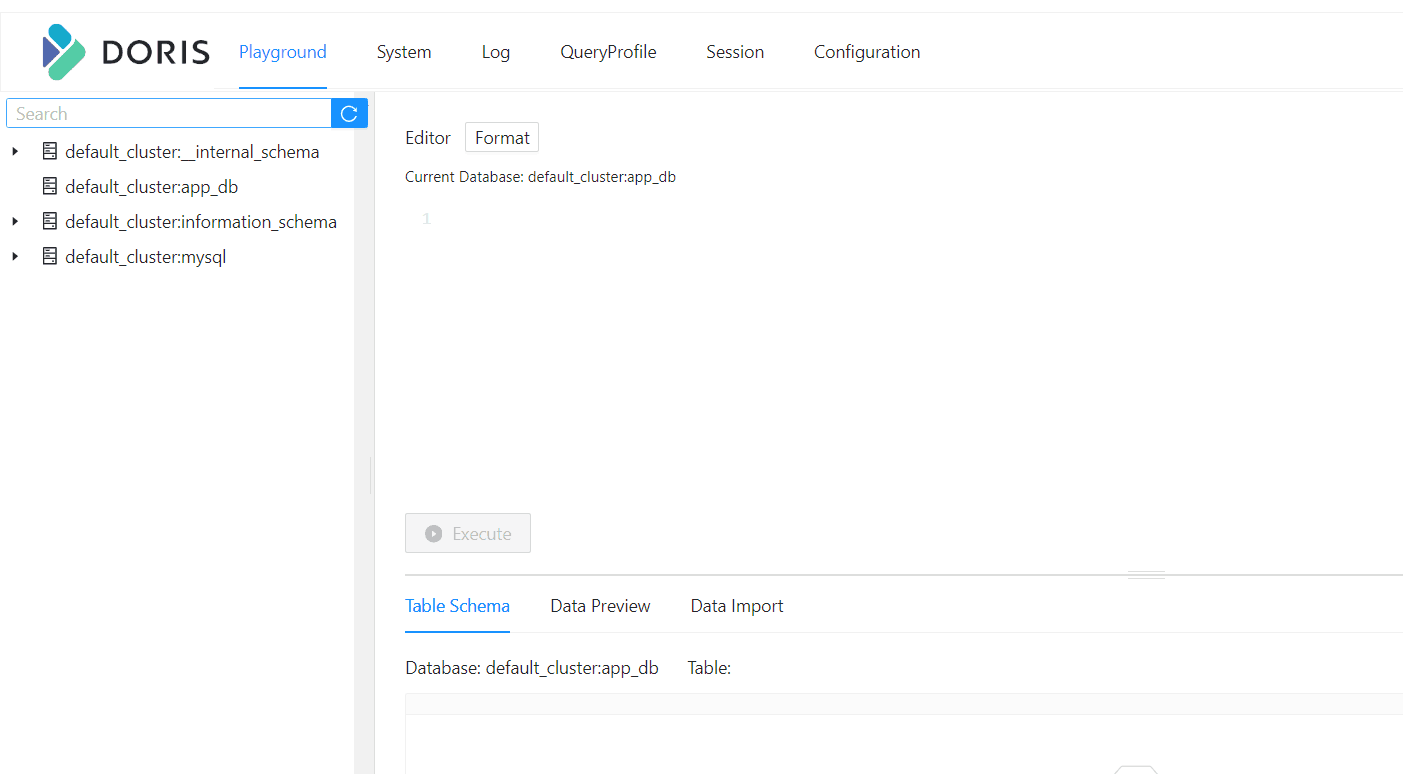

Flink CDC里数据能提交,有个log然后我发现时间差8个小时,然后修改了下taskmanager.sh jobmanager.sh的相关配置 加了个个+GMT+8后来日志的时间正确了但是就是没有把mysql的数据同步过来,这是为什么?。

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

根据您描述的问题,Flink CDC日志时间调整为正确的时区后,MySQL的数据未能同步过来。以下是可能的原因分析及解决方案:

虽然您已经通过修改taskmanager.sh和jobmanager.sh的配置解决了日志时间差8小时的问题,但Flink CDC在读取MySQL Binlog时,仍然需要确保时区配置一致。

原因:Flink CDC在解析Binlog中的timestamp字段时,依赖于server-time-zone参数。如果该参数未正确设置,可能会导致数据解析失败或无法同步。

解决方案:

server-time-zone参数,确保其与MySQL服务器的时区一致。例如:

CREATE TABLE mysql_source (

...

) WITH (

'connector' = 'mysql-cdc',

'hostname' = 'your-mysql-host',

'port' = '3306',

'username' = 'your-username',

'password' = 'your-password',

'database-name' = 'your-database',

'table-name' = 'your-table',

'server-time-zone' = 'Asia/Shanghai'

);

MyDeserializer),请检查是否在serverTimeZone处正确设置了时区信息。可以参考RowDataDebeziumDeserializeSchema中对timestamp类型的解析逻辑。MySQL的Binlog是实例级别的,记录了所有数据库和表的变更。如果Flink CDC未正确配置过滤条件,可能会导致数据无法同步。

原因:Flink CDC通过Debezium或连接器层面完成表级过滤。如果table-name或database-name配置错误,可能导致Flink CDC无法读取目标表的变更记录。

解决方案:

database-name和table-name的配置是否正确。Binlog_Do_DB或Binlog_Ignore_DB过滤器。可以通过以下命令查看:

SHOW MASTER STATUS;

如果Binlog_Ignore_DB包含目标数据库,需调整MySQL配置以允许记录该库的变更。

Flink作业与MySQL之间的网络连通性可能存在问题,导致数据无法同步。

原因:即使日志时间正确,网络不通仍会导致Flink CDC无法读取MySQL的Binlog数据。

解决方案:

如果MySQL的Binlog保留时间过短,可能导致Flink CDC在Failover后无法重新读取历史数据。

原因:MySQL的Binlog默认保留时间较短(如18小时或存储空间占用超过30%时清理)。如果Flink作业中断时间较长,Binlog可能已被清理。

解决方案:

expire_logs_days设置为7天:

SET GLOBAL expire_logs_days = 7;

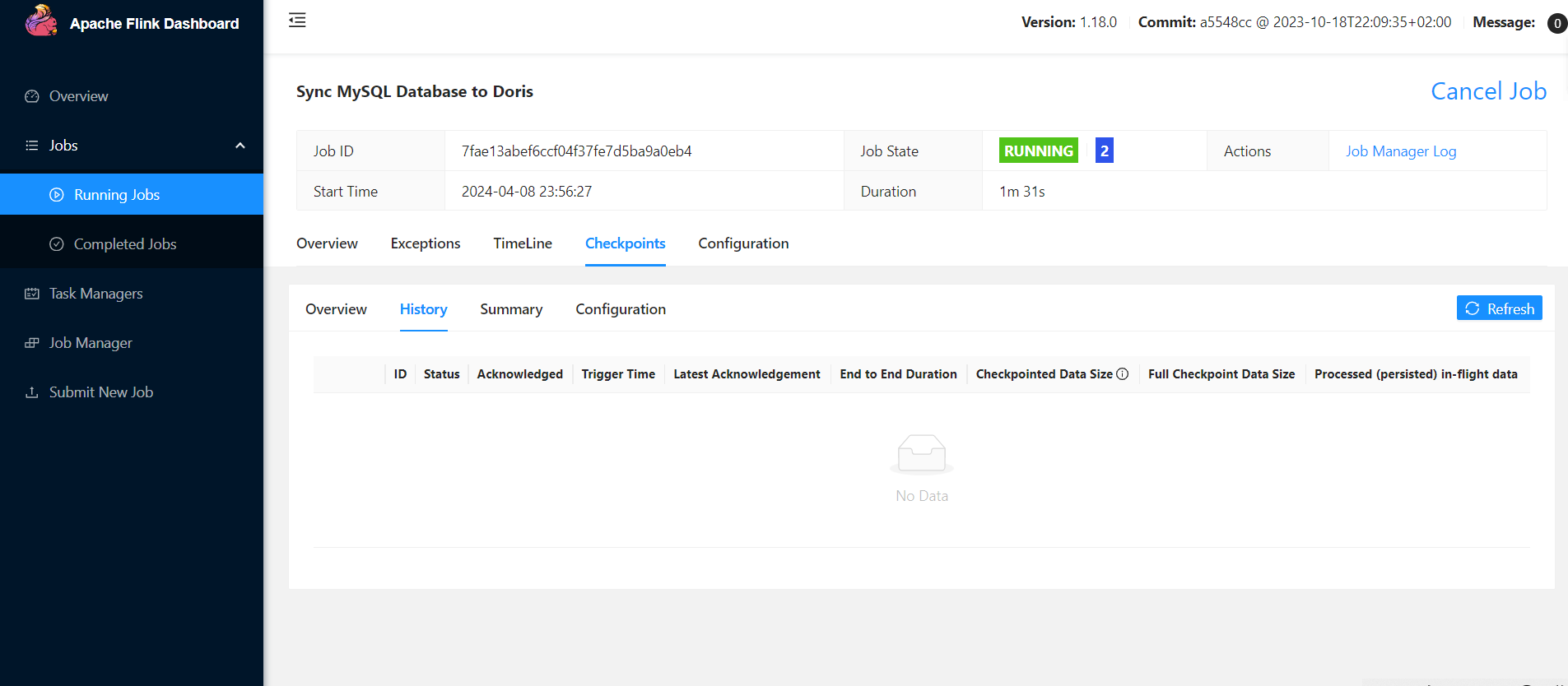

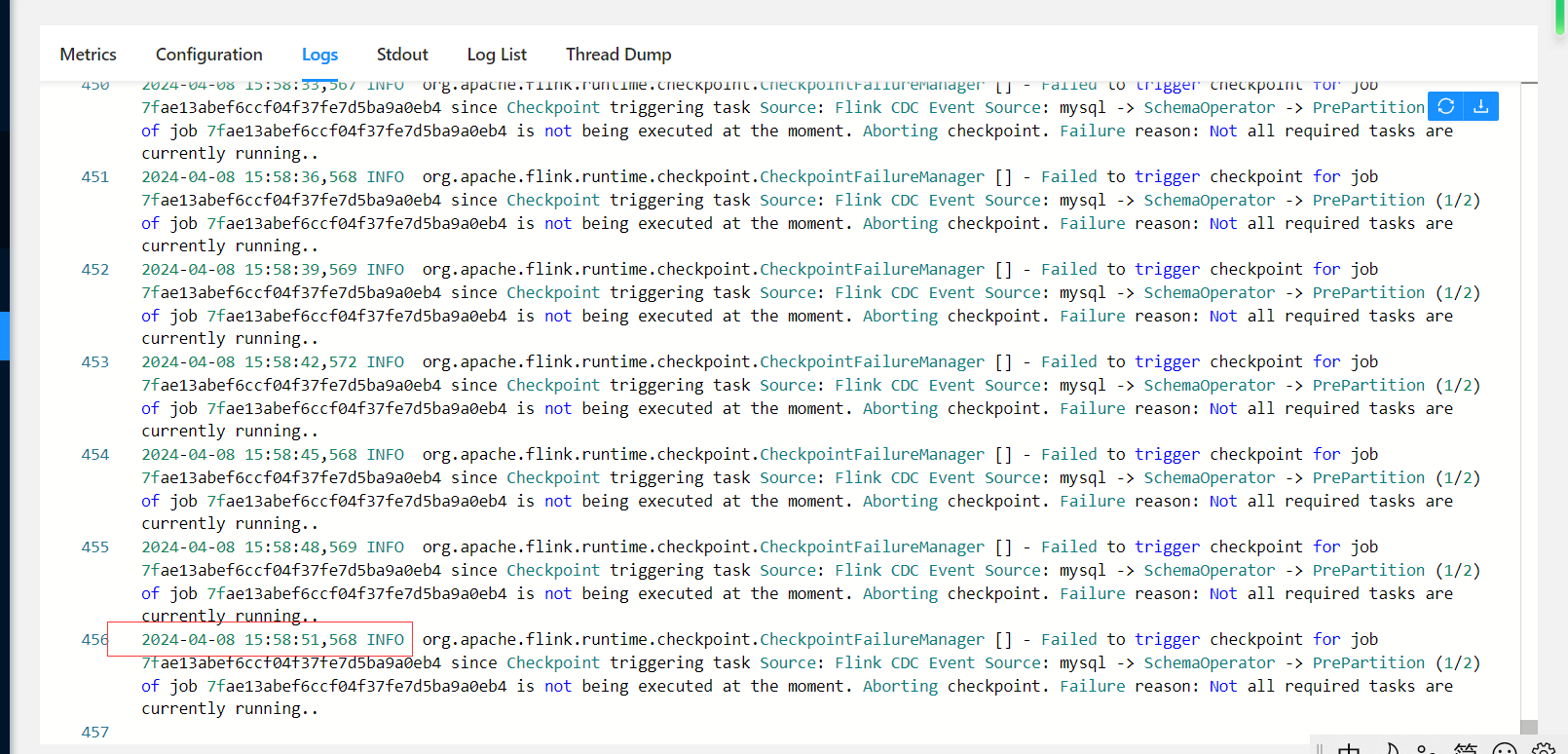

Flink作业的状态可能异常,导致数据无法正常同步。

原因:如果Flink作业在运行过程中出现反压、资源不足或其他异常,可能导致Source无法消费数据。

解决方案:

Caused by信息,定位根因。根据上述分析,建议您按照以下步骤排查问题: 1. 检查server-time-zone参数是否正确配置。 2. 确认database-name和table-name的过滤条件无误。 3. 验证网络连通性和MySQL白名单配置。 4. 调整MySQL的Binlog保留时间,避免数据丢失。 5. 检查Flink作业日志,定位并解决潜在的异常。

如果问题仍未解决,请提供更详细的日志信息以便进一步分析。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。