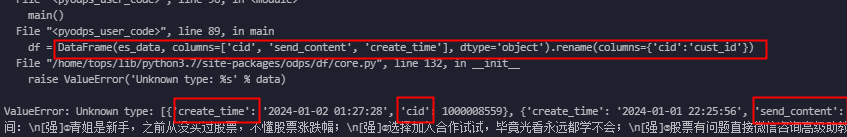

大数据计算MaxCompute使用odps的 Dataframe(data)将一个列表转为df,数据格式如图, 但是报错; 我使用pandas的 pd.Dataframe就正常执行, 怎么解决呢?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

根据您提供的问题描述,odps.DataFrame(data) 在将列表转换为 DataFrame 时出现报错,而使用 pandas.DataFrame(data) 则可以正常执行。以下是可能的原因分析及解决方案:

PyODPS 的 DataFrame 在初始化时会尝试对数据列的类型进行自动推断。如果数据中存在空值(如整列为空或部分为空),可能会导致推断失败,从而引发错误。

设置 unknown_as_string=True

如果某些列无法被正确推断类型,可以通过设置 unknown_as_string=True 将这些列强制指定为字符串类型。例如:

from odps import DataFrame

data = [

[1, 'A', None],

[2, 'B', 3.5],

[3, None, 4.0]

]

df = DataFrame(data, unknown_as_string=True)

print(df.dtypes)

手动指定列类型

使用 as_type 参数显式指定每列的数据类型。as_type 参数需要是一个字典,键为列名,值为目标类型。例如:

df = DataFrame(data, as_type={'col1': 'int', 'col2': 'string', 'col3': 'float'})

print(df.dtypes)

PyODPS 的 DataFrame 对复杂数据类型(如嵌套的列表或字典)支持有限。如果您的数据中包含复杂结构(如嵌套的 list 或 dict),PyODPS 可能无法正确解析这些列。

手动指定复杂列的类型

对于包含复杂结构的列,必须通过 as_type 参数显式指定其类型。例如,如果某列是嵌套的整数列表,可以指定为 list<int>:

data = [

[1, [1, 2, 3]],

[2, [4, 5, 6]]

]

df = DataFrame(data, as_type={'col2': 'list<int>'})

print(df.dtypes)

预处理数据

如果数据结构过于复杂,建议先使用 Pandas 进行预处理,确保数据格式符合 PyODPS 的要求后再转换为 PyODPS DataFrame。

PyODPS 的运行环境与本地 Python 环境可能存在差异。如果代码在本地运行正常但在 MaxCompute 环境中报错,可能是由于以下原因: - 依赖包缺失

PyODPS 的 handle 函数体中的代码会在 MaxCompute Executor 中执行,而不是在本地执行。因此,如果代码中引用了本地安装但未上传至 MaxCompute 的第三方包,会导致报错。

handle 函数体中尽量避免引用外部变量或模块。如果需要引用,建议在函数体内重新导入。以下是一个完整的示例,展示如何将列表数据正确转换为 PyODPS DataFrame:

import pandas as pd

data = [

[1, 'A', None],

[2, 'B', 3.5],

[3, None, 4.0]

]

df_pd = pd.DataFrame(data, columns=['col1', 'col2', 'col3'])

print(df_pd)

from odps import DataFrame

data = [

[1, 'A', None],

[2, 'B', 3.5],

[3, None, 4.0]

]

# 设置 unknown_as_string 和 as_type 参数

df_odps = DataFrame(data, unknown_as_string=True, as_type={'col3': 'float'})

print(df_odps.dtypes)

通过上述方法,您可以有效解决 odps.DataFrame(data) 报错的问题。如果问题仍然存在,请提供具体的错误信息以便进一步排查。您可以复制页面截图提供更多信息,我可以进一步帮您分析问题原因。

MaxCompute(原ODPS)是一项面向分析的大数据计算服务,它以Serverless架构提供快速、全托管的在线数据仓库服务,消除传统数据平台在资源扩展性和弹性方面的限制,最小化用户运维投入,使您经济并高效的分析处理海量数据。