swift app-ui --model_type qwen-7b-chat-int4  modelscope中,加载量化模型,报错.加载 Qwen-1_8B-Chat 是正常?

modelscope中,加载量化模型,报错.加载 Qwen-1_8B-Chat 是正常?

根据您提供的问题,您在使用 swift app-ui --model_type qwen-7b-chat-int4 加载量化模型时遇到报错,而加载 Qwen-1_8B-Chat 模型时正常。以下是针对该问题的详细分析和解决建议:

从知识库中可以了解到,通义千问系列模型(如 Qwen-7B-Chat 和 Qwen-1_8B-Chat)支持多种量化版本(如 INT4、INT8 等),但不同模型的量化版本可能存在兼容性或配置要求上的差异。

modelscope://qwen/Qwen-7B-Chat-Int4。报错的原因可能包括以下几种情况: 1. 模型文件不完整或损坏:下载的 Qwen-7B-Chat-Int4 模型文件可能存在问题。 2. 硬件或软件环境不匹配:INT4 量化模型对硬件(如 CPU 或 GPU)和软件(如 PyTorch 版本、CUDA 驱动等)有特定要求。 3. 命令参数错误:swift app-ui 命令可能未正确指定模型路径或量化类型。

确保 Qwen-7B-Chat-Int4 模型文件已正确下载且无损坏。可以通过以下方式验证: - 使用 ModelScope 提供的 snapshot_download 方法重新下载模型文件:

python3 download_from_modelscope.py -model_name Qwen/Qwen-7B-Chat-Int4 -version v1.1.7

替换 -version 参数为实际需要的版本号。

INT4 量化模型对运行环境有较高要求,需确保以下条件满足: - 硬件要求: - 至少 30 GiB 内存(推荐 64 GiB)。 - 支持 AVX512 指令集的 Intel CPU 或 NVIDIA GPU(如 A100、V100)。 - 软件要求: - 安装最新版本的 PyTorch 和 CUDA(如果使用 GPU)。 - 确保安装了支持 INT4 量化的深度学习框架(如 BigDL-LLM 或 DeepGPU-LLM)。

在运行 swift app-ui 命令时,确保正确指定了模型路径和量化类型。例如:

swift app-ui --model_type qwen-7b-chat-int4 --model_path modelscope://qwen/Qwen-7B-Chat-Int4

如果仍然报错,可以尝试手动加载模型并测试推理功能,以排除命令工具本身的问题。

如果 INT4 量化版本无法正常加载,可以尝试使用其他量化版本(如 INT8 或 FP16)。例如: - 下载 Qwen-7B-Chat 的 INT8 量化版本:

python3 download_from_modelscope.py -model_name Qwen/Qwen-7B-Chat-Int8 -version v1.1.7

swift app-ui --model_type qwen-7b-chat-int8 --model_path modelscope://qwen/Qwen-7B-Chat-Int8

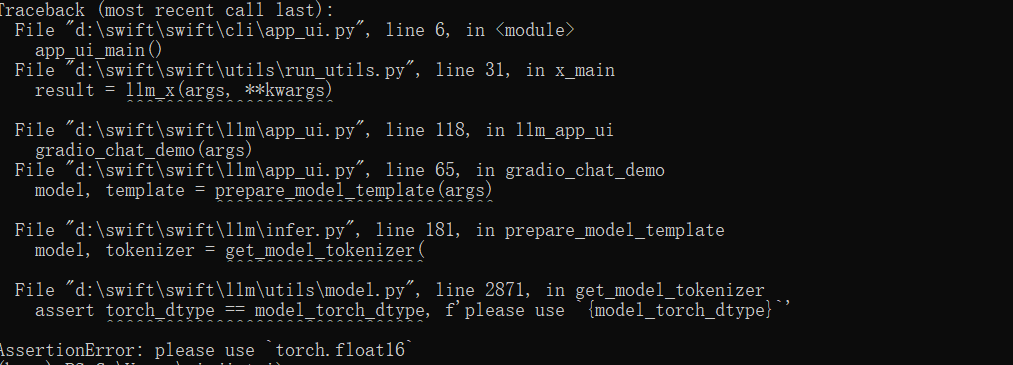

如果上述步骤仍无法解决问题,请查看报错日志,重点关注以下信息: - 是否提示缺少依赖库或驱动。 - 是否提示模型文件路径错误。 - 是否提示硬件不支持 INT4 量化。

通过以上步骤,您可以逐步排查并解决加载 Qwen-7B-Chat-Int4 模型时的报错问题。如果问题仍未解决,建议提供具体的报错日志以便进一步分析。您可以复制页面截图提供更多信息,我可以进一步帮您分析问题原因。

ModelScope旨在打造下一代开源的模型即服务共享平台,为泛AI开发者提供灵活、易用、低成本的一站式模型服务产品,让模型应用更简单!欢迎加入技术交流群:微信公众号:魔搭ModelScope社区,钉钉群号:44837352