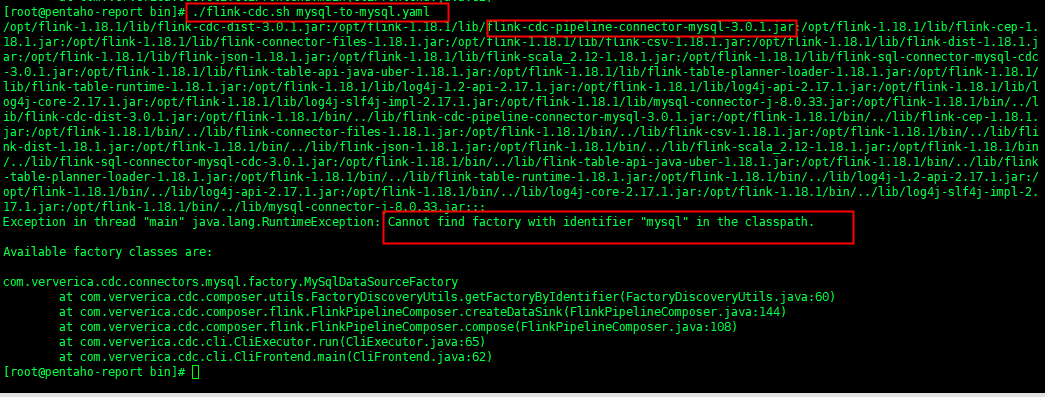

Flink CDC 里jar都放入lib目录了,执行flink-cdc.sh还是失败怎么弄?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在使用 Flink CDC 时,如果已经将相关 JAR 包放入 lib 目录,但执行 flink-cdc.sh 脚本仍然失败,可能是由于以下原因导致的。以下是详细的排查步骤和解决方案:

确保所有依赖的 JAR 包都已正确放置到 lib 目录中,并且版本匹配。Flink CDC 连接器通常需要以下两类 JAR 包: - FAT JAR(flink-sql-connector-xxx.jar):包含连接器及其所有依赖,适合 SQL 作业。 - 普通 JAR(flink-connector-xxx.jar):仅包含连接器代码,需手动管理第三方依赖。

如果使用的是 FAT JAR,请确保其版本与 Flink 版本兼容。例如,flink-sql-connector-mysql-cdc-2.1.0.jar 需要与 Flink 1.13 或更高版本配合使用。

解决方法: - 检查 lib 目录中的 JAR 文件是否完整。 - 如果使用 SNAPSHOT 版本(如 flink-sql-connector-mysql-cdc-2.2-SNAPSHOT.jar),需要自行编译源码生成 JAR 文件,因为 SNAPSHOT 版本不会发布到 Maven 中央仓库。

Flink CDC 的运行依赖于正确的配置文件(如 flink-conf.yaml)。如果配置文件中缺少必要的参数或存在错误,可能导致脚本执行失败。

常见问题及解决方法: - 重启策略未配置:如果作业失败后需要彻底退出而不是重启,可以在 flink-conf.yaml 中设置重启策略。例如:

restart-strategy: fixed-delay

restart-strategy.fixed-delay.attempts: 2

restart-strategy.fixed-delay.delay: 10 s

这样可以避免作业无限重启。 - 类加载冲突:如果出现 java.lang.ClassCastException 或 java.lang.NoSuchMethodError 等错误,可能是因为类加载顺序冲突。可以通过以下方式解决: - 在 flink-conf.yaml 中添加以下配置,指定优先加载的类: yaml classloader.parent-first-patterns.additional: org.codehaus.janino 其中 org.codehaus.janino 是冲突的类名,需根据实际报错替换。

flink-cdc.sh 脚本的内容可能存在问题,例如: - 环境变量未正确设置:确保脚本中设置了正确的 Flink 和 Java 环境变量。例如:

export FLINK_HOME=/path/to/flink

export PATH=$FLINK_HOME/bin:$PATH

--jar、--class 等。解决方法: - 手动运行脚本中的命令,逐步排查问题。例如:

$FLINK_HOME/bin/flink run -c com.example.MainClass /path/to/your-job.jar

Flink 的日志文件(如 jobmanager.log 和 taskmanager.log)中通常会记录详细的错误信息。通过查看日志,可以快速定位问题。

常见日志错误及解决方法: - MySQL 权限问题:如果日志中出现类似 DELETE command denied to user 的错误,说明 MySQL 用户权限不足。需要为用户授予相应的权限:

GRANT ALL PRIVILEGES ON database_name.* TO 'user_name'@'host';

FLUSH PRIVILEGES;

- Debezium 配置问题:如果日志中显示数值类型被解析为字符串,可能是因为 Debezium 的默认配置不正确。可以通过以下方式调整:

Properties properties = new Properties();

properties.setProperty("bigint.unsigned.handling.mode", "long");

properties.setProperty("decimal.handling.mode", "double");

如果 Flink CDC 作业需要访问外部存储(如 MySQL、PostgreSQL 等),请确保网络连接正常,并且目标数据库允许访问。

解决方法: - 检查目标数据库的白名单设置,确保 Flink 集群的 IP 地址已被添加。 - 如果使用本地调试模式,确保上下游存储的公网访问已开启,并将本地 IP 添加至白名单。

flink-sql-connector-mysql-cdc-2.2-SNAPSHOT.jar),需要从源码编译生成 JAR 文件,因为 SNAPSHOT 版本不会发布到 Maven 中央仓库。通过以上步骤,您可以逐步排查并解决 flink-cdc.sh 执行失败的问题。如果问题仍未解决,请提供具体的错误日志信息,以便进一步分析。您可以复制页面截图提供更多信息,我可以进一步帮您分析问题原因。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。