Flink CDC里提交任务的时候,卡死,查日志也没查出哪里报错,要怎么办?

Flink CDC里提交任务的时候,卡死,查日志也没查出哪里报错,要怎么办?

展开

收起

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

阿里云 AI 助理回答

在Flink CDC任务提交时出现卡死且日志未明确报错的情况下,可以按照以下步骤进行排查和解决:

1. 检查资源分配是否充足

- 问题现象:任务提交后卡住,可能是因为资源不足导致任务无法正常启动。

- 排查方法:

- 检查当前资源队列的剩余资源是否满足任务需求。

- 查看是否有类似

exceeded quota: resourcequota的报错信息。

- 解决方案:

- 如果资源不足,可以通过增加资源配额或降低作业启动所需的资源来解决问题。

2. 确认网络连通性

- 问题现象:任务卡死可能是由于上下游组件之间的网络连接问题。

- 排查方法:

- 在启动日志页面查找是否有

TimeOut类的报错信息。 - 确认Flink集群与CDC数据源(如MySQL、Postgres等)之间的网络是否连通。

- 在启动日志页面查找是否有

- 解决方案:

- 如果存在网络问题,确保Flink集群与数据源处于相同VPC下,并检查安全组规则和白名单配置。

3. 检查CDC配置是否正确

- 问题现象:CDC任务卡死可能与配置错误有关,例如表名、字段类型不匹配等。

- 排查方法:

- 确认

tableList选项是否正确配置,表名需包含数据库名,格式为yourDatabaseName.yourTableName。 - 检查DDL中定义的字段类型、字段顺序和大小写是否与物理表一致。

- 确认

- 解决方案:

- 根据报错提示调整CDC配置,确保字段定义与物理表完全一致。

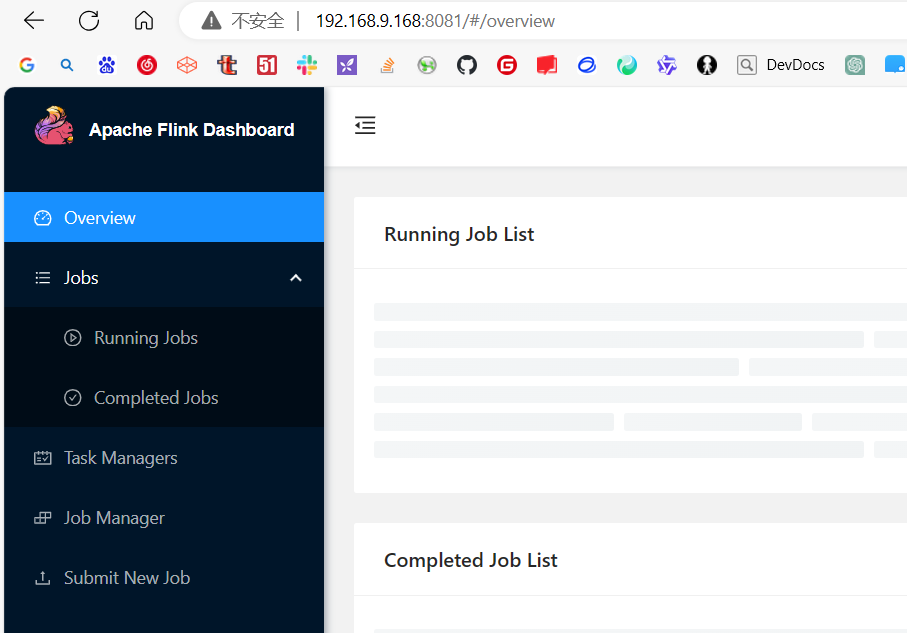

4. 查看Task Manager和Job Manager日志

- 问题现象:任务卡死但无明显报错,可能需要深入分析日志。

- 排查方法:

- 在作业日志页面,分别查看Job Manager和Task Managers的日志。

- 如果有失效的Task Manager,查看其日志以定位问题。

- 解决方案:

- 根据日志中的异常信息(如

Caused by部分)定位根因,并针对性解决问题。

- 根据日志中的异常信息(如

5. 检查Checkpoint和Failover机制

- 问题现象:任务卡死可能与Checkpoint或Failover机制相关。

- 排查方法:

- 在Checkpoints页签查看是否存在慢Checkpoint或失败的Checkpoint。

- 检查是否有类似

Task did not exit gracefully within 180 + seconds的报错信息。

- 解决方案:

- 如果是Checkpoint问题,优化Checkpoint配置,例如增加超时时间或调整并行度。

- 如果是Failover问题,检查自定义函数实现是否存在问题(如

close方法阻塞)。

6. 调整日志级别以获取更多信息

- 问题现象:默认日志级别可能不足以定位问题。

- 排查方法:

- 将日志级别从

INFO调整为DEBUG,以获取更详细的日志信息。

- 将日志级别从

- 解决方案:

- 修改日志级别后重新提交任务,观察日志中是否有新的异常信息。

7. 检查Binlog配置

- 问题现象:CDC任务卡死可能与Binlog配置不正确有关。

- 排查方法:

- 确认Binlog格式是否为

ROW模式,避免使用Mixed或Statement模式。 - 检查Binlog保留时间是否过短,可能导致数据丢失。

- 确认Binlog格式是否为

- 解决方案:

- 将Binlog格式设置为

ROW,并延长Binlog保留时间(如7天)。

- 将Binlog格式设置为

8. 其他常见问题排查

- Replication Slot问题:

- 如果使用Postgres CDC,检查是否有

Replication slot "xxxx" is active的报错。 - 解决方案:手动释放slot或配置

debezium.slot.drop.on.stop=true。

- 如果使用Postgres CDC,检查是否有

- Schema不一致问题:

- 如果有

Encountered change event for table xxx.xxx whose schema isn't known to this connector的报错,确认数据库用户权限是否正确。

- 如果有

- GTID问题:

- 如果有

The connector is trying to read binlog starting at GTIDs ...的报错,延长Binlog保留时间或加快处理速度。

- 如果有

总结

通过以上步骤,您可以逐步排查Flink CDC任务卡死的原因。如果问题仍未解决,建议结合具体日志信息进一步分析,或联系阿里云技术支持团队获取帮助。您可以复制页面截图提供更多信息,我可以进一步帮您分析问题原因。

有帮助

无帮助

AI 助理回答生成答案可能存在不准确,仅供参考

问答分类:

问答地址:

开发者社区

>

大数据与机器学习

>

实时计算 Flink

>

问答

相关问答

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。

相关文章

热门讨论

热门文章

展开全部

还有其他疑问?

咨询AI助理