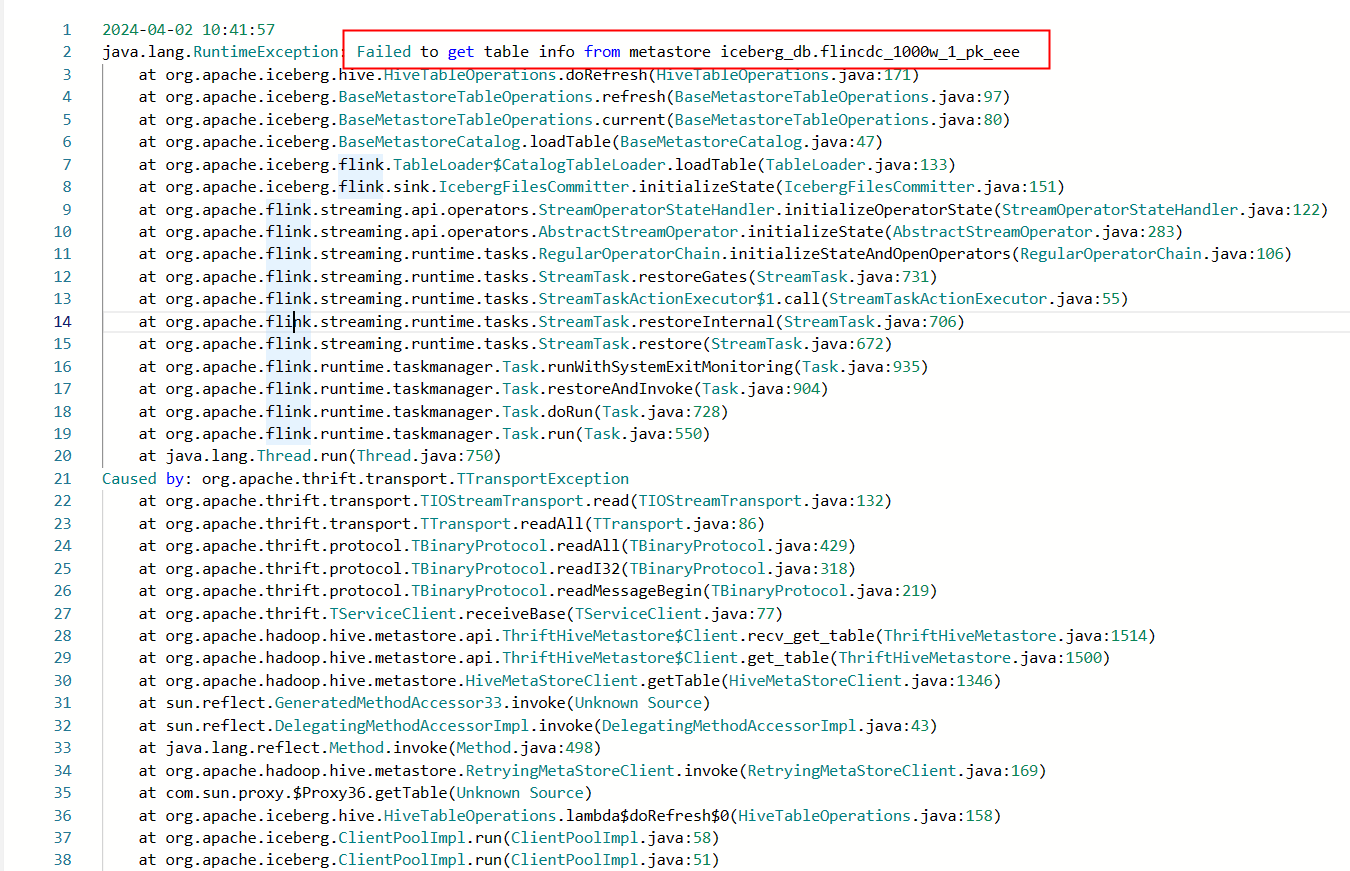

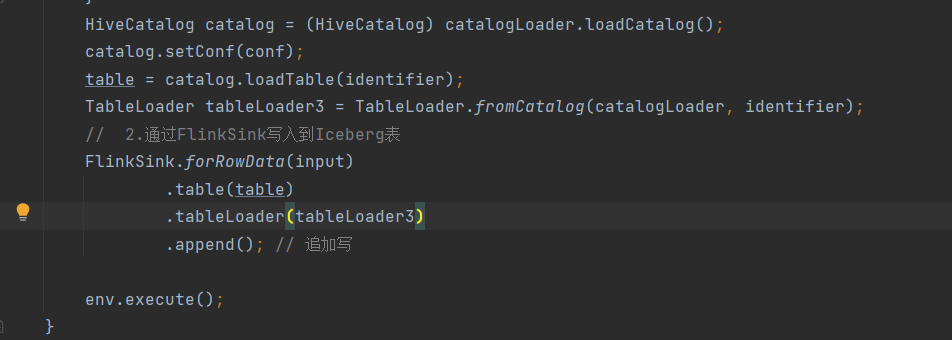

Flink CDC里sink写iceberg报这个怎么解决?standalone方式没问题,yarn-session方式就回报这个错,卡了一个星期了,

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

根据您提供的问题描述,Flink CDC在yarn-session模式下写入Iceberg时出现错误,而在standalone模式下运行正常。这种问题通常与环境配置、资源分配或依赖冲突有关。以下是详细的分析和解决方案:

standalone模式和yarn-session模式的运行环境可能存在差异,例如:

yarn-session模式下可能会加载额外的依赖,导致与Iceberg或Flink CDC的依赖版本不兼容。yarn-session模式下,Flink作业的资源(如内存、CPU)由YARN管理。如果资源分配不足,可能会导致任务失败,尤其是在写入Iceberg时需要较大的内存来处理元数据和文件操作。yarn-session模式下可能缺少必要的配置参数,例如:

warehouse路径、dlf.endpoint等参数未正确设置。table.optimizer.state-compatibility.ignore-sink参数未正确配置,导致Sink被视为有状态算子,从而引发兼容性问题。yarn-session模式下可能存在权限问题,例如:

access.key.id和access.key.secret未正确配置。步骤:

vvr-4.0.12-flink-1.13及以上。flink-shaded包避免依赖冲突。将所有依赖打包到一个fat jar中,并确保没有重复的类。yarn-session模式下,检查lib目录中的依赖是否完整。验证:

mvn dependency:tree命令检查依赖树,确保没有冲突的库。步骤:

flink-conf.yaml中设置以下参数:

taskmanager.memory.process.size: 4g

taskmanager.numberOfTaskSlots: 2

yarn-site.xml中配置了足够的资源。例如:

<property>

<name>yarn.nodemanager.resource.memory-mb</name>

<value>8192</value>

</property>

验证:

步骤:

'connector' = 'iceberg',

'catalog-name' = '<yourCatalogName>',

'catalog-database' = '<yourDatabaseName>',

'io-impl' = 'org.apache.iceberg.aliyun.oss.OSSFileIO',

'oss.endpoint' = '<yourOSSEndpoint>',

'access.key.id' = '${secret_values.ak_id}',

'access.key.secret' = '${secret_values.ak_secret}',

'warehouse' = '<yourOSSWarehousePath>',

'dlf.catalog-id' = '<yourCatalogId>',

'dlf.endpoint' = '<yourDLFEndpoint>',

'dlf.region-id' = '<yourDLFRegionId>'

table.optimizer.state-compatibility.ignore-sink=true,避免Sink被视为有状态算子。验证:

yarn-session模式下运行简单的INSERT语句,确认是否能成功写入Iceberg表。步骤:

access.key.id和access.key.secret已正确配置,并且具有读写权限。curl命令测试网络连通性:

curl http://<yourOSSEndpoint>

验证:

flink-conf.yaml中启用详细日志,帮助定位问题:

logger.level: DEBUG

INSERT INTO dlf_iceberg VALUES (1, 'test');

standalone模式下的配置和依赖复制到yarn-session模式下,逐步排查差异。通过上述步骤,您可以逐步排查并解决yarn-session模式下Flink CDC写入Iceberg的问题。重点在于依赖冲突、资源分配、配置参数和文件系统权限的校验。如果问题仍未解决,请提供具体的错误日志,以便进一步分析。

希望以上内容对您有所帮助!

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。