Flink CDC里flink1.18 拉的代码没有这个类,但是下载的jar包中 有这个类,这是啥意思?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

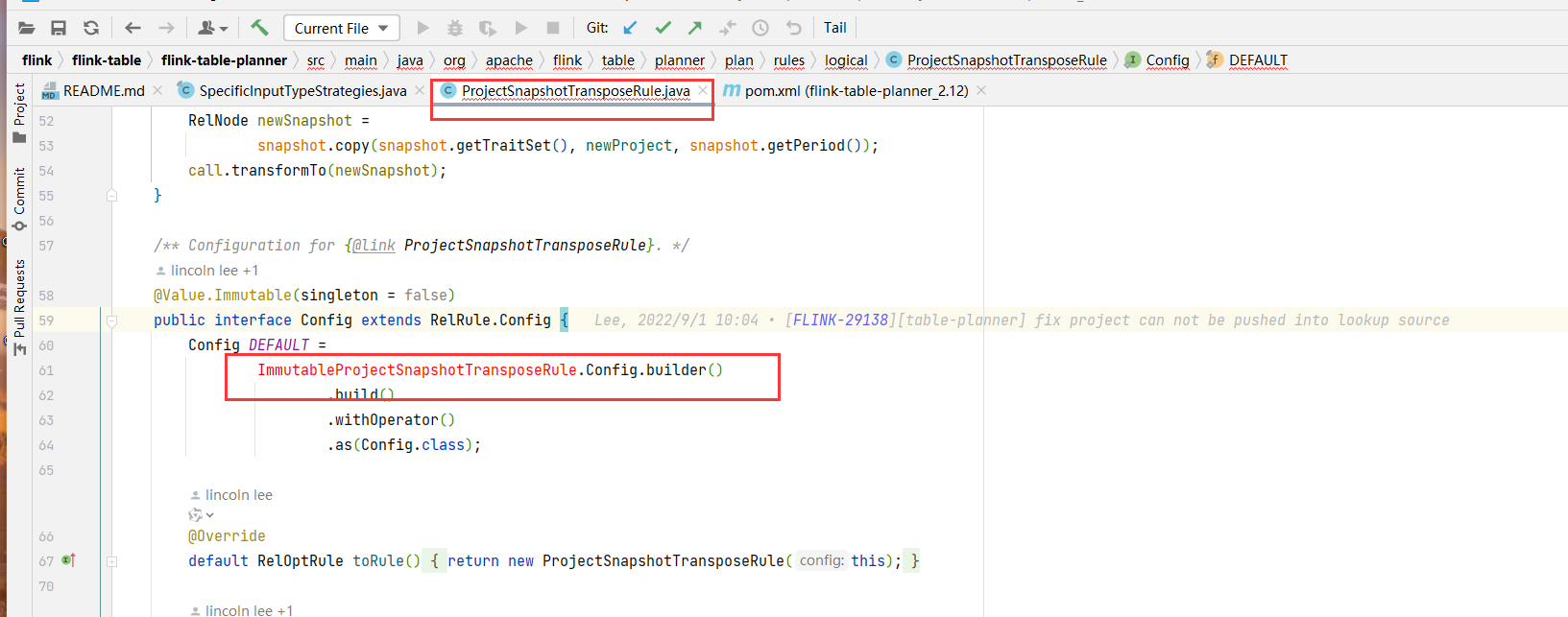

在使用 Flink CDC 时,您提到“Flink 1.18 拉取的代码中没有某个类,但下载的 JAR 包中有这个类”,这种情况通常与以下原因相关:

Flink CDC 的代码库和发布的 JAR 包可能存在不一致的情况。具体来说: - 代码库中的内容:Flink CDC 的代码库(如 GitHub)可能包含最新的开发分支代码,这些代码尚未完全发布到 Maven 中央仓库或官方 JAR 包中。 - JAR 包的内容:发布的 JAR 包通常是基于某个特定的稳定版本构建的,可能包含了额外的依赖或经过优化的代码。

因此,您在代码库中找不到某个类,但在 JAR 包中存在,可能是因为该类是在构建过程中通过 Shade 插件或其他方式引入的,而不是直接存在于源码中。

Flink CDC 的某些 JAR 包是 FAT JAR(也称为 Uber JAR),它们不仅包含连接器本身的代码,还包含了所有依赖的第三方库。例如: - flink-sql-connector-xxx.jar 是 FAT JAR,包含了连接器及其所有依赖的类。 - flink-connector-xxx.jar 则只包含连接器的核心代码,依赖需要用户自行管理。

如果某个类在 JAR 包中存在,但在代码库中找不到,可能是因为该类属于第三方依赖,被 Shade 后打包到了 FAT JAR 中。

Flink CDC 的版本管理可能会导致代码与 JAR 包之间的差异。例如: - SNAPSHOT 版本:如果您使用的是 SNAPSHOT 版本(如 flink-sql-connector-mysql-cdc-2.2-SNAPSHOT.jar),这些版本对应的是开发分支的代码,可能与正式发布的代码库不一致。 - 稳定版本:建议优先使用稳定版本(如 flink-sql-connector-mysql-cdc-2.1.0.jar),因为这些版本的代码和 JAR 包是一致的。

此外,从 Flink CDC 2.0.0 开始,Group ID 从 com.alibaba.ververica 改为 com.ververica,这可能导致您在 Maven 仓库中找不到某些版本的包。

针对上述问题,您可以采取以下措施:

flink-sql-connector-xxx.jar),请确认该类是否属于第三方依赖。如果是,则无需在代码库中查找。flink-connector-xxx.jar),需要手动管理依赖,并确保所有依赖的版本兼容。pipeline.classpaths 配置指定 JAR 包路径,确保运行时能够加载所需的类。例如:

Configuration conf = new Configuration();

conf.setString("pipeline.classpaths", "file:///path/to/your-jar.jar");

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment(conf);

注意:该配置仅用于本地调试,在上传到阿里云实时计算 Flink 版之前需要删除。

ClassCastException 或 NoSuchMethodError 等异常。建议使用 provided 作用域管理依赖,并通过 classloader.parent-first-patterns.additional 配置解决冲突。通过以上分析,您可以更好地理解代码与 JAR 包之间的差异,并采取适当的措施解决问题。如果仍有疑问,可以提供更多上下文信息以便进一步分析。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。