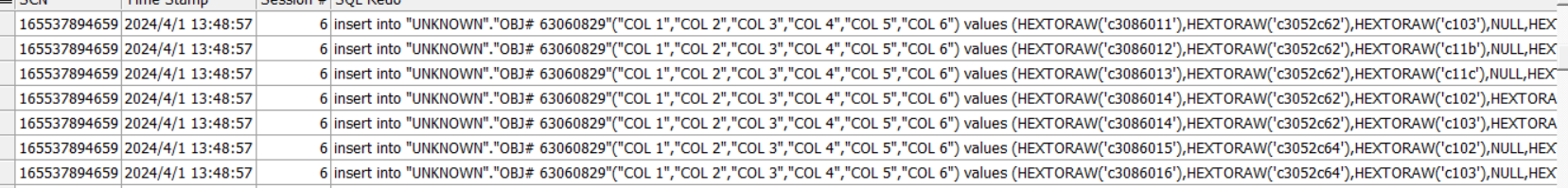

Flink CDC里启用cdc同步之后,出现大量的归档日志,查内容是有一个写入动作,不知啥原因? 还有flinkcdc2.0解决了启动时锁表的问题,我的代码中如何使用flinkcdc2.0呢?归档一会就爆了,几十个G。

还有flinkcdc2.0解决了启动时锁表的问题,我的代码中如何使用flinkcdc2.0呢?归档一会就爆了,几十个G。

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在使用Flink CDC进行数据同步时,如果出现大量的归档日志(如几十GB),可能的原因包括以下几点:

全量阶段并发读取导致日志膨胀

Flink CDC在全量阶段会并发读取MySQL的全量数据,并将这些数据写入下游系统。如果表的数据量较大且并发度较高,可能会导致短时间内生成大量日志。

Checkpoint间隔设置不合理

如果Checkpoint间隔时间过长,可能导致全量阶段的数据未能及时写入下游,从而堆积在内存或磁盘中,进一步增加日志量。

下游系统处理能力不足

如果下游系统的写入性能较低(如Hologres、Kafka等),可能导致数据积压,进而引发日志文件快速增长。

日志归档配置不当

如果未正确配置日志归档的有效期或存储大小限制,可能导致日志文件持续增长而未被清理。

优化全量阶段并发度

调整MySQL Source端的并发度,避免过高并发导致日志膨胀。可以通过以下参数控制并发度:

'scan.incremental.snapshot.chunk-key-column' = 'id', -- 指定分片键

'scan.incremental.snapshot.backfill.concurrent-reader' = '4' -- 控制并发读取线程数

调整Checkpoint间隔

设置合理的Checkpoint间隔时间,确保全量数据能够及时写入下游。例如:

env.enableCheckpointing(60000); -- 每60秒触发一次Checkpoint

提升下游系统性能

确保下游系统(如Hologres、Kafka)的写入性能足够高,避免因反压导致数据积压。

配置日志归档策略

在实时计算开发控制台中,开启日志归档功能并设置合理的有效期和大小限制。例如:

Flink CDC 2.0通过引入增量快照算法解决了启动时锁表的问题。增量快照算法允许在全量阶段并发读取数据,而无需对表加锁。以下是使用Flink CDC 2.0的具体步骤:

在Maven项目中添加Flink CDC 2.0的依赖。例如:

<dependency>

<groupId>com.ververica</groupId>

<artifactId>flink-connector-mysql-cdc</artifactId>

<version>2.0.0</version>

</dependency>

在SQL作业中定义MySQL CDC源表,并启用增量快照算法。示例代码如下:

CREATE TABLE mysql_cdc_source (

id INT,

name STRING,

update_time TIMESTAMP(3),

PRIMARY KEY (id) NOT ENFORCED

) WITH (

'connector' = 'mysql-cdc',

'hostname' = 'your-mysql-host',

'port' = '3306',

'username' = 'your-username',

'password' = 'your-password',

'database-name' = 'your-database',

'table-name' = 'your-table',

'scan.incremental.snapshot.enabled' = 'true', -- 启用增量快照

'scan.incremental.snapshot.chunk-size' = '1000', -- 每个分片的大小

'scan.incremental.snapshot.chunk-key-column' = 'id' -- 指定分片键

);

为了减少全量阶段的日志量,可以调整以下参数: - scan.incremental.snapshot.chunk-size:控制每个分片的大小,默认为1000。 - scan.incremental.snapshot.backfill.concurrent-reader:控制并发读取线程数。

Flink CDC 2.0会在全量读取完成后自动切换到增量读取阶段,无需手动干预。确保MySQL的Binlog保留时间足够长,以避免数据丢失。例如:

SET GLOBAL expire_logs_days = 7; -- 设置Binlog保留时间为7天

如果归档日志在短时间内快速增长,可以采取以下措施:

限制日志输出级别

在实时计算开发控制台中,配置日志输出级别为ERROR或WARN,减少不必要的日志记录。例如:

<Logger level="ERROR" name="org.apache.flink.runtime"/>

配置外部存储

将日志输出到外部存储(如OSS、SLS或Kafka),避免本地磁盘空间被占满。具体配置方法请参考《配置作业日志输出》文档。

定期清理日志

设置日志归档的有效期或大小限制,确保旧日志能够被自动清理。例如:

监控日志增长

使用阿里云SLS或其他监控工具,实时监控日志文件的增长情况,及时发现异常。

通过以上措施,您可以有效解决Flink CDC同步过程中产生的大量归档日志问题,并利用Flink CDC 2.0的增量快照算法避免锁表问题。建议根据实际业务需求调整并发度、Checkpoint间隔和日志归档策略,以优化性能和资源利用率。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。