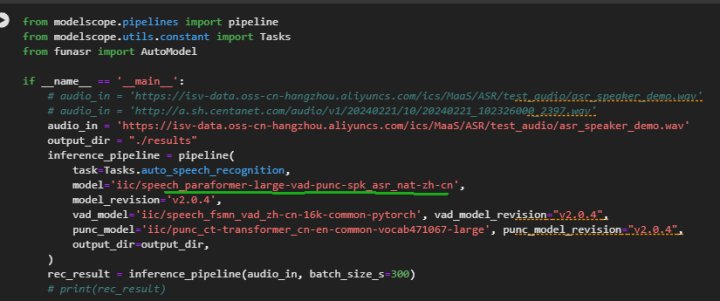

modelscope-funasr这个语音分角色识别的例子(官网提供的)解析出来的角色人对话不全,是哪里参数没设置对吗?

在使用 modelscope-funasr 进行语音分角色识别时,如果解析出来的角色对话不全,可能是由于以下几个关键参数未正确设置或功能限制导致的。以下是详细分析和解决建议:

根据知识库资料,实时语音识别可以通过设置 Transcription.DiarizationEnabled 参数为 true 来开启说话人分离功能。如果该参数未启用,系统将不会尝试区分不同说话人的角色。

解决方法: 确保在调用模型时设置了以下参数:

"Transcription.DiarizationEnabled": true

即使启用了说话人分离功能,如果未正确配置说话人数(Transcription.Diarization.SpeakerCount),可能会导致角色区分不准确或对话内容不全。

解决方法: - 如果明确知道对话中参与的人数,可以设置具体的数字。例如,如果是两人对话,可设置为:

"Transcription.Diarization.SpeakerCount": 2

0,表示系统会自动判断不定人数的对话场景。根据知识库资料,目前仅支持 8k 采样率单通道语音 的角色分离功能,并且需要通过设置 auto_split 参数为 true 来开启智能分轨。如果输入的语音文件不符合这些要求,可能导致角色识别不完整。

解决方法: - 确保输入的语音文件为 8k 采样率单通道 格式。 - 在参数中添加以下设置以启用智能分轨:

"auto_split": true

语音识别中的非人声噪音过滤阈值(取值范围:-1 ~ 1)可能会影响语音片段的判定。如果阈值设置不当,部分语音可能被误判为噪音而被过滤掉,从而导致对话内容不全。

解决方法: - 调整非人声噪音过滤阈值,使其更倾向于保留语音内容。例如,将阈值设置为接近 -1 的值:

"NonSpeechNoiseFilterThreshold": -0.5

语音识别中的最长静音时间(LongestSilenceDuration)和单句最长结束时间(MaxSentenceEndTime)参数也会影响语音分段和角色识别的完整性。

解决方法: - 确保静音时间设置合理,避免因静音间隔过长导致强制断句。例如:

"LongestSilenceDuration": 2000 // 单位为毫秒

"MaxSentenceEndTime": 10000 // 单位为毫秒

需要注意的是,当前的角色分离功能仍存在一些限制: - 无法定位具体角色的身份(如呼叫人或被呼叫人)。 - 16k 采样率的角色分离功能尚处于内测阶段,暂未对外开放。

解决方法: - 如果您的语音文件为 16k 采样率,建议先将其转换为 8k 采样率再进行处理。 - 持续关注官方更新,未来可能会提供更多功能支持。

请按照以下步骤逐一排查问题: 1. 确认启用了说话人分离功能(Transcription.DiarizationEnabled = true)。 2. 配置正确的说话人数(Transcription.Diarization.SpeakerCount)。 3. 确保语音文件为 8k 采样率单通道格式,并启用智能分轨(auto_split = true)。 4. 调整非人声噪音过滤阈值和静音时间参数,优化语音识别效果。 5. 注意当前功能的限制,必要时对语音文件进行预处理。

如果以上调整后问题仍未解决,建议联系技术支持团队进一步排查。