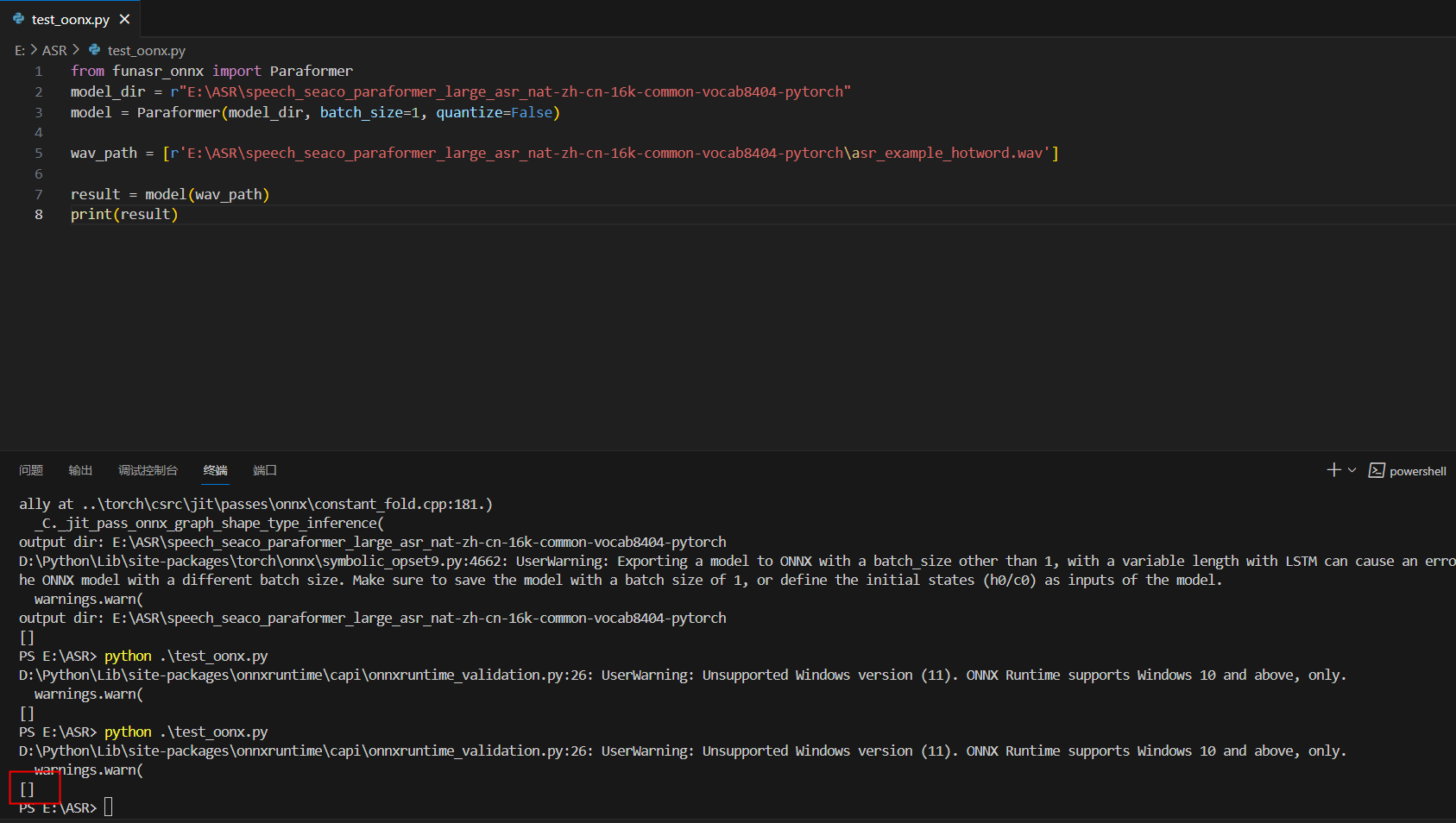

modelscope-funasr使用onnx模型时预测官方提供得wav语音片段,结果为什么是空的?

在win上用cpu推理,modelscope-funasr使用onnx模型时预测官方提供得wav语音片段,结果是空的,这是怎么回事?

展开

收起

阿里云 AI 助理回答

在 Windows 环境下使用 CPU 推理 ModelScope-FunASR 的 ONNX 模型时,如果预测官方提供的 WAV 语音片段结果为空,可能是由于以下几个原因导致的。以下是详细分析和解决方法:

1. 模型输入格式不匹配

ONNX 模型对输入数据的格式有严格要求,包括采样率、音频长度、特征维度等。如果输入的 WAV 文件未经过正确的预处理,可能会导致模型无法正确解析输入数据,从而输出空结果。

解决方法:

- 检查音频文件的采样率:确保输入的 WAV 文件采样率为模型支持的标准值(如 16kHz)。如果采样率不匹配,可以使用工具(如

ffmpeg或sox)进行重采样。ffmpeg -i input.wav -ar 16000 output.wav - 检查音频长度:某些模型可能对输入音频的长度有要求(如最小或最大长度限制)。如果音频过短或过长,需要裁剪或填充到合适长度。

- 确认特征提取是否正确:FunASR 模型通常需要将音频转换为声学特征(如 MFCC 或 FBank)。如果未正确提取特征,模型可能无法生成有效输出。可以参考 FunASR 官方文档中的特征提取流程。

2. ONNX 模型加载问题

在 Windows 环境下,ONNX 模型的加载可能受到环境配置的影响,例如依赖库版本不兼容或模型文件损坏。

解决方法:

- 验证 ONNX 模型文件完整性:确保下载的 ONNX 模型文件未损坏,并与官方提供的版本一致。

- 检查依赖库版本:确保安装的

onnxruntime版本与模型兼容。建议使用以下命令安装最新版本:pip install onnxruntime -

测试模型加载:在 Python 中单独加载 ONNX 模型并运行简单的推理测试,确认模型加载无误:

import onnxruntime as ort import numpy as np # 加载模型 session = ort.InferenceSession("model.onnx") input_name = session.get_inputs()[0].name # 构造随机输入数据 dummy_input = np.random.randn(1, 80, 100).astype(np.float32) # 示例输入形状 outputs = session.run(None, {input_name: dummy_input}) print(outputs)

3. 推理代码逻辑问题

推理代码中可能存在逻辑错误,例如未正确传递输入数据或未处理模型输出。

解决方法:

- 检查输入数据格式:确保输入数据的形状和类型符合模型要求。例如,某些模型可能需要输入形状为

(batch_size, feature_dim, time_steps)的张量。 - 调试输出结果:在推理代码中打印模型的输出,确认是否为空或异常。例如:

outputs = session.run(None, {input_name: input_data}) print("Model Output:", outputs) - 参考官方示例代码:确保推理代码与官方提供的示例代码一致。如果官方未提供 Windows 平台的示例代码,可以尝试在 Linux 环境下运行以排除平台相关问题。

4. 环境配置问题

Windows 环境下的某些配置可能导致推理失败,例如缺少必要的依赖库或权限问题。

解决方法:

- 安装依赖库:确保所有依赖库已正确安装,包括

numpy、soundfile等。可以通过以下命令安装:pip install -r requirements.txt - 检查 Python 版本:FunASR 和 ONNX Runtime 通常要求 Python 3.7 或更高版本。请确保您的 Python 版本满足要求。

- 运行权限:确保当前用户对模型文件和音频文件具有读取权限。

5. 其他可能的原因

如果以上方法均未解决问题,可能是模型本身或推理框架存在兼容性问题。

解决方法:

- 尝试其他推理框架:如果 ONNX Runtime 在 Windows 上存在问题,可以尝试使用 PyTorch 直接加载模型进行推理。

- 联系技术支持:如果问题仍然存在,建议联系阿里云技术支持团队,提供详细的错误日志和复现步骤。

总结

通过以上分析,您可以按照以下步骤排查问题: 1. 确保输入音频文件的格式和内容符合模型要求。 2. 验证 ONNX 模型文件的完整性和加载过程。 3. 检查推理代码逻辑,确保输入数据和输出处理正确。 4. 确认环境配置无误,包括依赖库和权限设置。

如果问题仍未解决,请提供更多上下文信息(如错误日志、代码片段),以便进一步分析。

有帮助

无帮助

AI 助理回答生成答案可能存在不准确,仅供参考

相关问答

相关文章

热门讨论

热门文章

展开全部

展开全部

还有其他疑问?

咨询AI助理