modelscope-funasr这个目录源码里面有,是要把源码在服务器放一份吗?

在部署模型或相关服务时,是否需要将modelscope-funasr目录的源码放置在服务器上,取决于具体的使用场景和部署需求。以下是详细的分析和操作建议:

modelscope-funasr目录中的源码通常包含模型的实现代码、配置文件以及相关的依赖项。如果您的目标是运行或调试该模型,则需要将源码放置在服务器上。

- 如果您仅需使用预训练模型进行推理,而不需要修改源码,可以直接下载模型文件并加载到推理环境中。 - 如果您需要对模型进行二次开发、调试或训练,则必须将源码放置在服务器上。

如果确定需要将modelscope-funasr源码放置在服务器上,请按照以下步骤操作:

通过git clone命令将源码从远程仓库克隆到服务器:

git clone https://github.com/modelscope/modelscope-funasr.git

说明:

- 确保服务器已安装git工具。如果未安装,可以通过以下命令安装:

sudo yum install -y git

tmux会话中执行克隆操作,以避免因网络中断导致克隆失败。克隆完成后,进入源码目录并检查文件是否完整:

cd modelscope-funasr

ls -l

确保关键文件(如模型配置文件、脚本文件等)存在。

根据源码中的requirements.txt或其他依赖管理文件,安装所需的依赖项:

pip install -r requirements.txt

重要提示:

- 确保服务器上的Python版本符合依赖项的要求。如果需要升级Python版本,请参考相关文档。 - 如果依赖项较多,建议使用虚拟环境(如venv或conda)隔离环境,避免与其他项目冲突。

部分模型的源码可能不包含预训练模型文件,而是通过脚本动态下载。如果modelscope-funasr源码中没有预训练模型文件,请按照以下步骤操作:

MODEL_NAME="modelscope-funasr"

LOCAL_SAVE_PATH="/mnt/models"

sudo mkdir -p ${LOCAL_SAVE_PATH}

sudo chmod ugo+rw ${LOCAL_SAVE_PATH}

使用Docker容器或其他方式下载模型文件:

sudo docker run -d -t --network=host --rm \

-v ${LOCAL_SAVE_PATH}:/data \

egs-registry.cn-hangzhou.cr.aliyuncs.com/egs/vllm:0.6.4.post1-pytorch2.5.1-cuda12.4-ubuntu22.04 \

/bin/bash -c "git-lfs clone https://www.modelscope.cn/models/${MODEL_NAME}.git /data"

说明:

- 下载过程中可以使用sudo docker logs -f download实时监控进度。 - 确保服务器有足够的磁盘空间存储模型文件。

在完成源码和模型文件的准备后,需要配置运行环境以支持模型的加载和推理。

根据硬件平台的要求,显式设置必要的环境变量。例如:

export OMP_NUM_THREADS=$(nproc -all)

export GOMP_CPU_AFFINITY=0-$(( $(nproc -all) - 1 ))

说明:

- 上述命令适用于AMD CPU实例。如果是GPU实例,请参考相关文档配置CUDA环境。

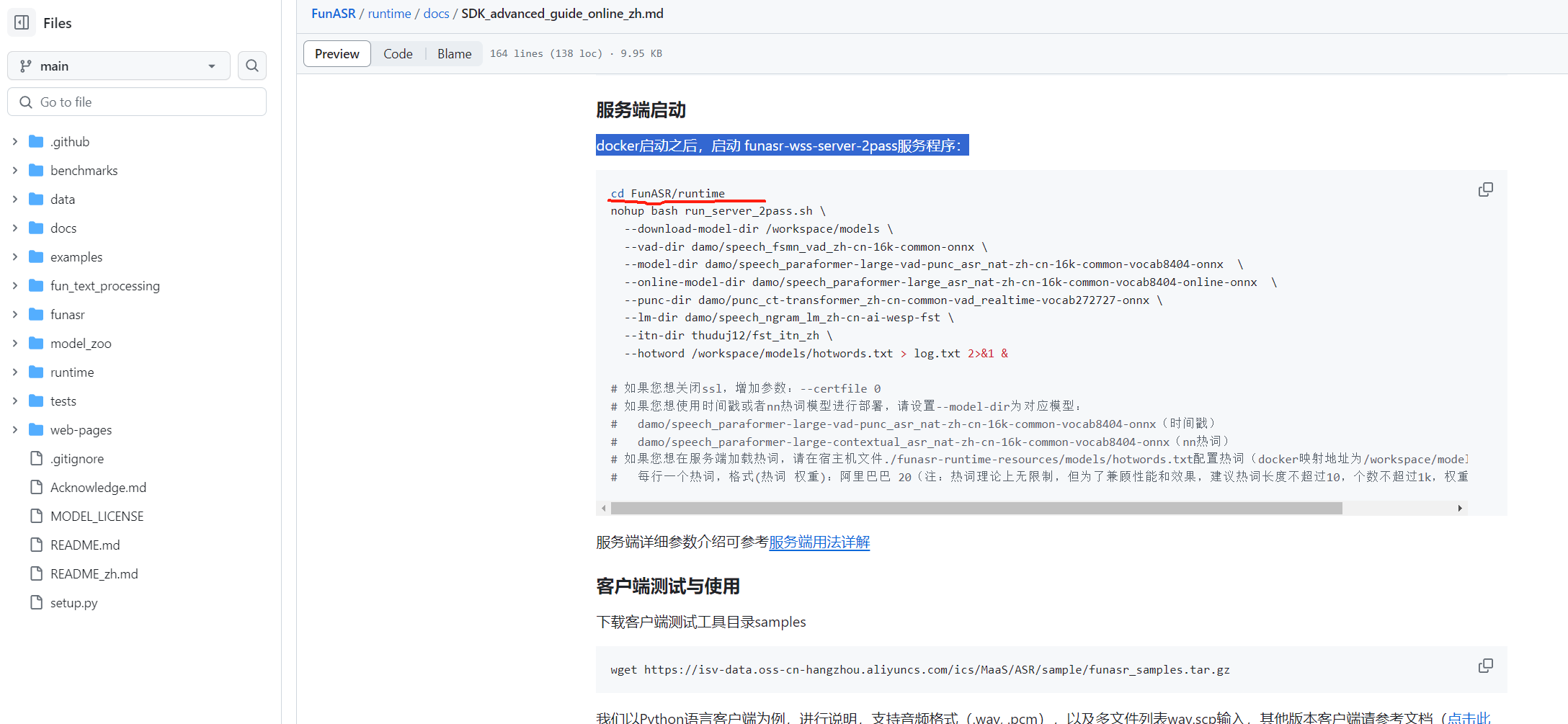

根据源码中的启动脚本或文档,启动模型服务。例如:

python serve.py --model_path /mnt/models/modelscope-funasr

通过以上步骤,您可以成功将modelscope-funasr源码放置在服务器上,并完成相关配置。如果有进一步的需求或问题,请提供更多上下文信息以便更精确地解答。