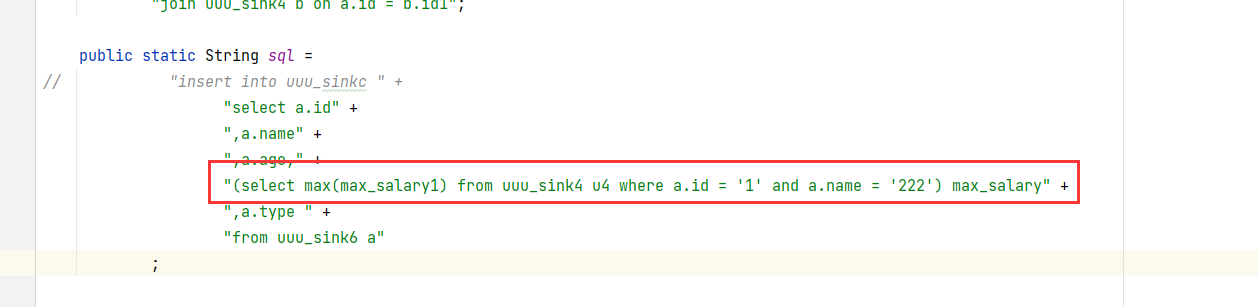

Flink CDC里这种写法 怎么修改一下?

Flink CDC里这种写法 怎么修改一下?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在 Flink CDC 中,您提到的写法需要根据具体的场景和需求进行调整。以下是针对常见问题和配置的详细说明及修改建议:

1. 重复事件处理

如果您的作业在故障恢复时可能会遇到重复的变更事件(例如 Maxwell、Canal 或 Debezium 投递的事件),可以通过以下方式解决:

- 设置参数:将作业参数

table.exec.source.cdc-events-duplicate设置为true。 - 定义主键:确保源表上定义了

PRIMARY KEY,以便 Flink 系统生成一个额外的有状态算子,使用主键对变更事件去重并生成规范化的 changelog 流。

示例:

CREATE TABLE source_table (

user_id BIGINT,

item_id BIGINT,

behavior STRING,

PRIMARY KEY (user_id) NOT ENFORCED

) WITH (

'connector' = 'kafka',

'topic' = 'user_behavior',

'properties.bootstrap.servers' = 'localhost:9092',

'value.format' = 'canal-json',

'table.exec.source.cdc-events-duplicate' = 'true'

);

2. 元数据字段的使用

如果您需要在表中使用元数据字段(如 origin_database、origin_table 等),可以通过 METADATA 关键字声明这些字段,并将其映射到对应的元数据路径。

示例:

CREATE TABLE source_table (

origin_database STRING METADATA FROM 'value.database' VIRTUAL,

origin_table STRING METADATA FROM 'value.table' VIRTUAL,

origin_ts TIMESTAMP(3) METADATA FROM 'value.ingestion-timestamp' VIRTUAL,

user_id BIGINT,

item_id BIGINT,

behavior STRING

) WITH (

'connector' = 'kafka',

'topic' = 'user_behavior',

'properties.bootstrap.servers' = 'localhost:9092',

'value.format' = 'canal-json'

);

注意:元数据字段是虚拟列,不会存储在物理表中,但可以在查询中使用。

3. 全增量一体消费模式

如果您希望实现全量和增量数据的一体化消费(例如 Hologres 的 Binlog 消费),可以启用 cdcMode 参数,并确保目标表有主键。

示例:

CREATE TABLE hologres_source_table (

id INTEGER,

title VARCHAR,

body VARCHAR

) WITH (

'connector' = 'hologres',

'dbname' = '<yourDbname>',

'tablename' = '<yourTablename>',

'username' = '<yourAccessID>',

'password' = '<yourAccessSecret>',

'endpoint' = '<yourEndpoint>',

'binlog' = 'true',

'cdcMode' = 'true',

'binlogMaxRetryTimes' = '10',

'binlogRetryIntervalMs' = '500',

'binlogBatchReadSize' = '100'

);

适用场景: - 历史数据不包含 Binlog,但需要消费所有数据。 - 目标表必须有主键,推荐在 CDC 模式下使用。

4. Debezium 数据解析问题

如果您使用 Debezium PostgreSQL Connector 捕获变更数据,请确保被监控表的 REPLICA IDENTITY 已被配置为 FULL,否则 Flink SQL 可能无法正确解析数据。

解决方法:

ALTER TABLE <your-table-name> REPLICA IDENTITY FULL;

说明:当 REPLICA IDENTITY 配置为 FULL 时,更新和删除事件将包含所有列的完整值;否则,before 字段可能只包含主键字段或为空。

5. Schema 兼容性变更

如果需要对表结构进行变更(如新增字段或修改字段),请确保变更属于兼容性变更,以避免影响下游算子。

- 完全兼容变更:新增字段且下游未使用该字段。

- 部分兼容变更:修改字段逻辑,但不影响下游计算结果。

- 不兼容变更:修改连接器类型或表名。

示例:

-- 原始表结构

CREATE TABLE MyTable (

a INT,

b BIGINT,

c VARCHAR

) WITH ('connector' = 'datagen');

-- 新增字段 d(完全兼容)

CREATE TABLE MyTable (

a INT,

b BIGINT,

c VARCHAR,

d INT

) WITH ('connector' = 'datagen');

注意:修改主键或分片列可能导致状态不兼容,需谨慎操作。

6. 自定义连接器

如果您需要使用自定义连接器(如社区版 SQL Server CDC 连接器),可以按照以下步骤操作:

- 克隆 GitHub 仓库并切换到指定版本分支。

- 修改连接器工厂类的标识符(

factoryIdentifier)。 - 编译打包子模块。

- 在 Flink 开发控制台上传 JAR 文件并创建自定义连接器。

- 在 SQL 作业中使用自定义连接器名称。

示例:

@Override

public String factoryIdentifier() {

return "sqlserver-cdc-test";

}

SQL 作业中引用:

CREATE TABLE source_table (

...

) WITH (

'connector' = 'sqlserver-cdc-test',

...

);

重要:区分 flink-connector-xxx 和 flink-sql-connector-xxx,根据需求选择合适的依赖。

通过以上修改和配置,您可以根据具体需求优化 Flink CDC 的写法。如果有进一步的问题或特定场景的需求,请提供更多细节以便更精确地解答。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。