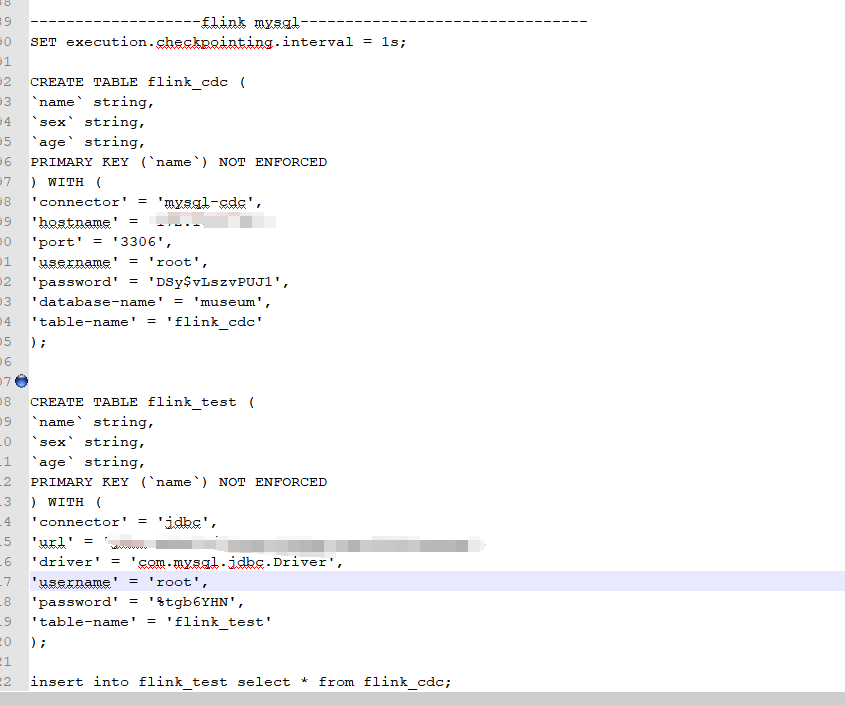

我在flink sql client 执行这个代码 同步只会执行一次 修改源表数据后 目标表没有发生变化?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在使用Flink SQL Client执行同步代码时,如果发现修改源表数据后目标表没有发生变化,可能是由于以下原因导致的。以下是详细分析和解决方案:

Flink默认以批模式读取源表数据,这意味着它只会一次性读取源表的当前快照数据,而不会实时消费后续的数据变更。

需要通过Table Hint方式将源表的读取模式更改为流模式,确保能够实时消费源表的增量数据(如Binlog)。具体操作如下:

INSERT INTO target_table

SELECT

col1,

col2,

col3

FROM source_table /*+ OPTIONS('binlog'='true') */;

说明:/*+ OPTIONS('binlog'='true') */ 参数会启用Binlog模式,使Flink能够实时消费源表的增量数据。

如果源表的Schema发生了变更(例如新增列、修改列类型等),但目标表未同步更新,可能是因为CTAS作业无法自动感知Schema变更。

手动删除目标表并重启作业:

启用宽容模式(仅适用于Hologres):

CREATE TABLE IF NOT EXISTS target_table

WITH ('tolerance.mode'='true')

AS TABLE source_table;

如果您的SQL中涉及维表JOIN操作,需要注意维表JOIN的行为特点: - 维表JOIN仅支持对当前时刻维表快照的关联。 - 如果JOIN行为发生后,维表中的数据发生了变化(新增、更新或删除),已关联的维表数据不会被同步更新。

如果源表是基于CDC(Change Data Capture)机制同步数据,可能存在以下问题: - CDC配置不正确,导致增量数据未被捕获。 - 源表的增量数据未触发Flink的消费逻辑。

server-id范围是否合理。某些目标表(如Hologres)可能需要额外配置才能支持实时写入。

mutatetype参数来支持插入或更新操作:

WITH (

'connector' = 'hologres',

'mutatetype' = 'insertorupdate'

);

根据上述分析,您可以按照以下步骤排查和解决问题: 1. 确认源表是否启用了Binlog模式,并在SQL中添加/*+ OPTIONS('binlog'='true') */参数。 2. 检查CTAS作业是否支持实时Schema变更,必要时手动删除目标表并重启作业。 3. 如果涉及维表JOIN,确保维表数据在JOIN前已经是最新的。 4. 检查CDC配置是否正确,确保增量数据能够被捕获。 5. 确认目标表的写入模式是否支持实时更新。

通过以上步骤,您应该能够解决目标表未同步更新的问题。如果问题仍然存在,请提供更多上下文信息以便进一步分析。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。