大数据计算MaxCompute odps节点insert overwri table 后面提示了shell run successfully,但是数据没有插入进表是怎么回事?

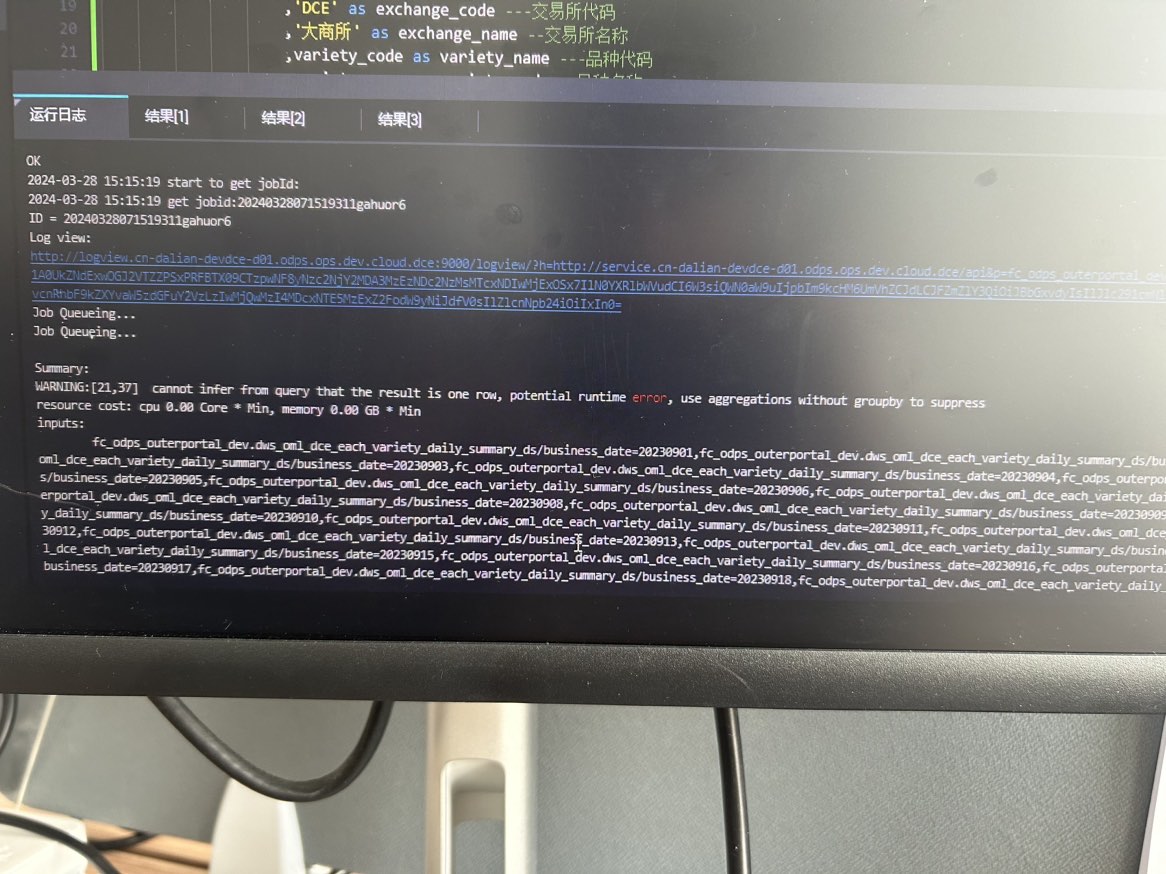

中间提示了这个error

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在MaxCompute中,执行INSERT OVERWRITE操作时,虽然Shell提示运行成功,但数据未插入目标表的情况可能由以下原因导致。以下是详细分析及解决方案:

INSERT OVERWRITE操作要求SELECT语句的字段与目标表的字段完全匹配,包括字段顺序、类型和数量。如果字段不匹配,可能会导致数据未正确写入。

Table xxx has n columns, but query has m columns的错误。SELECT语句返回的字段与目标表的字段一致。NULL),可以在SELECT语句中显式指定。例如:INSERT OVERWRITE TABLE target_table

SELECT col1, NULL, col3 FROM source_table;

如果目标表是分区表,且INSERT OVERWRITE操作涉及动态分区,可能会因分区数量过多而失败。

a single instance cannot output data to more than 10000 partitions。如果目标表是OSS外部表,可能存在极端情况下数据未成功写入的问题。

INSERT OVERWRITE操作前,备份OSS中的旧数据。odps.sql.unstructured.oss.commit.mode属性为true,启用两阶段提交机制:SET odps.sql.unstructured.oss.commit.mode = true;

如果使用ODPS Script节点执行INSERT OVERWRITE操作,需注意脚本模式的限制。

@a := SELECT * FROM src WHERE key > 0;

INSERT OVERWRITE TABLE src2 SELECT * FROM @a;

SELECT * FROM @a;

如果目标表是事务性表,可能会因无法获取独占锁而导致写入失败。

Transaction timeout because cannot acquire exclusive lock。在某些情况下,INSERT OVERWRITE操作可能因数据一致性问题导致失败。

.meta文件未正确生成或解析,导致数据被视为无效。.odps文件夹,确认是否存在.meta文件。.meta文件缺失或异常,重新执行INSERT OVERWRITE操作。 根据上述分析,您可以按照以下步骤排查问题: 1. 检查SELECT语句的字段是否与目标表字段匹配。 2. 确认目标表是否为分区表,并检查分区数量是否超出限制。 3. 如果目标表是OSS外部表,检查是否启用了分片上传功能,并做好数据备份。 4. 检查脚本模式中是否存在先写后读的操作。 5. 确认目标表是否为事务性表,并检查是否有其他作业占用锁。 6. 检查目标表目录下的.meta文件,确保数据一致性。

如果问题仍未解决,请提供具体的错误日志或上下文信息,以便进一步分析。

MaxCompute(原ODPS)是一项面向分析的大数据计算服务,它以Serverless架构提供快速、全托管的在线数据仓库服务,消除传统数据平台在资源扩展性和弹性方面的限制,最小化用户运维投入,使您经济并高效的分析处理海量数据。