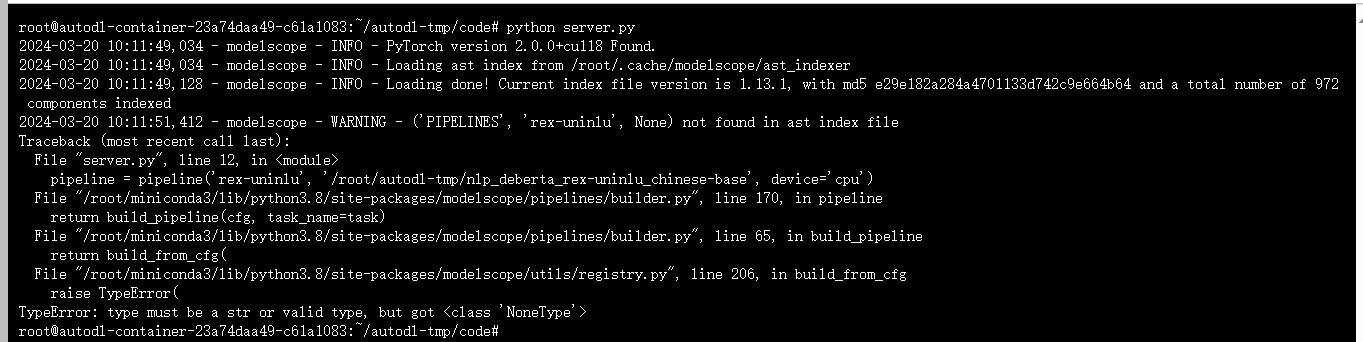

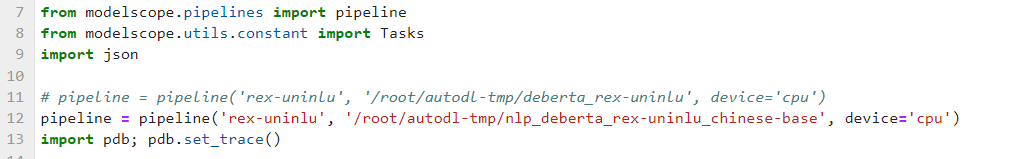

在微调RexUniNLU零样本通用自然语言理解-中文-base任务后,如果ModelScope模型无法调用,可能是由于以下几个原因造成的:

- 微调模型路径问题:确保您知道微调后模型文件的确切位置,并且路径设置正确。如果路径不正确或者模型文件没有保存在预期的位置,系统将无法找到模型进行加载和调用。

- **模型失败。例如,RoPE插值可以扩展LLaMA模型的上下文长度,如果在微调时使用了特定的参数(如

linear),则在推理时也需要设置为相应的参数。 - 训练配置错误:在微调模型时,可能会遇到配置错误,比如

num_labels不匹配的问题。这可能是由于读取本地模型时的配置不当,或者是训练过程中的某些设置与仓库模型不一致。 - 接口使用不当:ModelScope提供了统一的使用接口,包括pipeline进行模型推理和Trainer进行微调。如果在使用这些接口时没有按照正确的方式加载模型或设置了错误的参数,也可能导致模型调用失败。

- 环境问题:确保您的运行环境与ModelScope平台的要求相匹配,包括Python版本、依赖库等。环境不兼容可能会导致模型无法正常加载或运行。

- 平台问题:有时候,ModelScope平台本身可能存在一些问题,比如服务不稳定、API更新等,这些都可能影响到模型的调用。

为了解决这个问题,您可以尝试以下步骤:

- 检查微调模型的保存路径是否正确,并确保模型文件完整无误。

- 确认微调过程中的参数设置是否与推理时的设置一致。

- 回顾微调过程中的配置,确保所有设置都是正确的,并与原始模型或仓库模型保持一致。

- 仔细阅读ModelScope的官方文档,确保您正确地使用了pipeline和Trainer接口。

- 检查并更新您的运行环境,确保它符合ModelScope平台的要求。

- 如果以上步骤都无法解决问题,建议联系ModelScope的客户支持或技术团队寻求帮助。

总的来说,微调后的模型无法调用可能是由于多种因素导致的,需要逐一排查并解决。