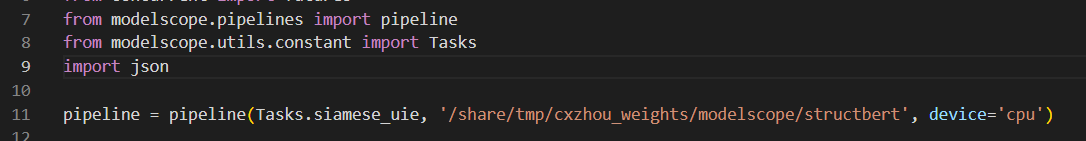

"之前任务中使用的SiameseUniNLU模型,为什么ModelScope已经指定device是cpu但现在跑起来仍然报错cuda呢?

"

根据您提供的问题描述,尽管在ModelScope中已经明确指定了device为cpu,但任务运行时仍然报错与cuda相关的问题。以下是可能的原因分析及解决方案:

某些模型代码中可能会直接硬编码使用cuda()或.to('cuda'),而未充分考虑用户指定的设备参数。这种情况下,即使您在ModelScope中指定了device=cpu,模型内部仍可能尝试将数据或模型加载到GPU上。

解决方法: - 检查模型代码,确保所有设备相关的操作(如.to(device)或.cuda())都动态依赖于用户传入的device参数。 - 如果您无法直接修改模型代码,可以通过设置环境变量强制禁用CUDA:

export CUDA_VISIBLE_DEVICES=""

这将隐藏所有可用的GPU设备,从而强制模型运行在CPU上。

如果模型本身支持CPU运行,但数据加载器或输入数据未正确指定设备,也可能导致错误。例如,输入数据可能被默认加载到GPU上,而模型却运行在CPU上,这会导致设备不匹配的错误。

解决方法: - 确保输入数据在传递给模型之前已正确转移到指定设备。例如:

inputs, labels = data[0].to(device='cpu'), data[1].to(device='cpu')

DataLoader,请检查是否启用了pin_memory=True或non_blocking=True等选项。这些选项通常用于优化GPU性能,但在纯CPU环境下可能导致冲突。建议关闭这些选项以避免潜在问题。某些第三方库(如transformers、torch等)可能在初始化时默认尝试使用CUDA,即使您指定了device=cpu。这种行为通常由库的全局配置或环境变量控制。

解决方法: - 在代码运行前,显式设置PyTorch的设备为CPU:

import torch

torch.cuda.is_available = lambda: False

这将强制PyTorch认为CUDA不可用,从而避免任何与CUDA相关的操作。 - 检查是否有其他依赖库默认启用了CUDA,并根据其文档调整相关配置。

在ModelScope的服务部署过程中,某些镜像或运行命令可能默认启用了CUDA支持。例如,镜像中可能预装了CUDA驱动或相关库,导致模型运行时自动尝试使用GPU。

解决方法: - 检查ModelScope服务的镜像配置,确保使用的镜像不包含不必要的CUDA依赖。 - 如果您使用的是自定义镜像,请确认镜像中未安装CUDA相关组件。 - 在部署服务时,通过环境变量明确禁用CUDA:

ENV CUDA_VISIBLE_DEVICES=""

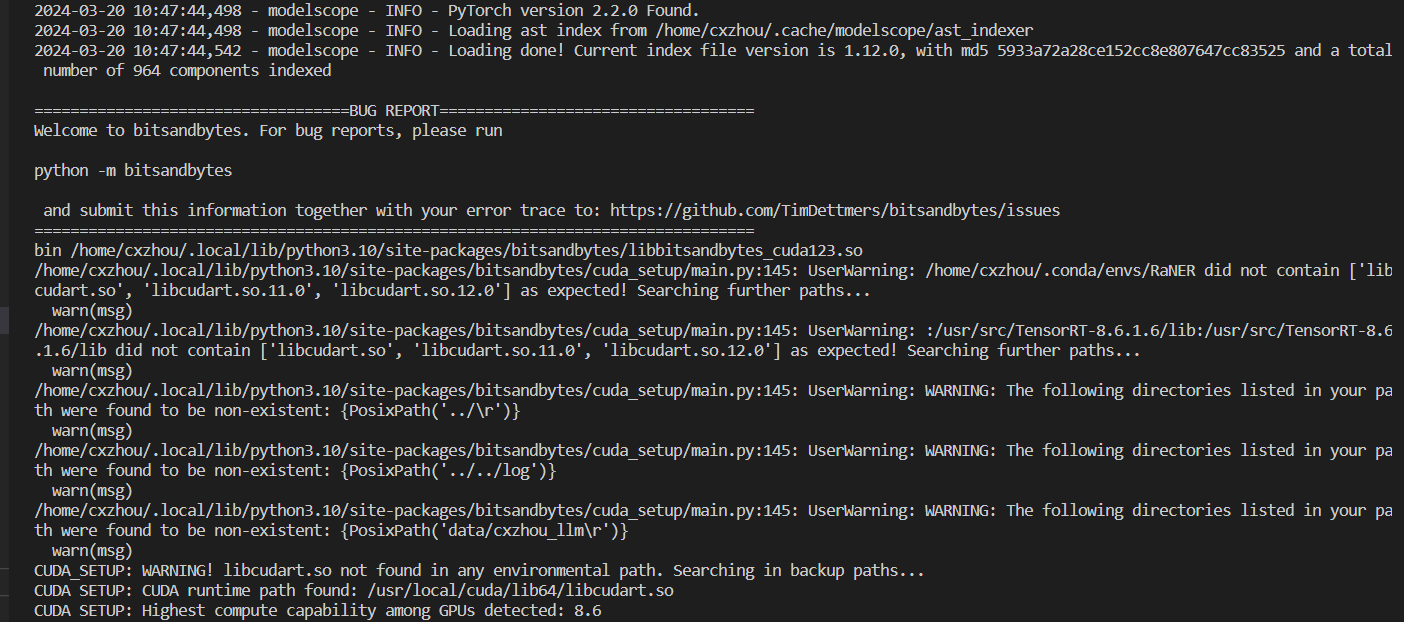

为了更准确地定位问题,请提供具体的报错信息。例如,报错中是否提到以下内容: - RuntimeError: CUDA out of memory:可能是模型尝试分配GPU内存失败。 - AssertionError: Torch not compiled with CUDA enabled:可能是PyTorch未正确编译CUDA支持。 - 其他与设备相关的错误。

根据具体的报错信息,可以更有针对性地解决问题。

综上所述,问题的根本原因可能在于模型代码、数据加载器、第三方库或服务配置中存在隐式的CUDA依赖。建议按照以下步骤逐一排查: 1. 检查模型代码,确保设备操作动态依赖于用户指定的device参数。 2. 确保输入数据和数据加载器未默认使用CUDA。 3. 强制禁用CUDA,通过设置环境变量CUDA_VISIBLE_DEVICES=""或修改PyTorch的全局配置。 4. 检查ModelScope服务的镜像和运行命令,确保未引入不必要的CUDA依赖。 5. 提供具体的报错信息以便进一步分析。

如果问题仍未解决,请提供更多上下文信息(如完整的报错日志、模型代码片段等),以便更深入地诊断问题。您可以复制页面截图提供更多信息,我可以进一步帮您分析问题原因。

ModelScope旨在打造下一代开源的模型即服务共享平台,为泛AI开发者提供灵活、易用、低成本的一站式模型服务产品,让模型应用更简单!欢迎加入技术交流群:微信公众号:魔搭ModelScope社区,钉钉答疑群:44837352