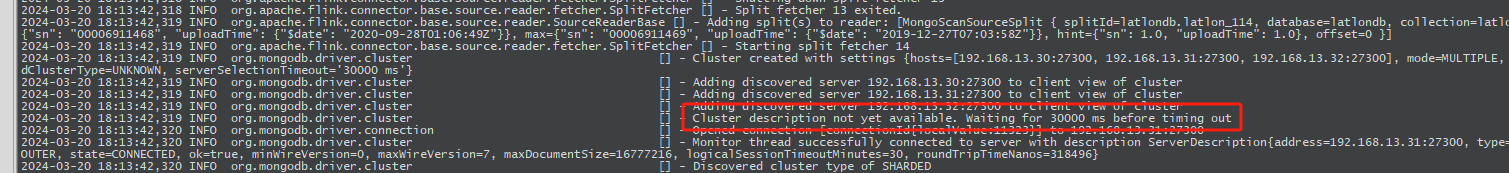

Flink CDC里发现是集群看起来有超时,但通过客户端连 怎么连都是正常的是怎么回事?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在使用Flink CDC时,如果发现Flink集群看起来有超时问题,但通过客户端连接Kafka或数据库(如MySQL、Postgres等)时一切正常,可能是由于以下原因导致的。以下是详细分析和解决方法:

尽管客户端能够正常连接到Kafka或数据库,但这并不意味着Flink集群与这些服务之间的网络是完全连通的。Flink作业运行在分布式环境中,可能涉及多个节点,而这些节点的网络配置可能与客户端不同。

确认Flink集群与Kafka/数据库的网络连通性

使用Flink控制台的网络探测功能,测试Flink作业运行环境与Kafka或数据库的连通性。具体操作如下:

检查Kafka Broker的元信息

如果使用Kafka作为数据源,确保Kafka Broker返回的advertised.listeners地址对Flink集群是可达的。可以通过以下步骤验证:

zkCli.sh)登录到Kafka使用的Zookeeper集群。get /brokers/ids/{broker_id}命令,查看endpoints字段中的地址。ping或telnet测试这些地址是否可以从Flink集群访问。跨VPC或公网访问

如果Kafka或数据库与Flink集群不在同一VPC下,需要配置跨VPC访问或公网访问。可以通过阿里云NAT网关实现VPC与公网的连通。

Flink CDC连接器默认的连接超时时间可能不足以应对复杂的网络环境,尤其是在跨VPC或公网访问时。

WITH参数中增加connect.timeout的值。例如:

'connect.timeout' = '60s'

默认值为30秒,建议根据实际网络延迟调整为更大的值。

即使Flink与Kafka之间的网络是连通的,仍然可能出现timeout expired while fetching topic metadata的错误。这通常是因为Kafka Broker在bootstrap过程中返回的集群元信息中包含不可达的Endpoint。

listener_security_protocol_map中配置的Endpoint是否对Flink集群可达。Flink CDC依赖Checkpoint机制来保证数据一致性。如果Checkpoint配置不合理,可能导致作业在增量阶段频繁失败。

调整Checkpoint间隔时间

增大execution.checkpointing.interval的值,避免过于频繁的Checkpoint导致资源耗尽。例如:

execution.checkpointing.interval: 10min

容忍Checkpoint失败次数

增大execution.checkpointing.tolerable-failed-checkpoints的值,以应对网络波动或临时性故障。例如:

execution.checkpointing.tolerable-failed-checkpoints: 100

重启策略

配置合理的重启策略,例如固定延迟重启策略:

restart-strategy: fixed-delay

restart-strategy.fixed-delay.attempts: 2147483647

如果使用MySQL CDC,即使实际数据更新量不大,Flink CDC仍可能消耗大量带宽。这是因为MySQL的Binlog是实例级别的,记录了所有数据库和表的变更。

启用CDC Source复用

通过复用CDC Source,减少重复读取Binlog带来的带宽消耗。

过滤不必要的表

在Flink CDC连接器中配置只读取特定表的变更记录,避免处理无关的Binlog数据。

如果Flink CDC读取的时间戳字段出现时区偏差(如相差8小时),可能是由于server-time-zone参数未正确配置。

'server-time-zone' = '+08:00'

确保该值与MySQL服务器的时区一致。

JobManager 心跳超时

如果配置了自建DNS域名解析,可能会导致JobManager心跳超时。解决方案是关闭TaskManager的主机名解析:

jobmanager.retrieve-taskmanager-hostname: false

Replication Slot 管理

如果使用Postgres CDC,确保及时清理不再使用的Replication Slot,避免磁盘空间浪费。

Flink CDC集群超时问题可能由多种因素引起,包括网络连通性、连接超时参数、Checkpoint配置、Binlog数据量、时区配置等。建议按照上述步骤逐一排查,并根据实际情况调整相关配置。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。