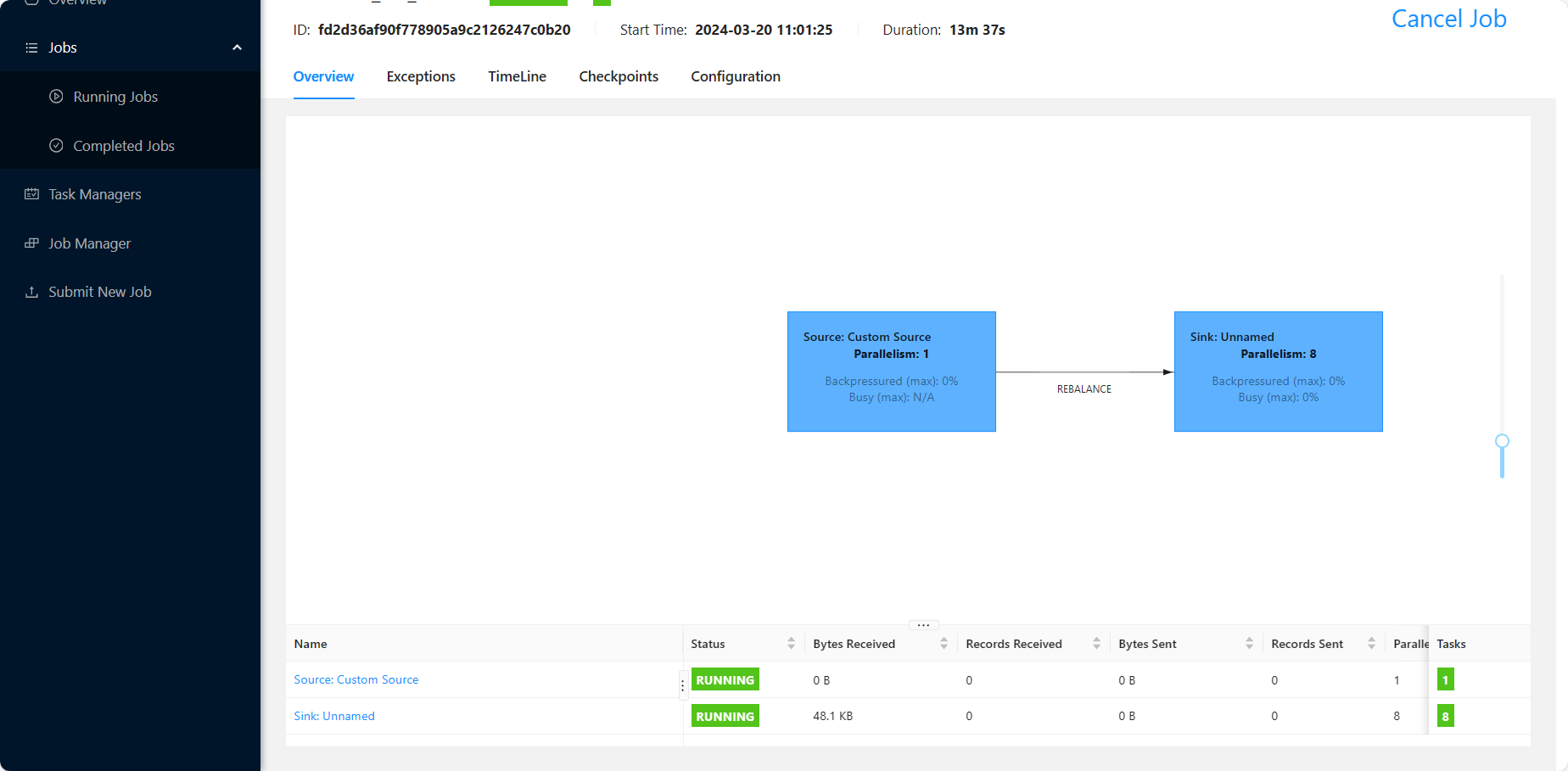

Flink CDC里我这数据一直写不进去是什么原因啊?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在使用Flink CDC时,数据无法写入下游可能由多种原因导致。以下是根据知识库资料总结的常见问题及其解决方案:

StarRocks等下游系统对数据类型有严格的限制。如果上游数据表中的字段类型与下游不兼容,可能导致写入失败。

DECIMAL 类型作为主键时,StarRocks 不支持将其直接映射为主键字段,会自动转换为 VARCHAR。Transform CAST 内置函数对不支持的数据类型进行转换。Projection 语句将不支持的字段从结果表中移除。MySQL CDC 源表的配置不当可能导致数据无法正确读取或写入。

scan.incremental.snapshot.chunk.size 参数以减少单个分片的数据量。Checkpoint 的间隔时间设置不当可能导致作业卡住或数据丢失。

下游系统的超时或资源限制可能导致写入失败。

table.schema-change.timeout 的限制(默认 30 分钟),作业将运行失败。table.schema-change.timeout 的值。Flink CDC 读取 Binlog 数据时,可能会因为网络或带宽问题导致数据传输延迟。

SET 'table.optimizer.source-merge.enabled' = 'true';

如果 Flink CDC 和 MySQL 服务器的时区配置不一致,可能导致时间戳字段写入错误。

server-time-zone 参数未与 MySQL 服务器时区一致。server-time-zone 参数与 MySQL 服务器时区一致。Flink CDC 作业失败后,默认会尝试重启,可能导致数据写入异常。

restart-strategy: fixed-delay

restart-strategy.fixed-delay.attempts: 2

restart-strategy.fixed-delay.delay: 10 s

如果两次重启均失败,作业将彻底退出。

currentEmitEventTimeLag 和 currentFetchEventTimeLag 指标。如果延时较大,说明作业可能存在拉取或处理数据的瓶颈。请根据上述问题逐一排查,重点关注数据类型匹配、MySQL CDC 配置、Checkpoint 设置、下游系统资源以及网络带宽等方面。如果问题仍未解决,建议提供更详细的错误日志以便进一步分析。您可以复制页面截图提供更多信息,我可以进一步帮您分析问题原因。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。