modelscope-funasr微调后还是识别出了多音字,怎么解决?

在使用ModelScope的FunASR模型进行微调后,如果仍然出现多音字识别问题,可以尝试以下方法来优化和解决:

多音字的识别效果很大程度上依赖于训练数据的质量。建议对训练数据进行以下优化: - 增加多音字场景的数据:确保训练数据中包含丰富的多音字场景,并且标注准确。例如,针对“银行”和“行走”中的“行”,需要提供明确的上下文标注。 - 上下文信息补充:多音字的正确识别通常依赖于上下文语境。可以通过增加句子级别的标注数据,帮助模型学习上下文关系。 - 数据清洗:检查训练数据中是否存在标注错误或模糊的情况,尤其是多音字相关的标注。

提示:模板参数配置不实时生效和展示,模板测试环节可以正常生效。因此,在数据准备阶段需特别注意标注的准确性。

如果数据质量已经较高,但模型仍无法正确识别多音字,可以尝试以下微调策略: - 增加特定任务的预处理:在微调前,对输入文本进行预处理,提取字段并设置单字符分隔符模式,确保模型能够更好地理解输入结构。 - 调整超参数:适当调整学习率、批次大小等超参数,避免模型过拟合或欠拟合。 - 引入语言模型辅助:结合语言模型(如GPT或BERT)对多音字进行上下文预测,提升识别准确性。

在模型输出后,可以通过后处理规则进一步优化多音字的识别结果: - 基于词典的校正:构建一个多音字词典,根据上下文选择正确的读音。例如,“重”在“重量”中读“zhòng”,而在“重复”中读“chóng”。 - 规则匹配:设计规则匹配逻辑,结合上下文判断多音字的正确发音。例如,利用正则表达式或条件判断实现简单的后处理。

如果FunASR模型本身难以完全解决多音字问题,可以结合其他工具或库进行辅助处理: - Python库支持:使用pypinyin库对中文文本进行拼音转换,结合模型输出结果进行校正。 - 语音合成验证:通过个性化语音合成模型(如ModelScope Notebook最佳实践中的方案)验证多音字的发音是否符合预期。

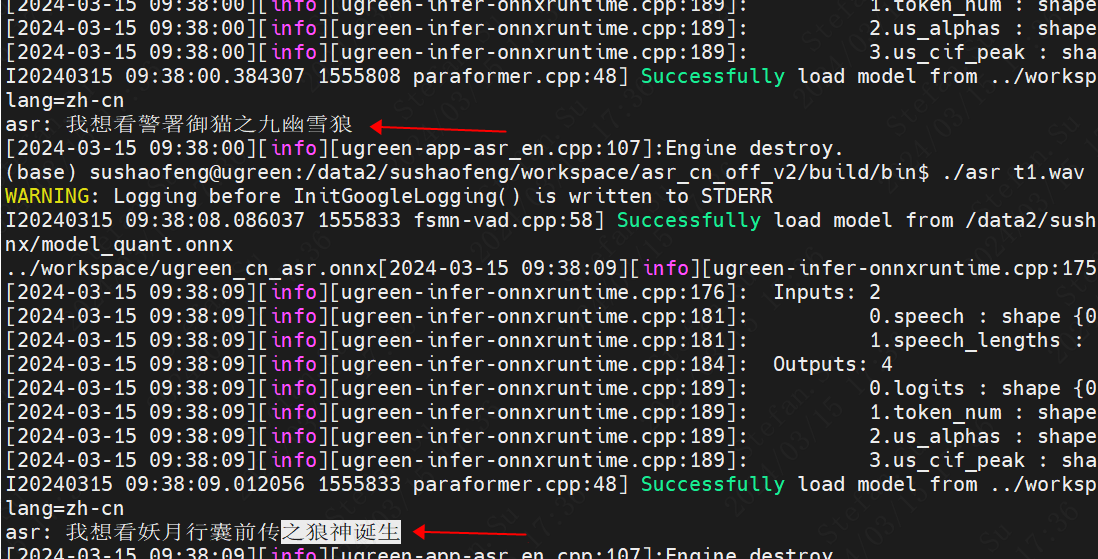

在模型部署后,建议通过以下方式进一步验证和优化多音字识别效果: - 在线调试与反馈:通过API接口调用模型服务,构造包含多音字的测试数据,观察模型输出并收集反馈。 - 日志审计与分析:利用日志服务的安全性和审计功能,记录模型的输入输出日志,分析多音字识别的错误模式并针对性优化。

通过以上方法,您可以有效提升FunASR模型在多音字识别上的表现。如果问题仍未解决,建议进一步分析具体场景并调整优化策略。