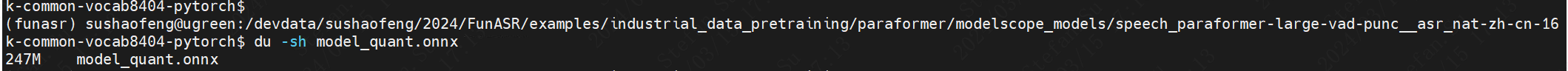

modelscope-funasr最新代码pt转onnx的模型大小 比docker 下载的onnx大了13M正常吗?

在将 modelscope-funasr 的 PyTorch 模型转换为 ONNX 格式后,发现生成的 ONNX 模型比通过 Docker 下载的 ONNX 模型大了 13MB,这种情况是否正常需要从以下几个方面进行分析:

在将 PyTorch 模型转换为 ONNX 格式时,可能会因为以下原因导致文件大小的变化: - 优化级别不同:PyTorch 转换为 ONNX 时,默认可能未启用某些优化选项(如常量折叠、算子融合等),这会导致生成的 ONNX 文件包含更多冗余信息。而通过 Docker 下载的 ONNX 模型可能是经过高度优化后的版本。 - 算子实现差异:PyTorch 和 ONNX 在某些算子的实现上可能存在细微差异,例如动态形状支持或特定算子的展开方式,这些差异可能导致文件大小的变化。

通过 Docker 下载的 ONNX 模型通常是经过预处理和优化的版本,可能包括以下操作: - 剪枝和量化:模型可能经过剪枝(移除冗余参数)或量化(降低权重精度)处理,从而减小文件大小。 - 定制化导出:Docker 中的模型可能是针对特定硬件(如 GPU 或 TensorRT)进行了定制化导出,去除了不必要的算子或层。

为了确认文件大小差异是否合理,可以采取以下步骤: 1. 检查模型结构: - 使用工具(如 Netron)可视化两个 ONNX 模型的结构,对比它们的算子数量、权重分布等。 - 确认是否有冗余算子或未优化的部分。 2. 验证模型精度: - 对比两个模型的推理结果,确保 PyTorch 转换后的 ONNX 模型与 Docker 下载的模型在功能上一致。 3. 优化 PyTorch 转换流程: - 在 PyTorch 转换时启用优化选项,例如设置 opset_version 和 do_constant_folding=True。 - 示例代码: ```python import torch

# 假设 model 是 PyTorch 模型,dummy_input 是示例输入

torch.onnx.export(

model, dummy_input, "model.onnx",

opset_version=13, # 设置合适的 opset 版本

do_constant_folding=True, # 启用常量折叠

input_names=["input"], output_names=["output"]

)

```

文件大小相差 13MB 在某些情况下是正常的,尤其是当 PyTorch 转换的 ONNX 模型未经过充分优化时。建议按照上述步骤验证模型结构和精度,并优化转换流程。如果优化后仍然存在较大差异,可能需要进一步分析模型的具体实现细节。

重要提醒:在生产环境中使用模型前,请务必验证其推理性能和精度,确保满足业务需求。