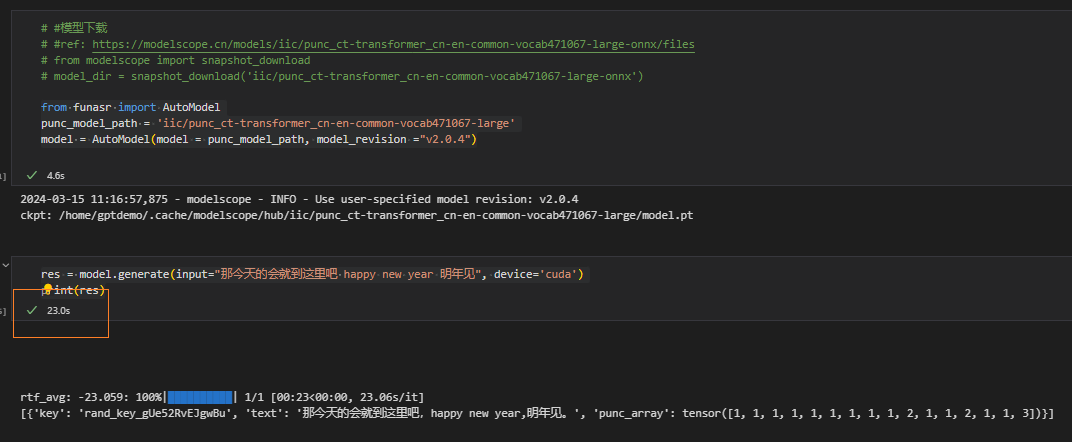

在使用 modelscope-funasr 时遇到性能问题,尝试仅使用标点恢复模型时调用时间过长,通常需要20秒左右。是否因为未使用onnx版本的模型导致的?当尝试将模型转换为onnx格式并导入时出现错误。如何解决这个问题?

如果你在使用 modelscope-funasr 时遇到了性能问题,尤其是在使用标点恢复模型时,这里有一些可能的解决方案和步骤来优化你的体验:

更新库版本:首先,确保你的 modelscope 和 funasr 库是最新版本的。有时,性能问题可能会在新版本中得到解决。

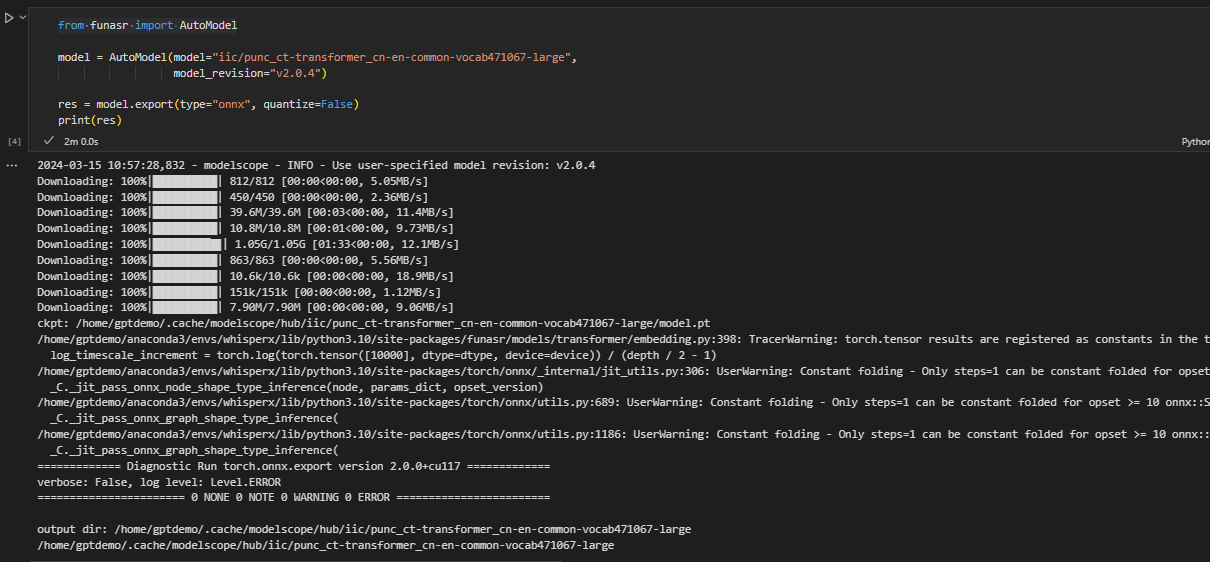

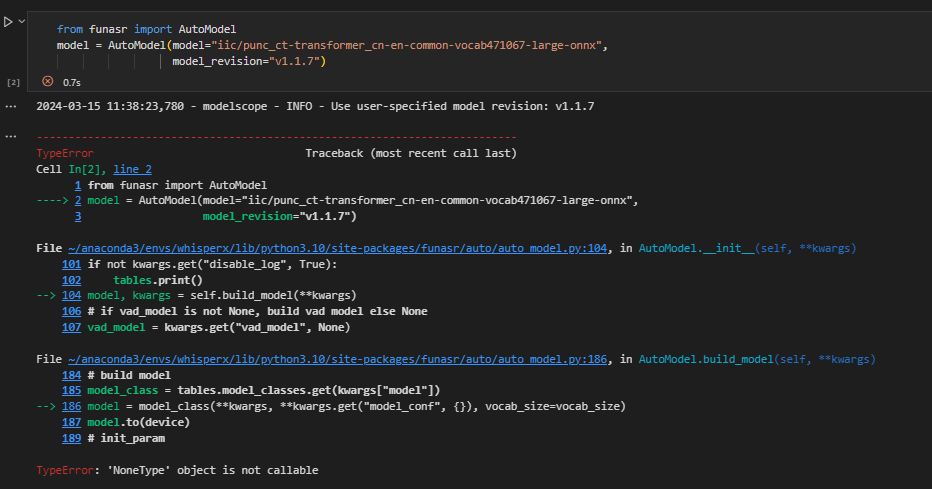

使用 ONNX 模型:ONNX(Open Neural Network Exchange)是一种开放的模型格式,它可以提高模型在不同平台和硬件上的运行效率。如果你已经将模型转换为 ONNX 格式,但遇到了导入错误,请检查错误信息以确定问题所在。可能需要调整模型转换或加载的方式。

检查模型输入输出:确保你的模型输入是正确的,并且没有不必要的预处理步骤,这些可能会增加处理时间。

优化代码:检查你的代码,看看是否有任何可以优化的地方,比如使用更有效的数据结构或减少不必要的计算。

硬件加速:如果你有可用的GPU或TPU,确保你的模型在这些设备上运行,以利用它们的并行处理能力。

批量处理:如果可能,尝试批量处理你的数据,这样可以减少模型加载和处理的时间。

社区支持:如果问题依然存在,可以考虑在 modelscope-funasr 的 GitHub 仓库或相关社区中寻求帮助。可能有其他用户遇到了类似的问题,并且找到了解决方案。

性能分析:使用性能分析工具(如Python的cProfile)来分析你的代码,找出瓶颈所在。

环境变量:有时设置正确的环境变量可以提高性能,尤其是与GPU相关的环境变量。

模型简化:如果性能仍然不佳,考虑使用更小或更简单的模型,或者寻找其他替代方案。

请注意,如果你在转换或加载 ONNX 模型时遇到错误,错误信息将是解决问题的关键。确保提供尽可能详细的错误信息,以便更好地诊断问题。

参考https://github.com/alibaba-damo-academy/FunASR/issues/1447#issuecomment-1986094997 此回答整理自钉群“modelscope-funasr社区交流”