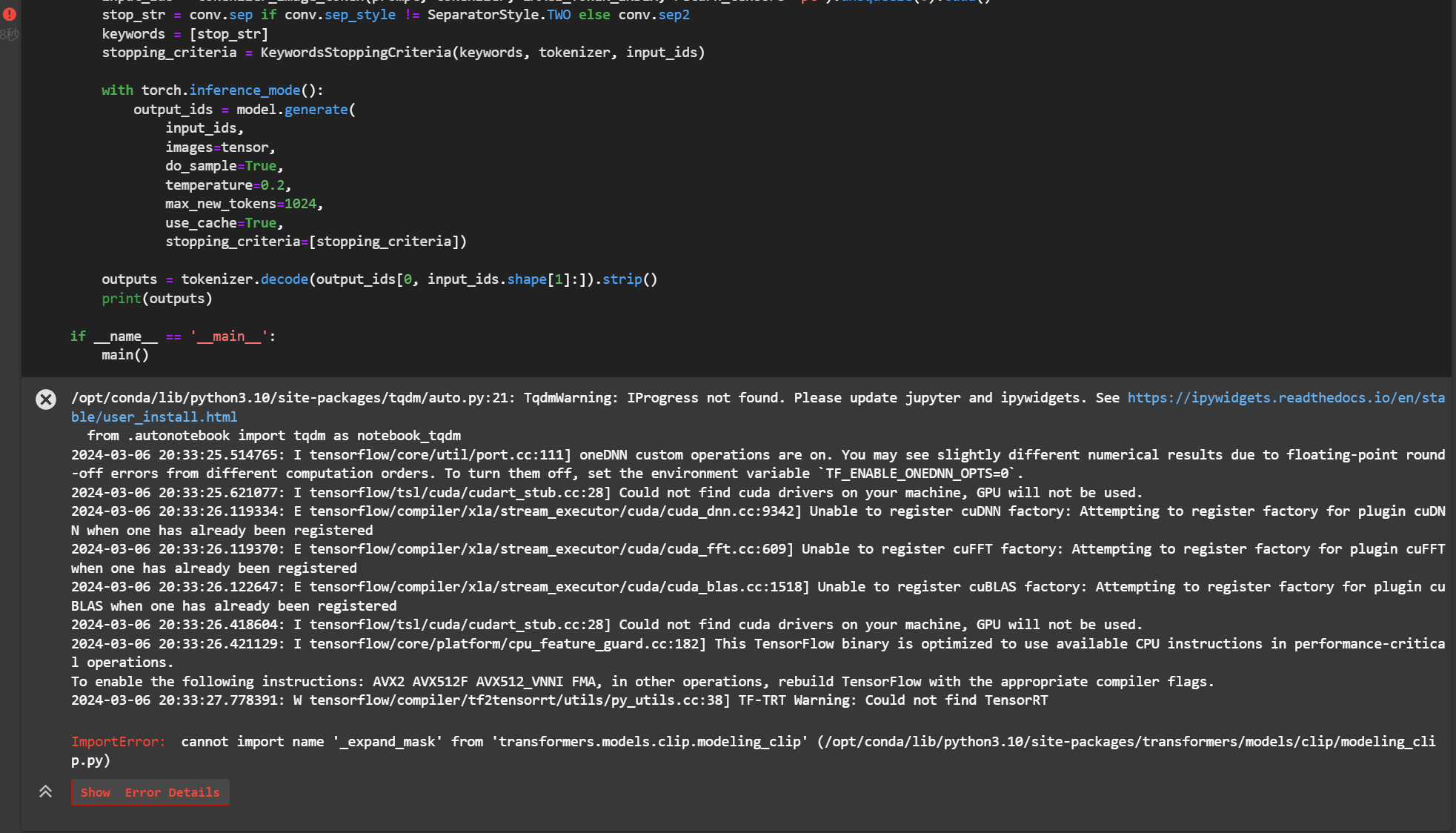

ModelScope大模型为什么安装文档跑出来总是报错?

"

https://www.modelscope.cn/models/PKU-YuanLab/Video-LLaVA-7B/summary ModelScope大模型为什么安装文档跑出来总是报错?"

展开

收起

阿里云 AI 助理回答

在尝试安装或运行ModelScope大模型(如PKU-YuanLab/Video-LLaVA-7B)时,如果总是遇到报错问题,可能是由于以下几个常见原因导致的。以下是详细的排查步骤和解决方法:

1. 环境依赖未正确安装

- 问题描述:ModelScope上的模型通常依赖特定版本的Python库、框架(如PyTorch、Transformers等)或其他工具(如Git LFS)。如果这些依赖未正确安装或版本不匹配,可能会导致运行失败。

- 解决方法:

- 确保已安装Python 3.7及以上版本。

- 安装必要的依赖包,例如:

pip install torch torchvision transformers git-lfs - 如果使用

git-lfs下载模型数据,请确保已启用Git LFS支持:git lfs install - 检查模型文档中是否有特定的依赖要求,并严格按照文档安装。

2. 模型下载失败或中断

- 问题描述:模型文件较大,下载过程中可能因网络问题、磁盘空间不足或权限问题导致失败。

- 解决方法:

- 检查磁盘空间:确保实例的磁盘空间足够。如果磁盘空间不足,可以通过扩容云盘解决。

- 使用稳定的网络连接:建议为ECS实例分配公网IP,并设置较高的带宽峰值(如100 Mbps)以加速模型下载。

- 避免断开连接:在下载模型时,可以使用

tmux会话保持连接,防止因SSH断开导致下载中断。 - 验证下载完整性:下载完成后,检查模型文件是否完整。如果文件损坏,重新下载。

3. 硬件资源不足

- 问题描述:某些大模型(如

Video-LLaVA-7B)对硬件资源(如GPU显存、内存)有较高要求。如果资源不足,可能会导致OOM(Out of Memory)错误。 - 解决方法:

- 检查硬件配置:

- GPU显存需大于16 GB。

- 内存需大于16 GiB。

- 优化资源分配:

- 使用支持Intel AMX指令的实例(如g8i/c8i/r8i系列)以提升性能。

- 在Docker容器中启动服务时,增加共享内存大小(

--shm-size=16g)。

- 分批加载模型:如果显存不足,可以尝试将模型分块加载到内存中。

- 检查硬件配置:

4. 模型转换或初始化失败

- 问题描述:某些模型需要经过转换(如TensorRT-LLM引擎生成)才能运行。如果转换脚本或参数配置不正确,可能会导致失败。

- 解决方法:

- 拉取原始模型:从ModelScope下载模型文件。

- 启动模型转换容器:

docker run --gpus=all --net=host -it --entrypoint=/bin/bash \ -e MODEL_PATH=${MODEL_PATH} -e CKPT_PATH=${CKPT_PATH} -e ENGINE_PATH=${ENGINE_PATH} \ -v ${MODEL_PATH}:${MODEL_PATH} -v ${CKPT_PATH}:${CKPT_PATH} -v ${ENGINE_PATH}:${ENGINE_PATH} \ tensorrt-llm-model-build - 执行转换脚本:在容器内运行

build.engine.sh脚本生成TensorRT-LLM引擎。

5. API调用或服务部署问题

- 问题描述:如果通过API调用模型服务或部署WebUI时出错,可能是服务配置或权限问题。

- 解决方法:

- 检查服务URL和Token:确保API调用时使用的

service_url和token正确无误。 - 配置安全组规则:确保ECS实例的安全组已放行相关端口(如22端口用于SSH,8080端口用于模型服务)。

- 验证公网访问权限:如果服务需要公网访问,确保已绑定弹性公网IP并配置SNAT条目。

- 检查服务URL和Token:确保API调用时使用的

6. 其他常见问题

- 问题描述:某些错误可能是由于模型本身的问题或文档说明不清晰导致的。

- 解决方法:

- 查看日志信息:检查运行日志,定位具体的错误信息。

- 参考官方文档:仔细阅读ModelScope上该模型的文档说明,确保操作步骤无误。

- 联系技术支持:如果问题仍未解决,可以通过阿里云工单系统提交问题,提供详细的错误日志和操作步骤。

总结

通过以上步骤,您可以逐步排查并解决PKU-YuanLab/Video-LLaVA-7B模型安装或运行中的问题。特别注意硬件资源、环境依赖和网络连接的配置,这些是导致报错的主要原因。如果仍有疑问,请提供更多具体的错误信息以便进一步分析。您可以复制页面截图提供更多信息,我可以进一步帮您分析问题原因。

有帮助

无帮助

AI 助理回答生成答案可能存在不准确,仅供参考

相关问答

ModelScope旨在打造下一代开源的模型即服务共享平台,为泛AI开发者提供灵活、易用、低成本的一站式模型服务产品,让模型应用更简单!欢迎加入技术交流群:微信公众号:魔搭ModelScope社区,钉钉群号:44837352

热门讨论

热门文章

展开全部

展开全部

还有其他疑问?

咨询AI助理