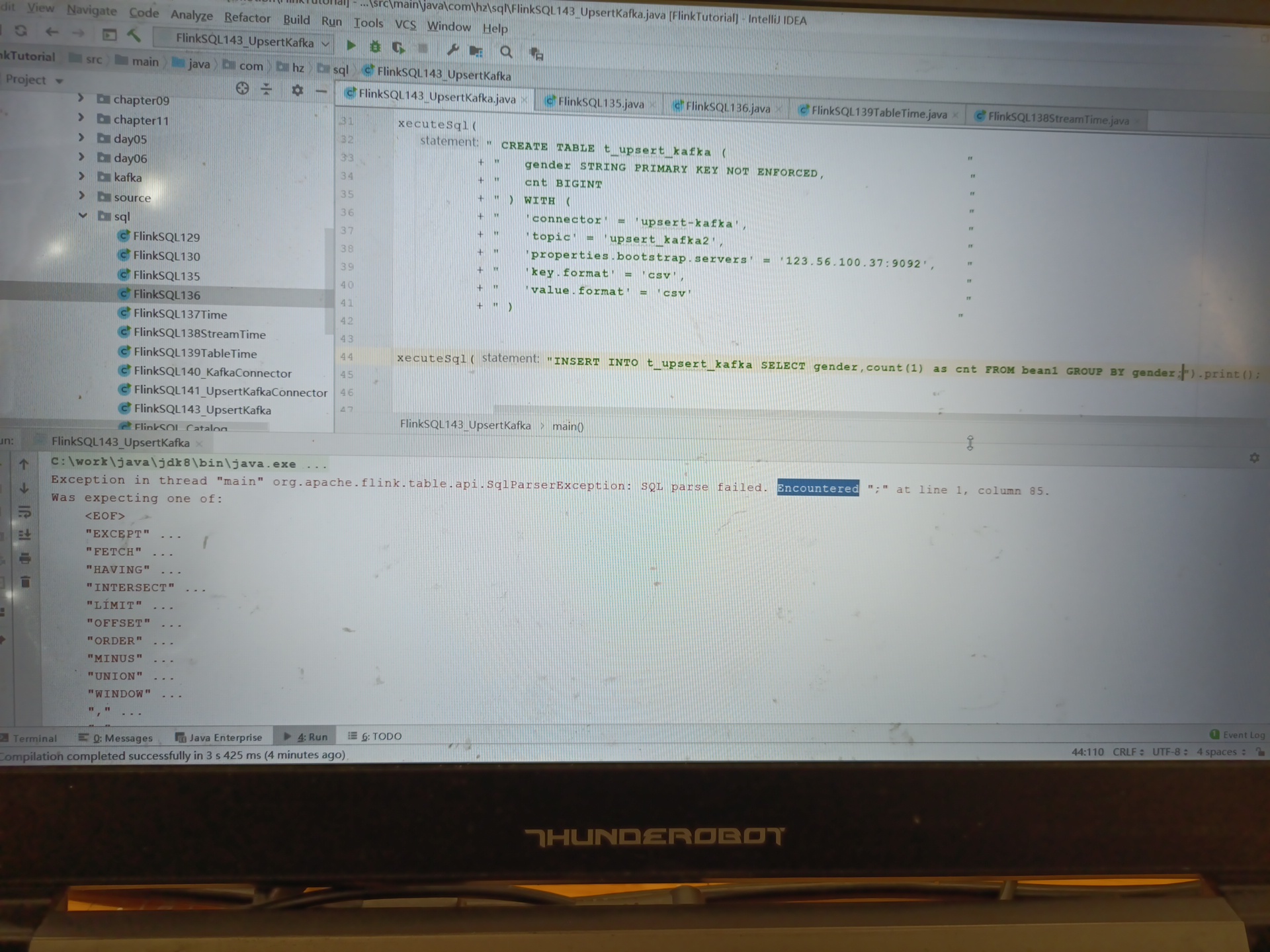

为什么flink在SQL语句后面加个分号就报错了?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

您好,看到您使用的是Upsert Kafka连接器,Upsert Kafka连接器支持以upsert方式从Kafka topic中读取数据并将数据写入Kafka topic,语法结构如下

CREATE TABLE upsert_kafka_sink(

user_region STRING,

pv BIGINT,

uv BIGINT,

PRIMARY KEY(user_region) NOT ENFORCED

)WITH(

'connector'='upsert-kafka',

'topic'='<yourTopicName>',

'properties.bootstrap.servers'='...',

'key.format'='avro',

'value.format'='avro'

);

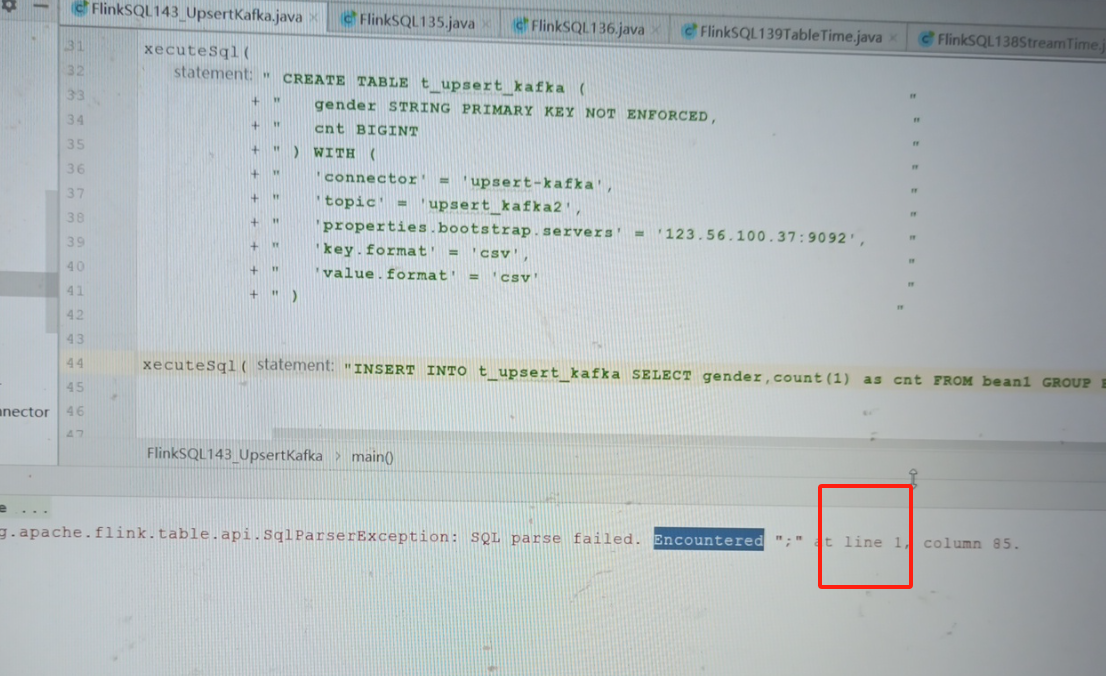

这里只有在结尾处才可以使用分号,您在使用分号后报错,很有可能是您在进行代码拼接字符串语句时,未注意到语句是否结束而使用分号导致语句中途断开报错,建议您检查一下您代码中拼接语句的地方。另外需要注意一下Upsert Kafka连接器的使用限制

更多详细内容可以参考文档:文档

在Flink SQL中,如果SQL语句后添加了分号,可能会导致报错。

这种情况通常发生在将SQL语句嵌套在程序代码中时。在编程环境中,编译器可能会将分号解释为SQL语句本身的一部分,从而引发错误。例如,如果您的代码中有多条SQL语句,而它们之间没有适当的分隔符,编译器可能会尝试将它们解析为一条单一的语句,导致语法错误或执行错误。

为了解决这个问题,您可以尝试以下几种方法:

综上所述,Flink SQL中遇到语句后面加分号报错的情况,需要根据具体的上下文和执行环境来判断是否需要分号,并相应地调整代码。

在 Flink SQL 中,SQL 语句后面加分号可能导致报错的原因可能有以下几点:

不支持分号终结符:Flink SQL 解析器可能不支持在 SQL 语句末尾使用分号作为终结符。通常情况下,Flink SQL 不需要在每条 SQL 语句的末尾添加分号。

语法解析错误:在某些情况下,Flink SQL 解析器可能会将分号解释为 SQL 语法中的一部分,从而导致语法错误。这可能会触发解析器检测到错误并报错。

分号引起的歧义:在某些情况下,分号可能会导致 SQL 语句的歧义,特别是在复杂的查询或者多条语句组合时。这可能会使解析器无法正确理解语句的意图,导致报错。

为避免在 Flink SQL 中出现问题,建议按照以下几点操作:

不要在每条 SQL 语句的末尾添加分号:通常情况下,Flink SQL 不需要在每条 SQL 语句的末尾添加分号。只有在执行多条 SQL 语句时才需要使用分号来分隔不同的语句。

检查语法和语义:确保 SQL 语句的语法和语义是正确的。在书写 SQL 语句时,应该遵循正确的语法规则,并考虑语句之间的逻辑关系,以避免出现歧义。

查看错误信息:如果在 Flink SQL 中出现报错,查看报错信息可以帮助定位问题所在。错误信息通常会指出具体的问题,有助于调整 SQL 语句以解决错误。

总的来说,在 Flink SQL 中避免在每条语句末尾添加分号,并注意编写正确的语法和语义,可以帮助避免因为分号导致的报错问题。

Upsert Kafka连接器支持以upsert方式从Kafka topic中读取数据并将数据写入Kafka topic。

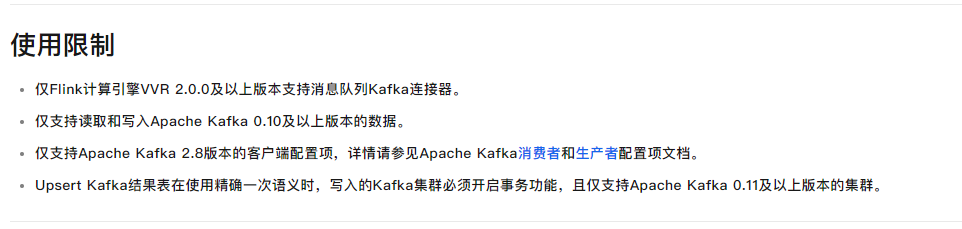

使用限制

仅Flink计算引擎VVR 2.0.0及以上版本支持消息队列Kafka连接器。

仅支持读取和写入Apache Kafka 0.10及以上版本的数据。

仅支持Apache Kafka 2.8版本的客户端配置项,详情请参见Apache Kafka消费者和生产者配置项文档。

Upsert Kafka结果表在使用精确一次语义时,写入的Kafka集群必须开启事务功能,且仅支持Apache Kafka 0.11及以上版本的集群。

CREATE TABLE upsert_kafka_sink(

user_region STRING,

pv BIGINT,

uv BIGINT,

PRIMARY KEY(user_region) NOT ENFORCED

)WITH(

'connector'='upsert-kafka',

'topic'='<yourTopicName>',

'properties.bootstrap.servers'='...',

'key.format'='avro',

'value.format'='avro'

);

参考;https://help.aliyun.com/zh/flink/developer-reference/upsert-kafka-connector?spm=a2c4g.11186623.0.i85

CREATE TABLE pageviews(

user_id BIGINT,

page_id BIGINT,

viewtime TIMESTAMP,

user_region STRING,

WATERMARK FOR viewtime AS viewtime - INTERVAL '2' SECOND

)WITH(

'connector'='kafka',

'topic'='<yourTopicName>',

'properties.bootstrap.servers'='...',

'format'='json'

);

因为你写的sql只是里面一部份,程序会在外面包一层,在此处如果加了; sql语言结束了 ,此回答整理自钉群“【②群】Apache Flink China社区”

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。