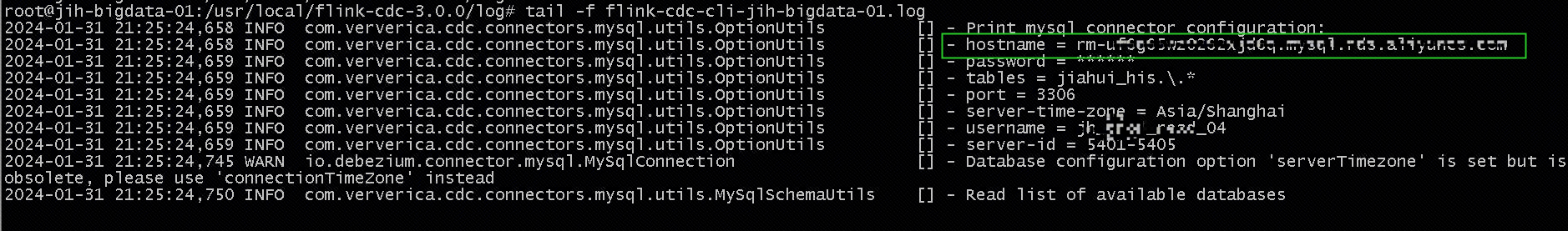

flink-cdc 这种方式去启动bin/flink-cdc.sh source_sink/rds_jiahui_his_to_doris.yaml 从阿里云RDS去同步咋命令执行直接卡着也不报错是什么问题啊?

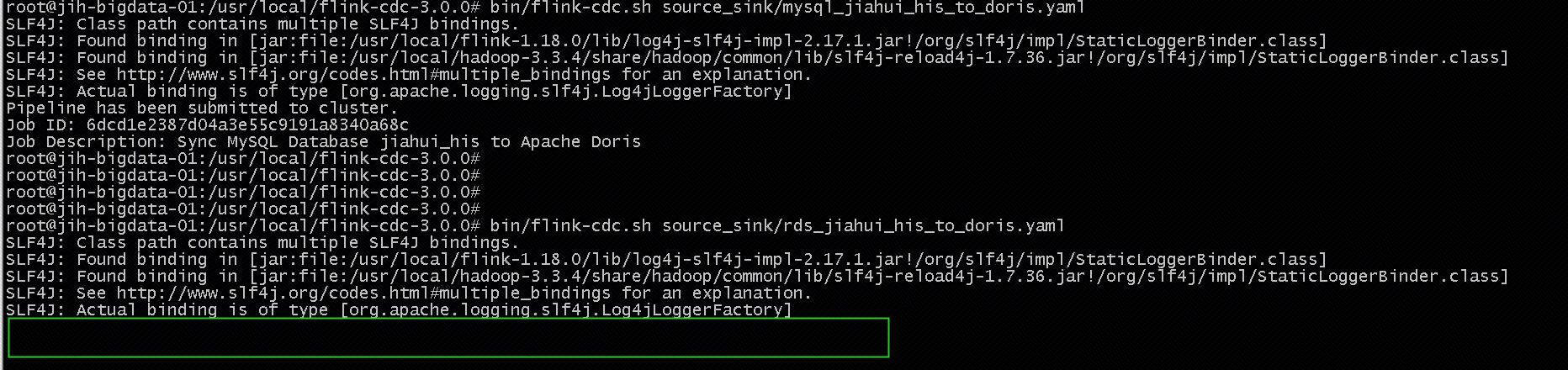

就是直接卡在这里Pipeline提交这里 没有向flink提交任务。

就是直接卡在这里Pipeline提交这里 没有向flink提交任务。

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

根据您描述的问题,Flink CDC任务在执行bin/flink-cdc.sh source_sink/rds_jiahui_his_to_doris.yaml命令时卡在Pipeline提交阶段,且没有向Flink提交任务。这种情况可能由以下几个原因导致,以下是详细分析和解决方案:

source_sink/rds_jiahui_his_to_doris.yaml文件中的配置项是否完整且正确,尤其是以下关键参数:

rds.region-id、rds.access-key-id、rds.access-key-secret、rds.db-instance-id等)。table.optimizer.source-merge.enabled)。scan.startup.mode),确保其值与实际需求一致。SHOW VARIABLES LIKE 'expire_logs_days';

SET GLOBAL expire_logs_days=7;

ping或telnet测试)。REPLICATION SLAVEREPLICATION CLIENTSELECT权限(针对需要同步的表)server-id范围不匹配,导致任务无法启动。server-id范围是否满足并发需求。例如,如果server-id范围为5404-5412,则最多支持8个并发。server-id范围。flink-conf.yaml中添加以下配置:

logger.level: DEBUG

pipeline.operator-chaining设为false。server-id范围的匹配性。如果按照上述步骤仍无法解决问题,请提供更详细的日志信息以便进一步分析。您可以复制页面截图提供更多信息,我可以进一步帮您分析问题原因。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。