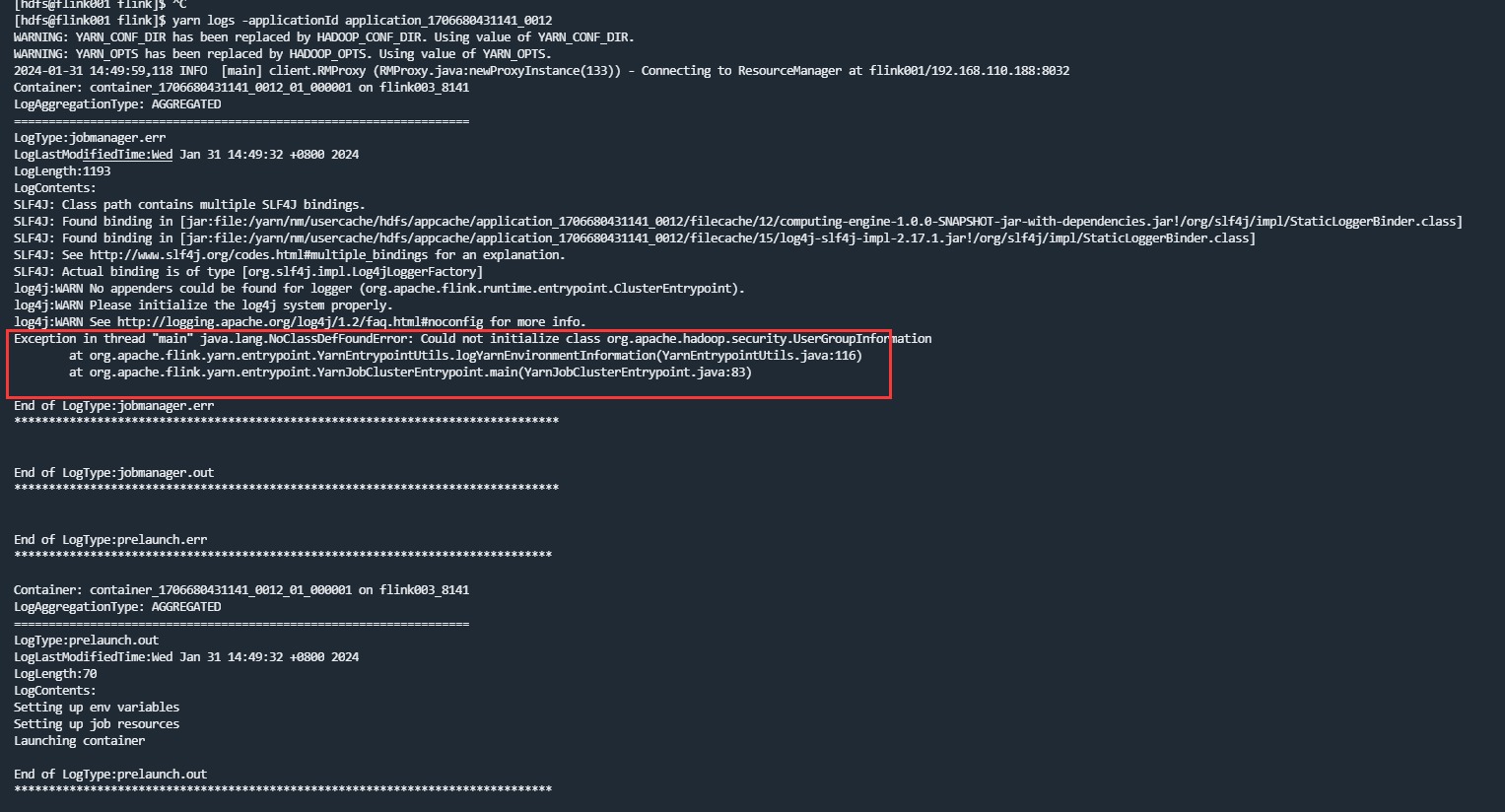

Flink CDC里通过海豚调度器提交yarn任务报错 Could not initialize class org.apache.hadoop.security.UserGroupInformation 这个错怎么办?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

报错信息 Could not initialize class org.apache.hadoop.security.UserGroupInformation 表明在通过海豚调度器提交 Flink CDC 任务到 Yarn 集群时,程序无法正确初始化 Hadoop 的安全认证类 UserGroupInformation。这通常是由于以下原因之一导致的:

krb5.conf 文件或 keytab 文件),也会引发此问题。根据知识库资料和常见问题排查经验,以下是解决该问题的具体步骤:

确保 Flink 任务中包含正确的 Hadoop 依赖,并且版本与集群环境一致。如果使用的是阿里云 EMR 集群,请参考以下配置: - 在 Flink 项目的 pom.xml 文件中,添加 Hadoop 相关依赖,并设置作用域为 provided,以避免与集群环境中的依赖冲突。例如:

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-common</artifactId>

<version>${hadoop.version}</version>

<scope>provided</scope>

</dependency>

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-client</artifactId>

<version>${hadoop.version}</version>

<scope>provided</scope>

</dependency>

${hadoop.version} 与 EMR 集群的 Hadoop 版本一致。如果集群启用了 Kerberos 安全认证,请确保客户端正确配置了 Kerberos 参数: - 检查 krb5.conf 文件:将集群的 krb5.conf 文件复制到客户端机器的 /etc/krb5.conf 路径下。 - 提供 keytab 文件:确保任务提交时指定了正确的 keytab 文件和 principal。例如,在提交命令中添加以下参数:

--keytab /path/to/user.keytab \

--principal user@REALM.COM

kinit -kt /path/to/user.keytab user@REALM.COM

klist

如果存在类加载冲突,可以通过调整类加载顺序解决。参考知识库资料,在 Flink 任务的运行参数中添加以下配置:

classloader.parent-first-patterns.additional: org.apache.hadoop

此配置确保 Hadoop 相关类优先从父类加载器加载,避免冲突。

确保 Yarn 集群环境正常运行,并且资源充足。可以通过以下步骤验证: - 登录集群 Master 节点,执行以下命令检查 Yarn 状态:

yarn node -list

在完成上述配置后,使用以下命令提交 Flink CDC 任务到 Yarn 集群:

flink run -m yarn-cluster \

-yjm 1024 \

-ytm 2048 \

-c com.example.MainClass \

/path/to/your-flink-job.jar \

--keytab /path/to/user.keytab \

--principal user@REALM.COM

-yjm 和 -ytm 分别指定 JobManager 和 TaskManager 的内存大小。-c 指定主函数的全路径类名。--keytab 和 --principal 仅在启用 Kerberos 时需要。provided 作用域,避免与集群环境冲突。通过以上步骤,您应该能够成功解决 Could not initialize class org.apache.hadoop.security.UserGroupInformation 报错问题。您可以复制页面截图提供更多信息,我可以进一步帮您分析问题原因。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。