flink cdc3中,使用Pipeline Connector JAR的方式,将mysql整库同步到doris中。官网上,用的是flink standalone集群,我如何将这个任务提交到yarn上呢?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在 Flink CDC 3.0 中,如果你希望将基于 Pipeline Connector 的 MySQL 整库同步任务提交到 YARN 上运行,你可以按照以下步骤操作:

构建作业 JAR 包:

配置 Flink on YARN:

flink-conf.yaml,确保配置了正确的 YARN 集群连接参数,如ResourceManager 地址、队列名称、容器资源大小等。# 示例配置项

yarn.application-id: application_1234567890

yarn.resourcemanager.address: hadoop-cluster:8032

yarn.queue: default

taskmanager.memory.process.size: 2048m

准备 Flink YAML 配置文件:

job.properties,定义 CDC 作业的相关配置,如源数据库、目标 Doris 端点等。提交作业到 YARN:

使用 Flink 的命令行客户端提交作业至 YARN cluster。通过 yarn-session 模式或 per-job 模式提交都可以。

Per-Job 模式:

./bin/flink run -m yarn-cluster -yn <number-of-taskmanagers> -ys <slots-per-tm> -c <main-class> <path-to-your-jar> --configPath job.properties

其中 <main-class> 应替换为你的 CDC 作业入口类,<path-to-your-jar> 是之前构建好的 JAR 文件路径。

Application Mode:

如果你打算长期运行一个 Flink session 在 YARN 上,可以先启动一个 Application Master,然后在该 session 中提交作业。

启动 Flink YARN session:

./bin/yarn-session.sh -n <number-of-taskmanagers> -tm <task-manager-memory-size>

然后在 session 启动后,通过 Flink 的 REST API 或者命令行提交作业:

./bin/flink run -m yarn-cluster -c <main-class> <path-to-your-jar> --configPath job.properties

监控与管理:

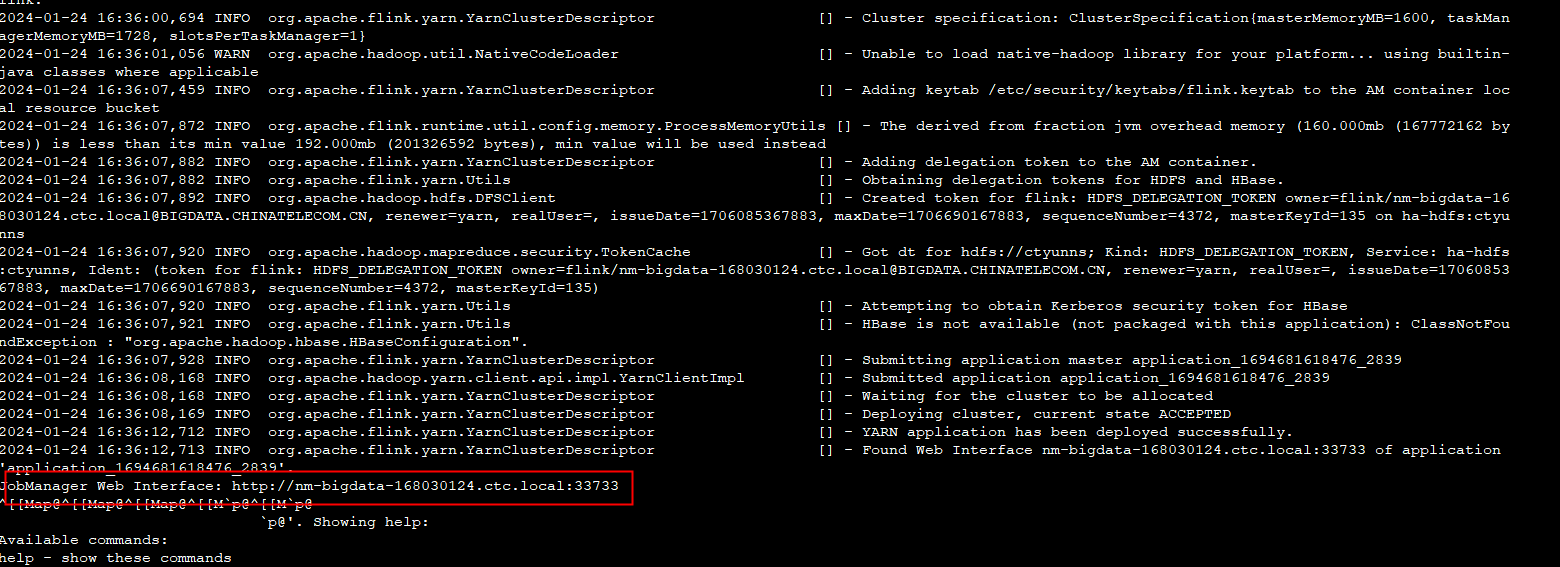

提交成功后,可以通过 Flink Web UI 或 YARN ResourceManager Web UI 监控作业状态和资源使用情况。

修改 flink conf 里的rest.address : 127.0.0.1rest.port : 8081成 yarn session 里对应的ip 端口。 此回答来自钉群Flink CDC 社区。

此回答来自钉群Flink CDC 社区。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。