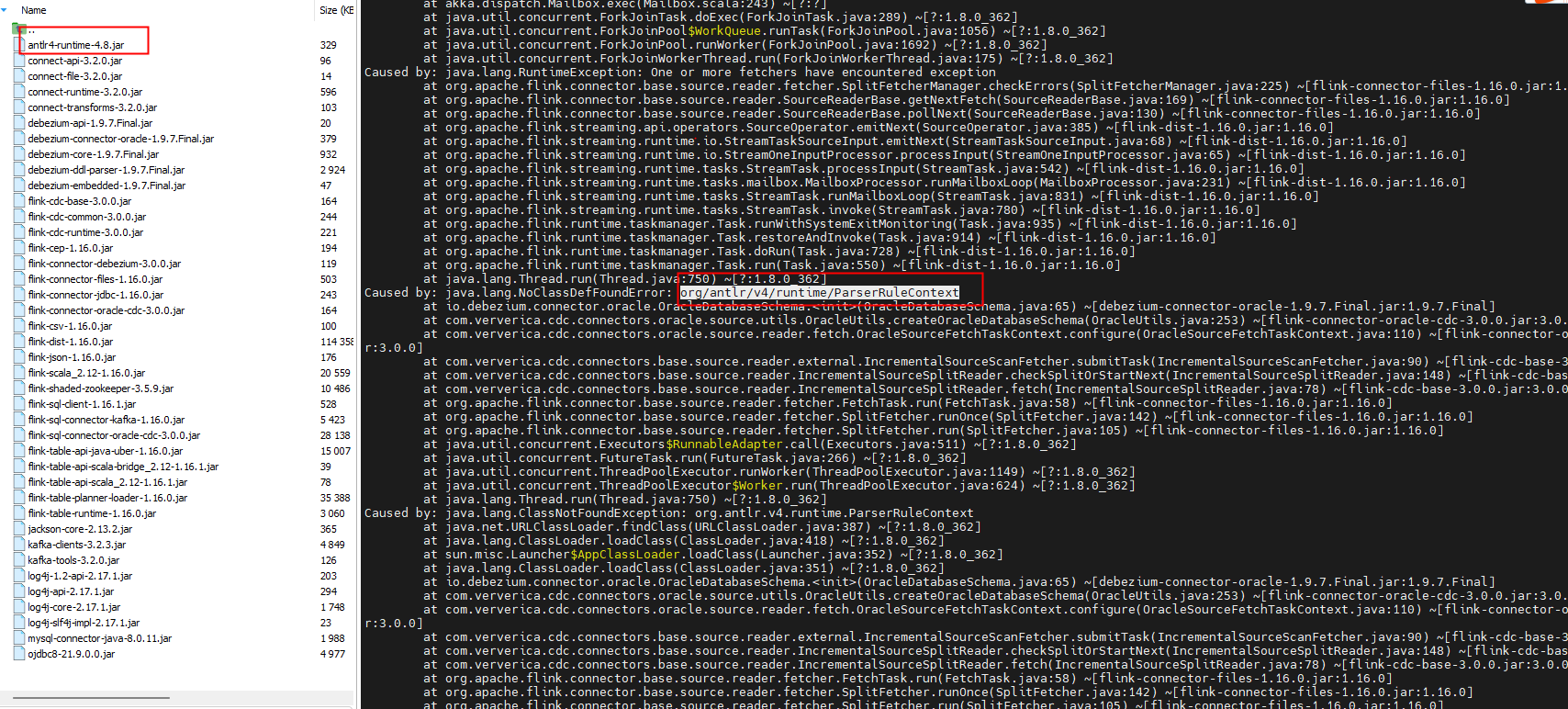

Flink CDC里这个缺包是什么情况?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在使用Flink CDC时,如果遇到缺包的情况,通常与以下几种原因相关:

如果您尝试使用类似flink-sql-connector-mysql-cdc-2.2-SNAPSHOT.jar的依赖,可能会发现Maven中央仓库中没有该版本。这是因为: - SNAPSHOT版本对应的是开发分支的代码,尚未发布为正式版本。 - Maven中央仓库通常不会托管SNAPSHOT版本的依赖。

解决方法: - 如果需要使用SNAPSHOT版本,您需要从源码编译对应的JAR包。可以通过克隆Flink CDC项目的源码并使用Maven或Gradle进行本地构建。 - 推荐使用稳定版本(如flink-sql-connector-mysql-cdc-2.1.0.jar),这些版本可以直接从Maven中央仓库获取。

从Flink CDC 2.0.0版本开始,Group ID从com.alibaba.ververica更改为com.ververica。因此,如果您在Maven仓库中查找2.x版本的依赖时,路径应为/com/ververica,而不是旧的路径。

解决方法: - 确保在pom.xml文件中正确配置了新的Group ID和版本号。例如: xml <dependency> <groupId>com.ververica</groupId> <artifactId>flink-sql-connector-mysql-cdc</artifactId> <version>2.x.x</version> </dependency>

Flink CDC提供了两种类型的连接器JAR包: - FAT JAR(如flink-sql-connector-xxx):包含连接器的所有依赖,并将第三方库打包在一起,适合SQL作业使用。只需将其放入Flink的lib目录即可。 - 普通JAR(如flink-connector-xxx):仅包含连接器的核心代码,不包含依赖,适合DataStream API使用。需要手动管理依赖,处理可能的冲突。

解决方法: - 如果您使用的是SQL作业,请确保下载并使用FAT JAR版本。 - 如果使用DataStream API,则需要检查是否缺少必要的第三方依赖,并手动添加到项目中。

在某些情况下,可能是由于pom.xml文件中未正确声明依赖,或者未添加必要的Maven仓库地址。例如,Flink CDC的某些依赖可能需要从Ververica的私有仓库中获取。

解决方法: - 确保在pom.xml中添加了正确的仓库地址。例如: xml <repositories> <repository> <id>aliyun</id> <url>https://maven.aliyun.com/repository/public</url> </repository> <repository> <id>ververica</id> <url>https://repo.ververica.com/298</url> </repository> </repositories> - 检查依赖版本是否与Flink引擎版本兼容。例如,Flink 1.17.1需要使用与之匹配的Flink CDC版本。

缺包问题通常由依赖版本、Group ID变更、JAR类型选择或网络问题引起。根据具体情况,您可以采取以下措施: 1. 使用稳定版本而非SNAPSHOT版本。 2. 确保Group ID和版本号配置正确。 3. 根据作业类型选择合适的JAR包(FAT JAR或普通JAR)。 4. 检查pom.xml文件中的依赖和仓库配置。

如果问题仍未解决,建议提供具体的错误日志以便进一步分析。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。