flink cdc3.0 设置-Dtaskmanager.numberOfTaskSlots=1 怎么设置?flink-conf已经配置,但是启动的任务使用槽集中在一个机器上,我想设置任务的节点槽数,来打散任务并行分布的节点。

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在Flink中,taskmanager.numberOfTaskSlots 参数用于定义每个 TaskManager 的并行任务槽数量。您提到已经在 flink-conf.yaml 中配置了该参数,但任务的槽仍然集中在一个机器上。这可能与 Flink 的调度策略、资源配置或集群部署方式有关。以下是解决此问题的具体方法和建议:

确保您的 Flink 集群中有多个 TaskManager 实例运行,并且每个 TaskManager 都有足够的资源(如 CPU 和内存)来支持任务的分布。如果只有一个 TaskManager 实例运行,即使设置了多个槽,任务也会集中在一个节点上。

检查 TaskManager 的数量:

./bin/taskmanager.sh list

如果只有一个 TaskManager,请启动更多的 TaskManager 实例以分散任务。

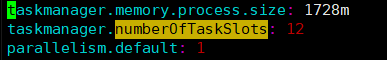

确保每个 TaskManager 的资源分配合理。例如,在 flink-conf.yaml 中设置以下参数:

taskmanager.memory.process.size: 4096m # 根据实际需求调整

taskmanager.numberOfTaskSlots: 2 # 每个 TaskManager 的槽数量

任务的并行度决定了任务在集群中的分布情况。如果并行度设置过低,任务可能会集中在少数槽中运行。

在提交任务时,通过 -p 参数设置并行度。例如:

./bin/flink run -p 4 your-job.jar

这里的 4 表示任务的并行度为 4。确保并行度不超过集群中所有 TaskManager 的总槽数。

如果使用 SQL 作业,可以在 SQL 中设置并行度:

SET parallelism.default = 4;

Flink 默认启用了 Slot Sharing(槽共享),这允许不同任务的子任务共享同一个槽。如果您希望任务更均匀地分布在不同的节点上,可以禁用 Slot Sharing。

在 SQL 作业中禁用 Slot Sharing:

SET 'pipeline.operator-chaining' = 'false';

或者在代码中禁用:

env.disableOperatorChaining();

Flink 的调度策略可能会影响任务的分布。默认情况下,Flink 使用的是基于资源的调度策略。如果任务槽集中在某个节点上,可以尝试调整调度策略。

flink-conf.yaml 中设置调度模式为 EVENLY_SPREAD:

cluster.evenly-spread-out-slots: true

这会强制 Flink 尽量将任务均匀分布在所有可用的 TaskManager 上。

如果您的 Flink 集群是基于 YARN 或 Kubernetes 部署的,可以通过动态扩展 TaskManager 的数量来实现任务的分布。

YARN 部署:增加 TaskManager 的数量:

./bin/yarn-session.sh -n 4 -s 2

这里的 -n 4 表示启动 4 个 TaskManager,-s 2 表示每个 TaskManager 的槽数量为 2。

Kubernetes 部署:通过修改 Deployment 的副本数来增加 TaskManager:

kubectl scale deployment flink-taskmanager --replicas=4

完成上述配置后,可以通过 Flink Web UI 查看任务的分布情况。具体步骤如下:

cluster.evenly-spread-out-slots 参数在较新的 Flink 版本中才被引入。通过以上步骤,您可以有效解决任务槽集中在单个节点上的问题,并实现任务的均匀分布。如果问题仍然存在,建议检查集群的日志文件以获取更多调试信息。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。