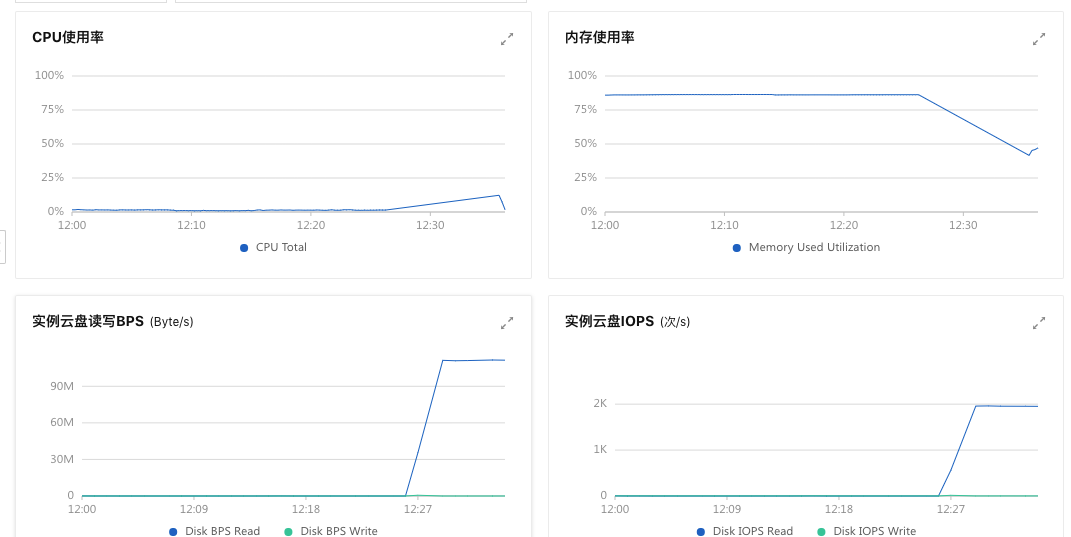

RockerMQ中有人遇到这种情况吗:即使mq未进行消息消费,broker进程却在每天中午12点至1点左右导致CPU使用率持续保持100%,同时伴有显著增高的磁盘读写活动,一旦重启就会恢复正常,这是为什么?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

是的,RocketMQ的Broker有可能导致CPU持续100%和磁盘读写很高的情况。以下是一些可能的原因和解决方法:

总的来说,解决这类问题通常需要综合监控系统资源使用情况、日志文件大小、网络状况以及RocketMQ的配置和架构设计。通过逐一排查和调优,可以找到导致性能问题的根源,并采取相应措施进行解决。

出现这种现象可能是因为:

涵盖 RocketMQ、Kafka、RabbitMQ、MQTT、轻量消息队列(原MNS) 的消息队列产品体系,全系列产品 Serverless 化。RocketMQ 中文社区:https://rocketmq-learning.com/