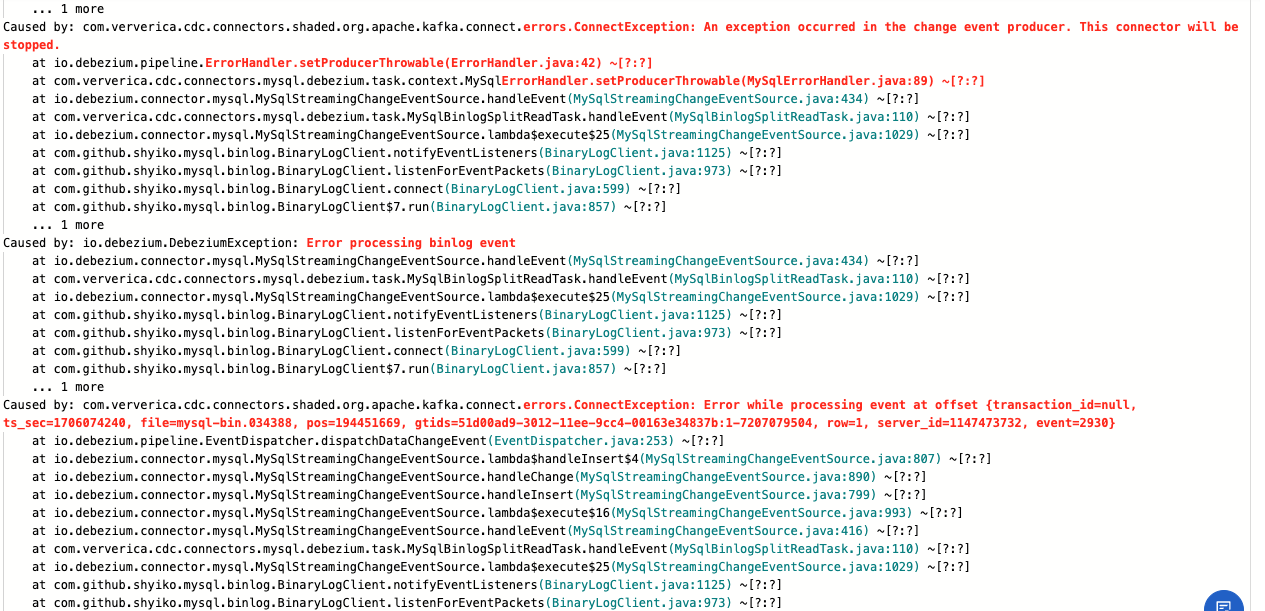

flink运行报错能帮忙看一下么?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

当然可以!请提供具体的报错信息或描述问题的详细情况,我将根据知识库中的资料为您提供专业的解答。

如果您已经有具体的报错信息(例如错误代码、日志内容等),可以直接提供,我会为您分析可能的原因并给出解决方案。以下是一些常见的Flink运行报错及其解决方法,您可以参考是否与您的问题相关:

原因:

该报错通常是因为Task在Failover或退出过程中被阻塞,导致超时时间(默认180秒)内未能完成退出。

可能的根本原因包括:

close方法中存在长时间阻塞逻辑)。解决方案:

task.cancellation.timeout为0,避免Task因超时被强制停止(仅用于调试,生产环境不建议使用)。Cancelling状态的Task,查看其栈信息以排查根本原因。原因:

可能是由于自建DNS的连接延迟较大,导致JobManager与TaskManager之间的心跳超时。

解决方案:

jobmanager.retrieve-taskmanager-hostname: false。原因:

使用Kafka作为Sink时,连续多次Checkpoint失败,导致Kafka生产者池资源耗尽。

解决方案:

execution.checkpointing.timeout为更大的值。原因:

Checkpoint失败次数超过了容忍阈值,触发了作业Failover。

解决方案:

execution.checkpointing.tolerable-failed-checkpoints,调整允许的Checkpoint失败次数。原因:

该报错通常出现在使用TopN函数时,尝试撤回一个不存在的记录。

解决方案:

原因:

虚拟交换机的可用IP地址不足,导致无法创建新的网络接口。

解决方案:

原因:

解决方案:

原因:

Checkpoint耗时过长可能是由于网络延迟、存储性能不足或数据量过大导致。

解决方案:

如果以上内容未能覆盖您的问题,请提供更详细的报错信息或上下文,我将进一步为您分析并提供解决方案!您可以复制页面截图提供更多信息,我可以进一步帮您分析问题原因。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。