ModelScope加速没有效果或者通过onnx 方式运行,识别时间也要1秒以上?

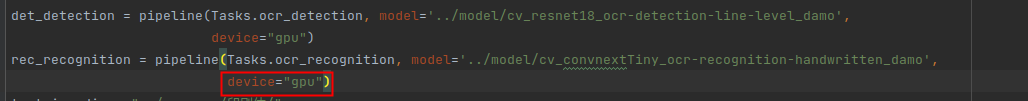

已经添加了device=""gpu"" ModelScope加速没有效果或者通过onnx 方式运行,识别时间也要1秒以上?

根据您描述的问题,ModelScope加速没有效果或通过ONNX方式运行时识别时间超过1秒,可能涉及多个潜在原因和优化方向。以下是详细分析和解决建议:

1. 确认GPU设备是否正常启用

在使用ModelScope或其他深度学习框架时,确保GPU设备已正确安装并被系统识别是关键前提。

-

检查GPU设备状态

使用nvidia-smi命令查看当前GPU的状态和资源占用情况。如果未检测到GPU设备,请检查驱动程序和CUDA版本是否匹配。 -

验证ModelScope是否启用了GPU加速

在ModelScope中,可以通过环境变量或配置文件指定是否使用GPU。例如:export DASHSCOPE_API_KEY="your_api_key" export CUDA_VISIBLE_DEVICES="0" # 指定使用的GPU设备如果未明确指定GPU设备,ModelScope可能会默认使用CPU进行推理,导致性能下降。

2. 优化ONNX推理性能

如果您使用的是ONNX格式模型,以下方法可以帮助提升推理速度:

-

使用AIACC-Inference加速工具

阿里云提供的AIACC-Inference工具可以显著提升ONNX模型的推理性能,支持FP32和FP16两种精度优化。

安装和使用步骤如下:pip install aiacc-inference在代码中加载ONNX模型时,使用AIACC-Inference进行优化:

from aiacc_inference import optimize_onnx_model optimized_model = optimize_onnx_model("model.onnx", precision="fp16") -

调整Batch Size

ONNX推理性能与Batch Size密切相关。尝试调整Batch Size以找到最佳性能点。通常,较大的Batch Size会提高GPU利用率,但过大会导致显存不足。 -

启用动态尺寸推理

如果输入数据的尺寸不固定,可以启用动态尺寸推理功能,避免每次推理时重新编译模型。

3. 检查模型下载和加载过程

模型下载和加载的时间可能会影响整体推理性能。以下是一些优化建议:

-

预下载模型文件

确保模型文件已提前下载到本地存储路径,并且路径有足够的磁盘空间(建议预留模型大小的1.5倍空间)。例如:MODEL_NAME="DeepSeek-R1-Distill-Qwen-7B" LOCAL_SAVE_PATH="/mnt/7B" sudo docker run -d -t --network=host --rm \ -v ${LOCAL_SAVE_PATH}:/data \ egs-registry.cn-hangzhou.cr.aliyuncs.com/egs/vllm:0.6.4.post1-pytorch2.5.1-cuda12.4-ubuntu22.04 \ /bin/bash -c "git-lfs clone https://www.modelscope.cn/models/deepseek-ai/${MODEL_NAME}.git /data" -

使用缓存机制

如果模型文件较大,建议使用缓存机制避免重复加载。例如,在Python代码中使用torch.load时,可以启用map_location参数将模型加载到GPU内存中。

4. 启用混合精度推理

混合精度推理(Mixed Precision Inference)可以显著减少计算时间和显存占用。以下是如何启用混合精度的示例:

-

使用Deepytorch Inference工具

Deepytorch Inference支持动态尺寸推理和混合精度优化,能够将ResNet50模型的推理时间从3.686 ms降至0.396 ms。

安装和使用步骤如下:pip install deepytorch-inference在代码中编译模型时启用混合精度:

import deepytorch_inference compiled_model = deepytorch_inference.compile(mod_jit, precision="fp16")

5. 排查其他潜在问题

如果上述方法仍无法解决问题,请检查以下内容:

-

网络延迟

如果模型依赖远程服务(如ModelScope SDK),网络延迟可能会影响推理时间。建议在本地部署模型以减少网络开销。 -

硬件资源限制

确保GPU实例的规格满足模型需求。例如,对于大模型(如Qwen-7B),建议使用至少4张GPU卡,并确保每张卡的显存大于24 GB。 -

日志分析

查看推理服务的日志输出,定位性能瓶颈。例如,使用arena serve get modelscope命令查看服务状态。

总结

通过以上步骤,您可以逐步排查和优化ModelScope加速效果不佳或ONNX推理时间过长的问题。如果问题仍未解决,建议联系阿里云技术支持团队,提供详细的日志和环境信息以便进一步分析。