在使用数据传输DTS进行任务迁移时,发现任务ID为dtswu7w1o4z16ak6ju的任务出现异常,其中一个SQL查询在源库执行了17个小时。为了加快迁移速度并解决目标库锁表的问题,请问如何处理该慢SQL进程以及优化迁移效率?另外目前目标库共有11个连接,其中只有4个活跃,其他均为sleep状态。此外,源库的慢SQL是否会影响迁移进程?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

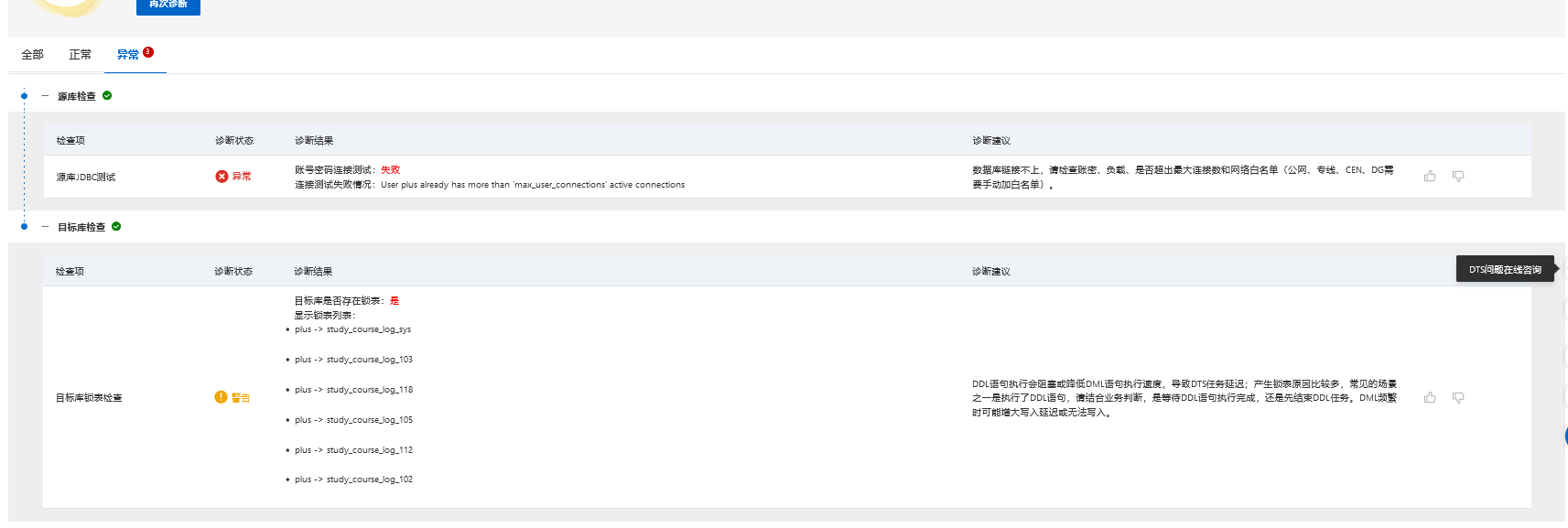

根据文档中提供的信息,如果数据传输DTS任务诊断发现异常,并且源库中有一个SQL执行了17个小时,您可以尝试以下步骤来解决问题:

检查账号密码:确保源库的账号密码是正确的,并且没有过期或被锁定。

检查负载和连接数限制:确认是否超出了数据库的最大连接数限制,如果是,请增加最大连接数或减少并发连接。

检查网络白名单设置:确保源库的网络白名单(公网、专线、CEN、DG)已正确配置,并且目标库的IP地址已被添加到白名单中。

检查DDL语句执行:如果目标库存在题表,可能是由于DDL语句执行阻塞或降低DML语句执行速度导致的延迟。您可以等待DDL语句执行完成,或者先结束DDL任务。

检查DML频繁写入:如果DML操作频繁进行,可能会导致写入延迟或无法写入。您可以考虑优化DML操作的频率或使用批量写入来提高性能。

您好,后端查看全量迁移报错:User plus already has more than 'max_user_connections' active connections是因为超出了最大连接数导致的任务重试,后端适当的调小了并发,max_user_connections需要您这边在目标端加大一下这个参数的连接,如果是目标端还是存在问题,后端是没有办法提升速度的,由于DTS在执行全量数据迁移时,速率是受限于源和目标端的,我这边尝试全量迁移放开限速试试,如源和目标端负载较高可能会导致全量迁移的速率不会很快的,您这边注意观察观察

--此回答整理自钉群“DTS客户交流群-2”