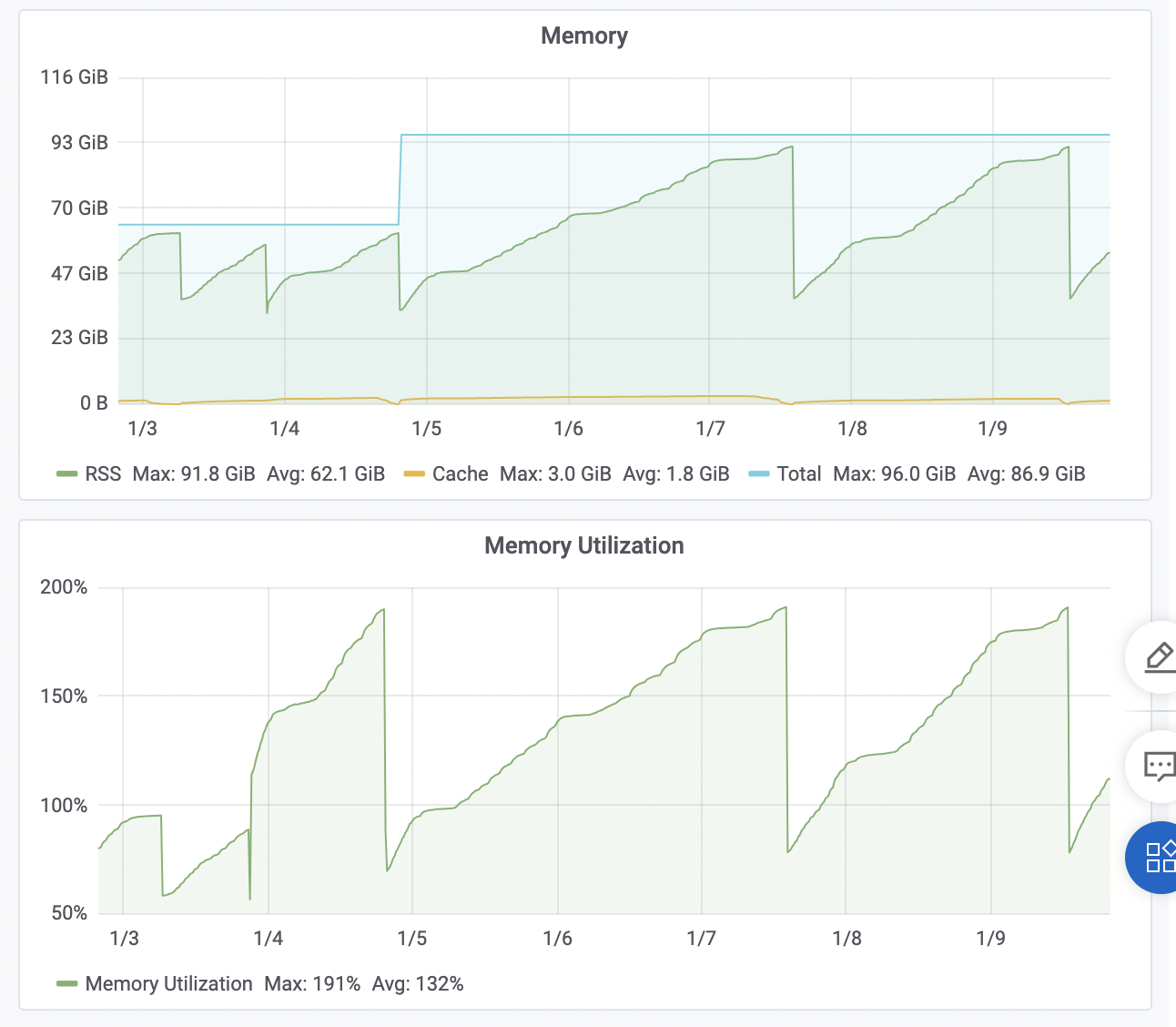

请问机器学习PAI这个服务内存占用没到上限96GB,内存占比却超过100%是为什么?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在阿里云机器学习PAI服务中,如果内存占用未达到物理内存上限,但内存占比却超过了100%,可能的原因包括:

虚拟内存使用:

内存占比超过100%可能意味着进程不仅使用了物理内存,还开始使用了虚拟内存(Swap)。当物理内存不足时,操作系统会将部分暂时不用的内存页交换到硬盘上的交换空间,以释放物理内存给其他进程使用。这时,虽然物理内存未满,但总的内存使用量(包括物理内存和虚拟内存)可能会超过100%。

内存统计方式:

在某些统计或监控工具中,内存占比可能会考虑缓存和缓冲区等因素,如果这些区域被大量使用,即使物理内存还未完全耗尽,内存占比也可能超过100%。

内存碎片:

虽然总体物理内存未达到上限,但如果内存碎片严重,可用的大块连续内存不足以分配给新进程或现有进程扩展使用,也会表现出内存紧张的迹象。

并发任务内存使用叠加:

如果在PAI上运行了多个并发任务,每个任务分配了适量的内存,但它们的内存使用叠加起来超过了总内存的100%。

内核空间内存占用:

内核空间的内存使用也可能被计算在内存占比中,如果内核使用了大量的内存(例如缓存、 slab 分配器等),也可能导致总体内存占比超过100%。

机器学习PAI服务内存占用没到上限96GB,但内存占比却超过100%的情况可能是由于一些特定的因素。例如,某些机器学习工具或库可能存在默认的内存设置,这可能会限制其使用的内存量。此外,数据加载器在迭代过程中的内存占用可能仅为每次迭代获取的批次数据的内存占用量。

在某些情况下,深度学习训练过程中的显存占用可能会包括框架占用、模型参数相关的占用以及特征相关的占用等部分。如果使用了优化器,梯度相关的参数占用也需要考虑在内。

对于这个问题,您可以尝试以下几种解决方案:首先,检查是否可以重新设置相关工具或库的内存分配,以分配更多的内存。其次,可以考虑使用更小的样本数据集。另外,提高Batch size或者采用多进程并发处理数据的方式也可能有助于减少内存占比。最后,根据具体的计算需求和硬件配置,合理调整模型和优化器等相关参数,以降低显存占用。

人工智能平台 PAI(Platform for AI,原机器学习平台PAI)是面向开发者和企业的机器学习/深度学习工程平台,提供包含数据标注、模型构建、模型训练、模型部署、推理优化在内的AI开发全链路服务,内置140+种优化算法,具备丰富的行业场景插件,为用户提供低门槛、高性能的云原生AI工程化能力。