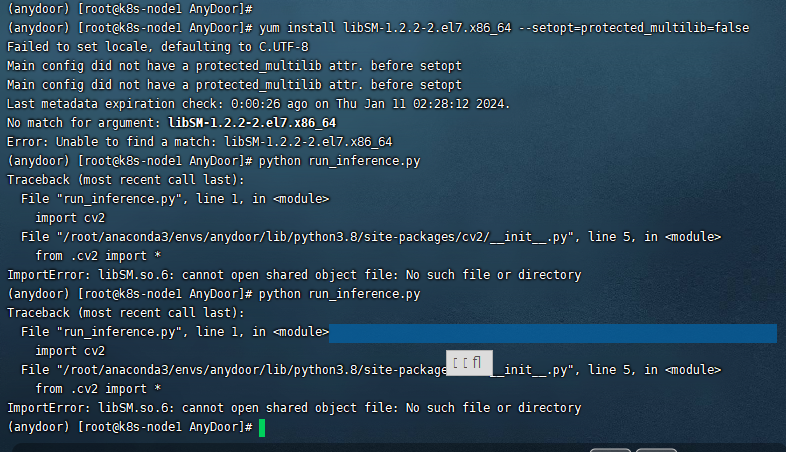

linux上面目前就报了

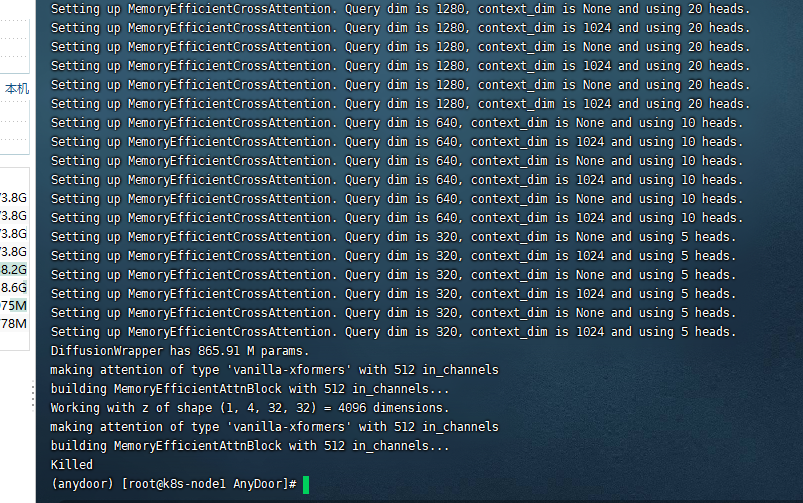

ModelScope执行run_inference.py后直接关闭了,怎么解决?

在Linux系统上执行run_inference.py后直接关闭的问题,可能与以下几个方面有关:权限问题、运行环境配置问题或后台进程管理问题。以下是详细的排查和解决方法:

确保run_inference.py脚本及其依赖的文件具有可执行权限。如果权限不足,可能会导致脚本无法正常运行。

解决方法: 使用chmod命令为脚本赋予权限:

chmod +x run_inference.py

如果脚本依赖其他可执行文件(如模型文件或二进制工具),也需要确保这些文件具备执行权限:

chmod +x <依赖文件路径>

注意:如果脚本是从Windows或macOS系统打包上传到Linux环境的,请确认压缩工具未丢失文件属性。如果发现问题,可以重新解压并设置权限。

nohup保持进程运行如果脚本在SSH会话断开后被终止,可能是由于SIGHUP信号导致的。可以通过nohup命令让脚本在后台持续运行。

操作步骤:

nohup python run_inference.py > inference.log 2>&1 &

> inference.log:将标准输出重定向到inference.log文件。2>&1:将错误输出也重定向到同一文件。&:将进程放入后台运行。tail -f inference.log

说明:通过nohup运行后,即使SSH会话断开,脚本也会继续执行。

screen管理会话如果需要更灵活地管理长时间运行的任务,可以使用screen工具。

操作步骤:

screen(如果尚未安装):

sudo apt-get install screen # 对于Debian/Ubuntu系统

sudo yum install screen # 对于CentOS/RHEL系统

screen会话:

screen -S model_inference

screen会话中运行脚本:

python run_inference.py

Ctrl+A,然后按D键,分离当前会话。screen -r model_inference

说明:screen允许您随时恢复会话,适合长时间运行的任务。

如果脚本仍然无法正常运行,建议检查日志和错误信息以定位问题。

操作步骤:

确保脚本中有日志记录功能,例如使用Python的logging模块:

import logging

logging.basicConfig(filename='run_inference.log', level=logging.DEBUG)

logging.info("Starting inference...")

cat run_inference.log

确保运行环境中已正确安装所有依赖项,并且Python版本与脚本兼容。

python --version

requirements.txt文件):

pip install -r requirements.txt

pip list

如果脚本涉及模型下载,确保模型已成功下载到默认路径(通常是~/.cache/modelscope)。

操作步骤:

打印模型下载路径以确认:

from modelscope.hub.snapshot_download import snapshot_download

model_dir = snapshot_download('AI-ModelScope/stable-diffusion-v1-5')

print(model_dir)

说明:ModelScope默认下载路径为~/.cache/modelscope。

通过上述步骤,您可以逐步排查并解决run_inference.py在Linux系统上运行后直接关闭的问题。重点在于权限配置、后台进程管理以及运行环境验证。如果问题仍未解决,请提供具体的错误日志以便进一步分析。