ModelScope还是无法发布成功?

ModelScope还是无法发布成功?

在使用ModelScope进行模型发布时,如果遇到无法成功发布的问题,可能是由于以下几个原因导致的。以下是详细的排查步骤和解决方案:

确保您在部署服务时正确填写了MODEL_ID、TASK和REVISION等关键参数。这些参数需要与ModelScope平台上的模型信息完全一致。

普通模型(如机器翻译模型):

MODEL_ID:例如iic/nlp_csanmt_translation_en2zhTASK:例如translationREVISION:例如v1.0.1大语言对话模型(如ChatGLM系列模型):

MODEL_ID:例如ZhipuAI/chatglm2-6bTASK:例如chatREVISION:例如v1.0.11注意:如果部署的是非公开模型,还需要配置访问令牌(ACCESS_TOKEN),并确保其值为有效的SDK访问令牌。

在自定义部署页面中,选择正确的镜像配置是成功发布的关键。建议使用官方提供的镜像,并选择最新版本。

modelscope-inference重要提示:如果使用自定义镜像,请确保镜像中包含所有必要的依赖项,并且运行命令已正确配置。

大语言模型通常对GPU资源有较高要求,因此需要根据模型的实际需求选择合适的实例规格。

说明:如果资源不足,可能会导致模型下载失败或服务启动异常。建议切换到其他地域重试。

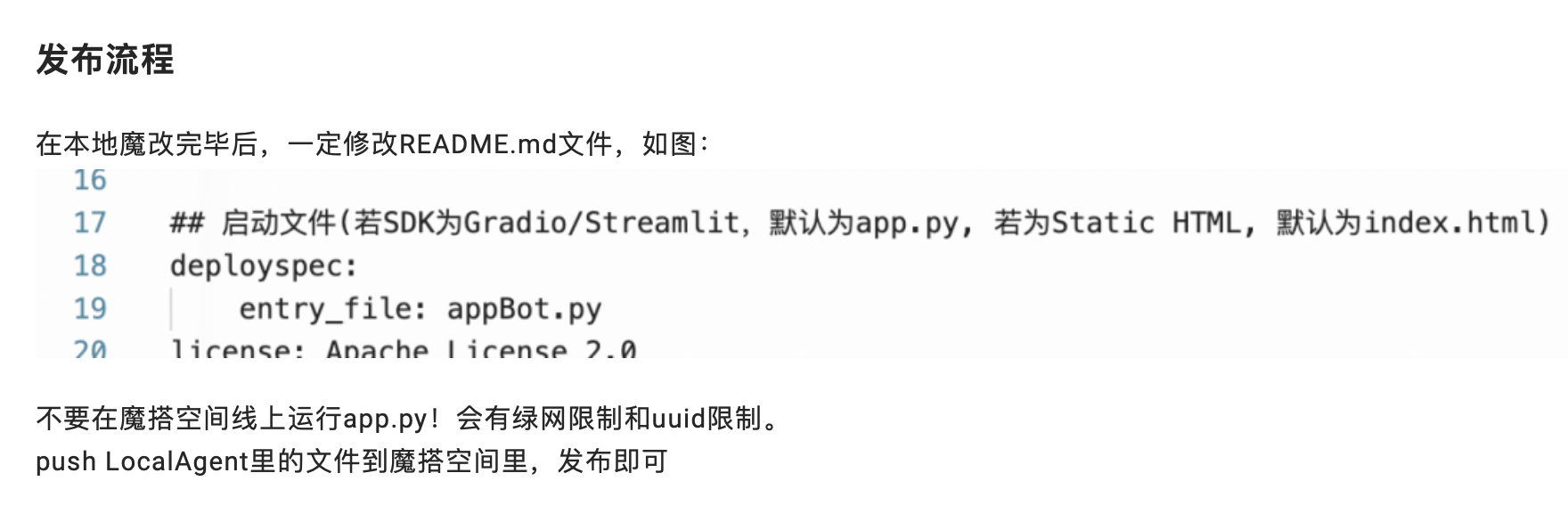

在部署过程中,系统会自动配置运行命令。如果您手动修改了运行命令,请确保其格式正确。例如:

MODEL_ID=qwen/Qwen1.5-4B-Chat python3 server.py

此外,检查是否遗漏了必要的环境变量配置,例如ACCESS_TOKEN或MODEL_ID。

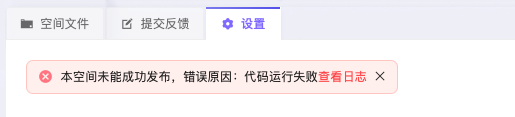

如果上述配置均无误,但仍然无法发布成功,可以通过以下方式查看日志以定位问题:

Kubernetes集群: 执行以下命令查看推理服务的详细信息:

arena serve get modelscope

如果服务状态异常,可以进一步查看Pod日志:

kubectl logs <pod-name>

函数计算平台: 在函数计算控制台中,进入函数详情页,查看运行日志和错误信息。

常见问题: - 模型下载超时:可能是网络问题或镜像拉取失败,建议切换到其他地域重试。 - GPU资源不足:建议选择更高规格的GPU实例或等待资源释放。

如果多次尝试仍无法解决问题,可以尝试清理已创建的资源后重新部署:

Kubernetes集群:

arena serve del modelscope

函数计算平台: 在函数计算控制台中删除应用及其相关资源。

注意:清理资源后,请确保重新配置所有必要参数,避免遗漏。

如果经过以上步骤仍无法解决问题,建议联系阿里云技术支持团队,提供以下信息以便快速定位问题: - 部署的具体步骤和配置参数。 - 错误日志或报错信息。 - 使用的产品平台(如ACK、PAI、函数计算等)。

通过以上步骤,您可以逐步排查并解决ModelScope模型发布失败的问题。希望这些信息能帮助您顺利完成模型部署!您可以复制页面截图提供更多信息,我可以进一步帮您分析问题原因。