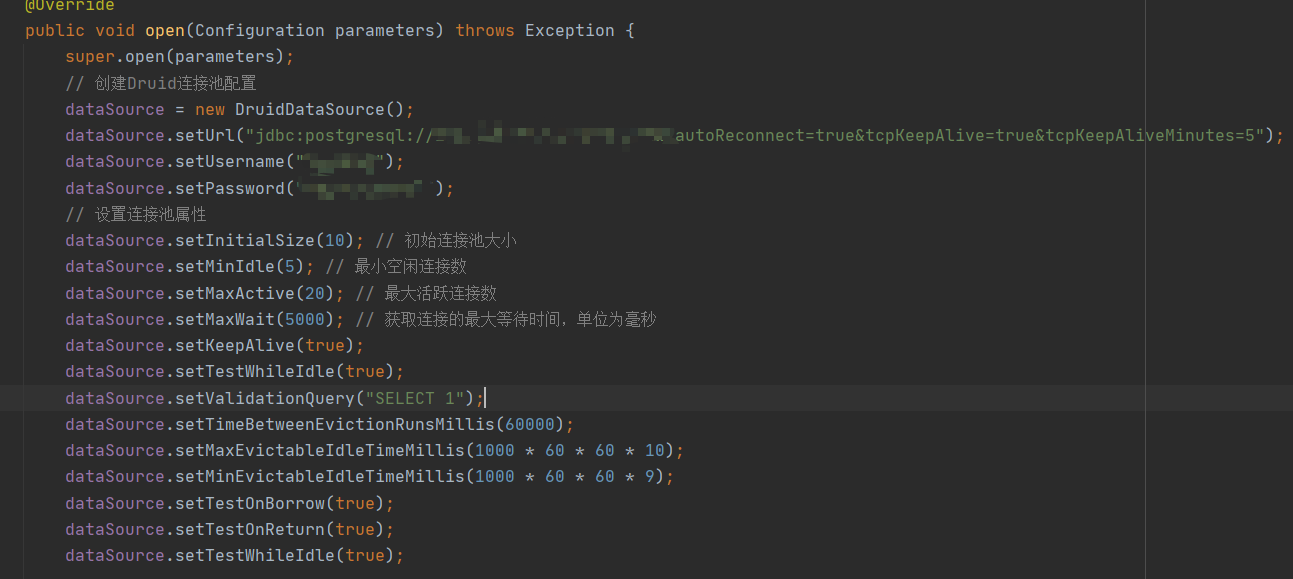

在使用Apache Flink的RichSinkFunction将数据写入PG时,每隔半小时就出现与PG断开连接的错误,并且考虑到数据发送间隔较长,可能会导致长时间无数据传输。尽管已经尝试采用Druid连接池并配置了相关参数,同时在invoke方法中也添加了逻辑判断,但也没起作用,是为什么?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

这个问题可能是由于PG连接池的配置问题或者Flink的RichSinkFunction处理逻辑导致的。你可以尝试以下方法来解决这个问题:

检查PG连接池的配置,确保配置正确。例如,检查连接池的最大连接数、最小连接数、空闲连接超时时间等参数。

在RichSinkFunction中,尝试使用try-catch语句捕获异常,并在异常发生时重新建立连接。例如:

public class MyRichSinkFunction extends RichSinkFunction<MyEvent> {

private Connection connection;

@Override

public void open(Configuration parameters) throws Exception {

super.open(parameters);

// 初始化连接

connection = createConnection();

}

@Override

public void close() throws Exception {

super.close();

// 关闭连接

if (connection != null) {

connection.close();

}

}

@Override

public void invoke(MyEvent value, Context context) {

try {

// 写入数据的逻辑

} catch (Exception e) {

// 发生异常时重新建立连接

connection = createConnection();

}

}

private Connection createConnection() {

// 创建并返回一个新的数据库连接

}

}

TimerService。这样可以避免因为长时间没有数据而导致的问题。实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。