Flink是不能直接用 sql api, 要用stream api map 取出来再用sql api 做进步的处理吗?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

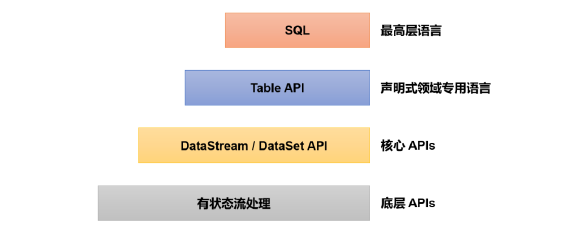

Apache Flink确实支持SQL API。它提供了两种顶层的关系型API,即Table API和SQL。Flink通过Table API和SQL实现了批流统一处理。Table API是用于Scala和Java的集成查询API,允许以直观的方式组合关系运算符(例如select,where和join)的查询。Flink SQL基于Apache Calcite实现了标准SQL,用户可以使用标准的SQL处理数据集。

Flink的Table & SQL API可以处理用SQL语言编写的查询语句,但这些查询需要嵌入用Java或Scala编写的表程序中,而这些程序在提交到集群前需要使用构建工具进行打包。此外,Flink提供了一个SQL客户端,目的是提供一种简单的方式来编写、调试和提交表程序到Flink集群上,而无需写一行Java或Scala代码。

Flink对SQL的支持基于实现了SQL标准的Apache Calcite。你可以通过SQL客户端或环境配置文件来定义和操作source表,连续查询,sink表,以及寻找表。同时,Flink也支持通过SQL查询和Table API查询两种方式混合使用来查询Table。

你直接用的话数据太乱了,你自己map成{"id":"","":"" ....,"createtime":""}这种数据看的不更清楚吗 ,此回答整理自钉群“【③群】Apache Flink China社区”

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。