求助下Flink CDC,我 要监听100个库里,相同的20个表,咋写?之前就把所有库里的 order表订阅了。

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

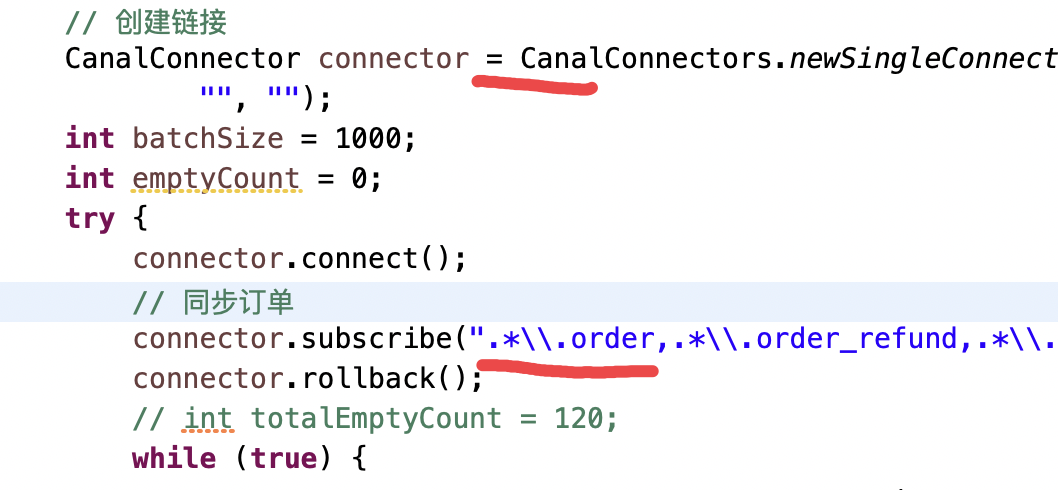

要监听100个库中的相同20个表,你可以使用Flink CDC的DebeziumSourceFunction来创建一个自定义的源函数。以下是一个示例代码:

import org.apache.flink.api.common.serialization.SimpleStringSchema;

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

import org.apache.flink.streaming.connectors.debezium.DebeziumSourceFunction;

import org.apache.flink.table.api.bridge.java.StreamTableEnvironment;

import org.apache.flink.table.catalog.hive.HiveCatalog;

import org.apache.flink.table.descriptors.SchemaDescriptor;

import org.apache.flink.table.descriptors.TableDescriptor;

import org.apache.flink.table.factories.TableFactory;

import org.apache.flink.table.factories.utils.FactoryUtil;

public class FlinkCDCExample {

public static void main(String[] args) throws Exception {

// 创建流处理环境

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

// 创建表执行环境

StreamTableEnvironment tableEnv = StreamTableEnvironment.create(env);

// 注册HiveCatalog

HiveCatalog hiveCatalog = new HiveCatalog("default", "localhost:9083", "default");

tableEnv.registerCatalog("hive", hiveCatalog);

tableEnv.useCatalog("hive");

// 定义要监听的表名列表

List<String> tableNames = Arrays.asList("table1", "table2", ..., "table20");

// 为每个表创建一个DebeziumSourceFunction实例

for (String tableName : tableNames) {

DebeziumSourceFunction<String> sourceFunction = createDebeziumSourceFunction(tableName);

env.addSource(sourceFunction).print();

}

// 启动Flink作业

env.execute("Flink CDC Example");

}

private static DebeziumSourceFunction<String> createDebeziumSourceFunction(String tableName) {

return new DebeziumSourceFunction<>(

tableName,

new SimpleStringSchema(),

new MyCustomDebeziumProperties() // 自定义Debezium属性

);

}

}

在这个示例中,你需要将tableNames列表替换为你实际要监听的20个表的名称。同时,你需要实现一个自定义的MyCustomDebeziumProperties类,用于配置Debezium的相关属性。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。