Flink CDC这个bug有大佬帮看下吗?https://github.com/ververica/flink-cdc-connectors/issues/2950

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

根据您提供的问题链接以及知识库中的相关资料,以下是对该问题的分析和解决方案建议:

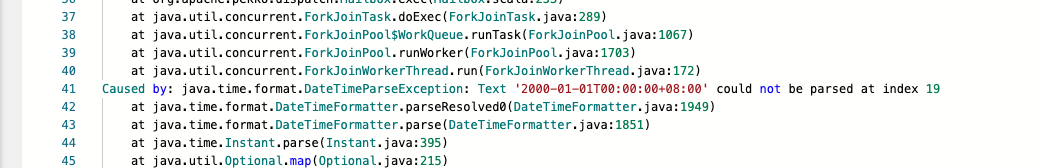

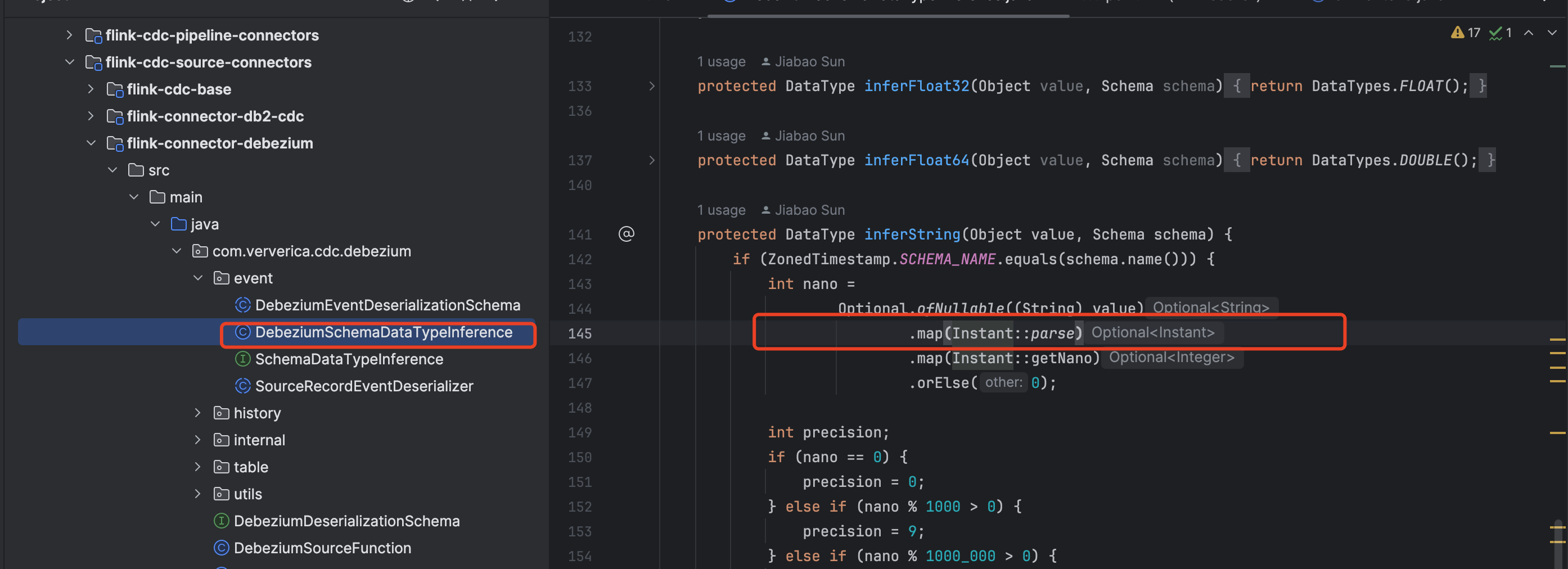

您提到的Flink CDC问题(GitHub Issue #2950)可能涉及Flink CDC连接器在特定场景下的异常行为。虽然具体的错误信息未明确提供,但结合知识库中的内容,我们可以推测问题可能与以下常见场景相关: 1. SSL连接问题:例如java.io.EOFException: SSL peer shut down incorrectly。 2. Binlog解析问题:例如MySQL CDC在解析大量Binlog时可能出现OOM(Out of Memory)问题。 3. 连接器依赖冲突:例如在本地调试时出现ClassNotFoundException。

如果您的问题与SSL连接相关,可以尝试在MySQL CDC表的WITH参数中添加以下配置以禁用SSL:

'jdbc.properties.useSSL'='false'

或者在MySQL连接URL中追加以下参数:

'url'='jdbc:mysql://<host>:<port>/<database>?characterEncoding=utf-8&useSSL=false'

此方法适用于VVR 6.0.2及以上版本。如果您的Flink版本较低,建议升级到支持该功能的版本。

如果问题与Binlog解析相关,可能是由于Flink CDC在处理大量Binlog时内存不足导致的OOM异常。根据知识库中的修复记录,Flink CDC已优化了此类问题,现在会在发生异常时触发作业Failover,而不是静默重试。

建议操作: - 确保您使用的是最新版本的Flink CDC连接器(如2.4.2或更高版本)。 - 如果问题仍然存在,可以尝试调整Flink作业的内存配置,增加TaskManager的堆内存大小:

taskmanager.memory.process.size: 4g

如果问题出现在本地调试环境中,可能是由于连接器依赖缺失导致的ClassNotFoundException。根据知识库中的解决方案,您可以按照以下步骤解决: 1. 下载Uber JAR包: - 从Maven中央仓库下载包含运行类的Uber JAR包。例如,对于MaxCompute连接器,下载ververica-connector-odps-<version>-uber.jar。 2. 配置pipeline.classpaths: - 在代码中为Flink环境添加pipeline.classpaths配置,指定Uber JAR包的路径。例如: java Configuration conf = new Configuration(); conf.setString("pipeline.classpaths", "file:///path/to/uber-jar.jar"); StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment(conf);

如果您需要对社区版CDC连接器进行自定义修改(如更改连接器名称),可以参考以下步骤: 1. 克隆Flink CDC连接器的GitHub仓库,并切换到指定版本的分支代码。 2. 修改连接器工厂类的factoryIdentifier方法,例如:

@Override

public String factoryIdentifier() {

return "custom-cdc-connector";

}

如果您能提供更多具体的错误信息或上下文,我可以进一步为您分析和解决问题。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。