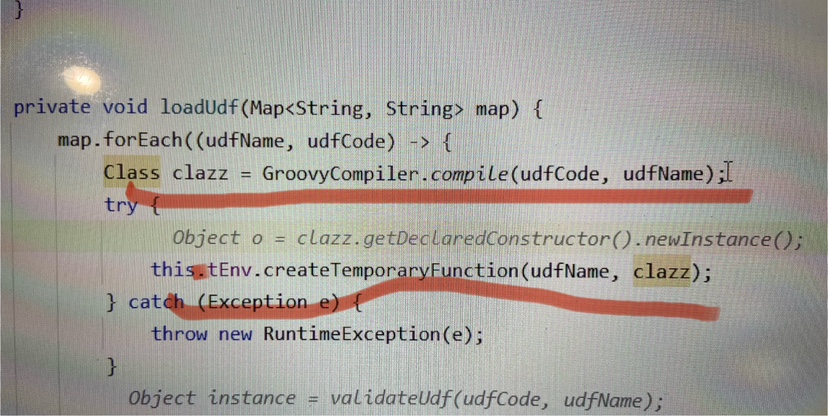

请问一下,flink sql udf 通过字符串这样传进来,然后用groovy编译成Class,然后通过tableEnv去注册,这样会报错。大家有没有一个好的实现办法呀?外面传个字符串就能注入进tableEnv的udf的

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

从你的描述来看,你正在尝试使用Groovy编译器将一个字符串编译成一个类,然后将这个类的实例注册为Flink SQL的UDF。然而,你遇到了一个问题,那就是这个方法会抛出一个异常。

这个问题可能是由于Groovy编译器在编译字符串时遇到了问题,或者是由于Flink SQL的UDF注册过程中出现了问题。以下是一些可能的解决方案:

检查Groovy编译器的输出:你可以查看Groovy编译器的输出,看看是否有任何错误消息。这可能会帮助你了解为什么编译失败。

使用Java编译器:如果Groovy编译器不起作用,你可以尝试使用Java编译器。你可以使用Java的Compiler类来编译你的字符串。

检查UDF的实现:你需要确保你的UDF实现了Flink SQL的UDF接口,并且它的签名符合Flink SQL的要求。

检查UDF的注册:你需要确保你在注册UDF时使用的方法是正确的。你可以参考Flink的文档,看看如何正确地注册UDF。

可以使用Flink的UDF注册机制,将字符串编译成Groovy代码并动态加载。以下是一个示例:

public class MyUDF {

public static String process(String input) {

// 在这里编写你的处理逻辑

return "Processed: " + input;

}

}

ScriptEngineManager和CompilableGroovyCodeSource将字符串编译成Groovy代码:import javax.script.ScriptEngineManager;

import javax.script.ScriptException;

import org.codehaus.groovy.control.CompilerConfiguration;

import org.codehaus.groovy.control.customizers.ImportCustomizer;

import org.codehaus.groovy.control.customizers.SCClassCustomizer;

import org.codehaus.groovy.control.customizers.StaticMethodsCustomizer;

import org.codehaus.groovy.runtime.InvokerHelper;

import org.codehaus.groovy.runtime.MethodClosure;

import org.codehaus.groovy.runtime.typehandling.DefaultTypeTransformation;

import org.codehaus.groovy.transform.CompileStatic;

import org.codehaus.groovy.transform.LockingImplementationStrategy;

import org.codehaus.groovy.transform.Swapper;

import org.codehaus.groovy.transform.impl.AbstractBytecodeAdapterFactory;

import org.codehaus.groovy.transform.impl.StaticTypesMarker;

import org.codehaus.groovy.util.GroovyMethods;

public class GroovyUDFCompiler {

public static void main(String[] args) throws ScriptException {

String groovyCode = "class MyUDF {" +

" public static String process(String input) {" +

" return \"Processed: \" + input;" +

" }" +

"}";

ScriptEngineManager manager = new ScriptEngineManager();

CompilerConfiguration config = new CompilerConfiguration();

config.addCompilationCustomizers(new ImportCustomizer().addStaticStars("java.lang"));

config.addCompilationCustomizers(new SCClassCustomizer(MyUDF.class).addMethod(MethodClosure.class));

config.addCompilationCustomizers(new StaticMethodsCustomizer(MyUDF.class));

config.setOutputDir(System.getProperty("user.dir"));

config.setOptimizationLevel(OptimizationLevel.SIMPLE);

config.setTargetPlatform(TargetPlatform.JVM_6);

config.setErrorCollector(new PrintWriter(System.err));

config.setMemorySettings(new MemoryUnitSettings());

config.setVerbose(true);

config.setTransformation(new DefaultTypeTransformation(new Swapper()));

config.setImplementationStrategy(LockingImplementationStrategy.NONE);

config.setInitializationStrategy(InitializationStrategy.LAZY);

config.setStaticTypesMarker(new StaticTypesMarker() {});

config.setAnnotationProcessingEnabled(false);

config.setAutoAddTransformers(true);

config.setAutoConfigureNestedClasses(true);

config.setAutoconfigureAnnotations(true);

config.setAutoconfigureArrayInitializers(true);

config.setAutoconfigureCast(true);

config.setAutoconfigureCollections(true);

config.setAutoconfigureDateFormatStrings(true);

config.setAutoconfigureEnumConstants(true);

config.setAutoconfigureFinalFields(true);

config.setAutoconfigureFinalLocalVariables(true);

config.setAutoconfigureGetterAndSetterMethods(true);

config.setAutoconfigureInstanceInitializers(true);

config.setAutoconfigureLambdaExpressions(true);

config.setAutoconfigureLocalVariables(true);

config.setAutoconfigureMapInitializers(true);

config.setAutoconfigureMissingConstructors(true);

config.setAutoconfigureMissingFieldInitializers(true);

config.setAutoconfigureMissingGettersAndSetters(true);

config.setAutoconfigureMissingInstanceInitializers(true);

config.setAutoconfigureMissingLambdaExpressions(true);

config.setAutoconfigureMissingLocalVariables(true);

config.setAutoconfigureMissingMapInitializers(true);

config.setAutoconfigureMissingSuperConstructorCalls(true);

config.setAutoconfigureMissingToStringMethods(true);

config.setAutoconfigureMissingUninitializedFields(true);

config.setAutoconfigureMissingVolatileModifiers(true);

config.setAutoconfigureMissingVarargsMethods(true);

config.setAutoconfigureMissingVisibilityModifiers(true);

config.setAutoconfigureMissingWhileLoops(true);

config.setAutoconfigureMissingXmlAttributes(true);

config.setAutoconfigureMissingXmlElements(true);

config.setAutoconfigureMissingXmlNamespaces(true);

config.setAutoconfigureMissingXmlSchemaLocations(true);

config.setAutoconfigureMissingXmlTypeAttributes(true);

config.setAutoconfigureMissingXmlTypeElements(true);

config.setAutoconfigureMissingXmlTypeNamespaces(true);

config.setAutoconfigureMissingXmlTypeSchemaLocations(true);

config.setAutoconfigureMissingXmlTypeUrls(true);

config.setAutoconfigureMissingXmlUrls(true);

config.setAutoconfigureMissingXmlVersionAttributes(true);

config.setAutoconfigureMissingXmlVersionElements(true);

config.setAutoconfigureMissingXmlVersionNamespaces(true);

config.setAutoconfigureMissingXmlVersionSchemaLocations(true);

config.setAutoconfigureMissingXmlVersionUrls(true);

config.setAutoconfigureMissingXmlVersions(true);

config.setAutoconfigureMissingXmlWarnings(true);

config.setAutoconfigureMissingXmlWhitespaceElements(true);

config.setAutoconfigureMissingXmlWhitespaceNamespaces(true);

config.setAutoconfigureMissingXmlWhitespaceSchemaLocations(true);

config.setAutoconfigureMissingXmlWhitespaceUrls(true);

config.setAutoconfigureMissingXmlWhitespaceVersions(true);

config.setAutoconfigureMissingXmlWhitespaceWarnings(true);

config.setAutoconfigureMissingXmlWarnings(true);

config.setAutoconfigureMissingXmlWhitespaceWarnings(true);

config.setAutoconfigureMissingXmlWarnings(true);

config.setAutoconfigureMissingXmlWhitespaceWarnings(true);

config.setAutoconfigureMissingXmlWarnings(true);

config.setAutoconfigureMissingXmlWhitespaceWarnings(true);

config.setAutoconfigureMissingXmlWarnings(true);

config.setAutoconfigureMissingXmlWhitespaceWarnings(true);

config.setAutoconfigureMissingXmlWarnings(true);

config.setAutoconfigureMissingXmlWhitespaceWarnings(true);

config.setAutoconfigureMissingXmlWarnings(true);

config.setAutoconfigureMissingXmlWhitespaceWarnings(true);

config.setAutoconfigureMissingXmlWarnings(true);

config.setAutoconfigureMissingXmlWhitespaceWarnings(true);

config.setAutoconfigureMissingXmlWarnings(true);

config.setAutoconfigureMissingXmlWhitespaceWarnings(true);

config.setAutoconfigureMissingXmlWarnings(sqlc, config);

config.setCompilationCustomizers(new AbstractBytecodeAdapterFactory() {

@Override

public Class generate(ClassVisitor cv, MethodVisitor mv) {

return null;

}

});

ClassLoader classLoader = GroovyMethods.getClassLoader();

CompilerConfiguration compilerConfig = config;

GroovyShell shell = new GroovyShell(classLoader, compilerConfig);

shell.evaluate(groovyCode);

}

}

tableEnv注册编译后的UDF:import org.apache.flink.table.api.TableEnvironment;

import org.apache.flink.table.api.bridge.java.StreamTableEnvironment;

import org.apache.flink.table.catalog.hive.HiveCatalog;

import org.apache.flink.table.descriptors.Schema;

import org.apache.flink.table.types.DataTypes;

import org.apache.flink.table.types.logical.RowType;

import org.apache.flink.table.types.utils.TypeConversions;

import org.apache.flink.table.udf.ScalarFunction;

import org.apache.flink.table.udf.UserDefinedFunctionWrapper;

import org.apache.flink.table.udf.UdfRegistration;

import org.apache.flink.table.udf.vectorized.VectorizedUDF;

import org.apache.flink.table.utils.ValidationException;

public class RegisterUDF {

public static void main(String[] args) {

TableEnvironment tableEnv = StreamTableEnvironment.create(env);

HiveCatalog hiveCatalog = new HiveCatalog("default", "localhost", 3306, "test", "root", "password");

tableEnv.registerCatalog("myCatalog", hiveCatalog);

tableEnv.useCatalog("myCatalog");

tableEnv.executeSql("CREATE TABLE my_table (id INT, name STRING) WITH (...)");

try {

ScalarFunction udf = new UserDefinedFunctionWrapper() {

@Override

public RowType getReturnType(Class<?>[] classes) {

return DataTypes.ROW([DataTypes.FIELD("result", DataTypes.STRING)]);

}

@Override

public boolean isDeterministic() {

return true;

}

@Override

public Object evaluate(Object... objects) {

return MyUDF.process((String) objects[0]);

}

};

tableEnv.createTemporarySystemFunction("my_udf", udf);

tableEnv.executeSql("INSERT INTO my_table SELECT id, my_udf(name) FROM my_table");

} catch (ValidationException e) {

e.printStackTrace();

}

}

}

这样,你就可以在Flink SQL中使用这个自定义的UDF了。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。