ModelScope中NLP相关的任务推断时如何实现批处理啊?

在ModelScope中,对于NLP相关的任务推断,可以通过使用预处理器和批量处理方法来实现批处理。预处理器的作用是对输入数据进行必要的预处理,如分词、分句等。而批量处理方法则可以将多个输入数据组合成一个批次,然后一起发送给模型进行处理,这有助于提高模型的运行效率。同时,用户还可以通过设置batch_size参数来控制每个批次包含的样本数量,以便根据需要调整模型的运行速度和精度。

在ModelScope中,对于NLP相关的任务推断,可以通过使用预处理器和批处理来实现。预processor是用于对输入数据进行一定的预处理,例如分词、编码等操作。而为了提高计算效率和内存利用率,通常会使用批处理方法来进行模型推断。

具体来说,您可以将多个输入数据组成一个批次,然后将这个批次一起输入到模型中进行推断。这种方式可以有效地减少模型的运算次数,并且可以利用GPU等硬件设备进行并行计算,从而提高模型推断的效率。

同时,您还可以通过配置文件来设置预处理器的相关参数,例如分词器的选择、分词器的路径等。具体的配置方式可以参考ModelScope的相关文档或者教程。

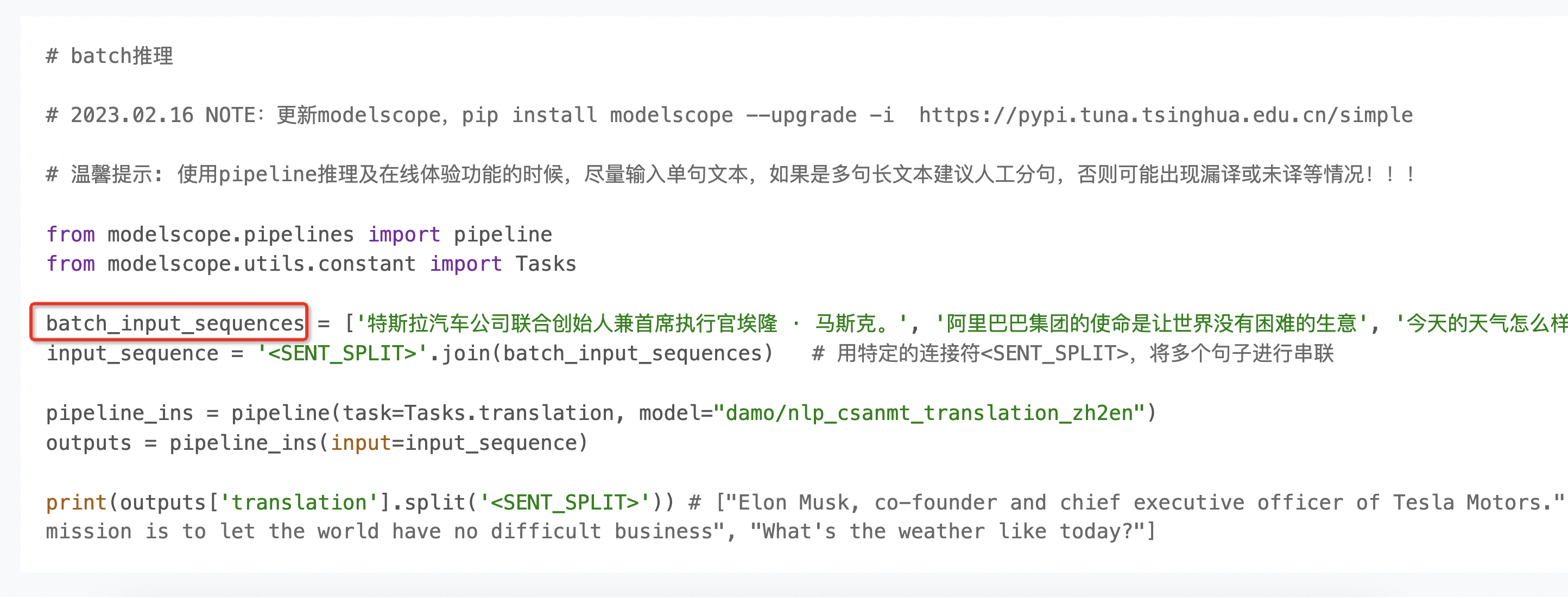

部分模型是支持的,有的是直接传入个list,可以具体看模型的modelcard页面,比如翻译这个可能不太一样

,此回答整理自钉群“魔搭ModelScope开发者联盟群 ①”