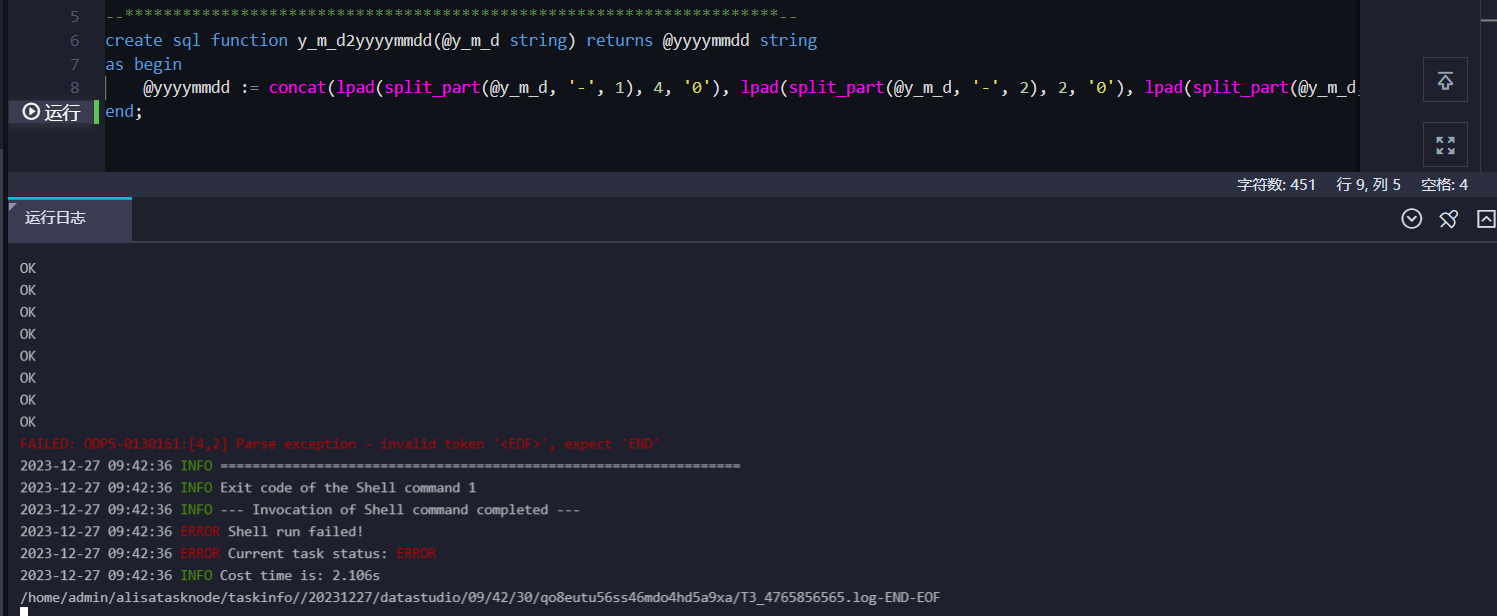

请问下大数据计算MaxCompute这个为什么会报错?

请问下大数据计算MaxCompute这个为什么会报错?测试的是官网的例子。

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

根据您提供的问题描述,MaxCompute在测试官网示例时出现报错,但未明确具体的错误信息。以下是基于知识库中常见问题的分析和解决方法,请结合实际报错信息进行排查和处理。

1. 运行超时问题

如果报错信息中包含kInstanceMonitorTimeout,可能是由于UDF(用户自定义函数)处理时间过长导致超时。

原因分析:

- MaxCompute默认限制UDF处理一批数据的时间为1800秒(30分钟)。如果处理逻辑复杂或数据量较大,可能导致超时。

解决措施:

- 优化代码逻辑:检查UDF实现是否可以进一步优化,减少计算复杂度。

- 重置计时器:在Java UDF中调用

ExecutionContext.claimAlive方法,定期重置计时器。 - 调整超时参数:

- 在Session级别设置

odps.function.timeout参数,延长超时时间。例如:set odps.function.timeout=3600; -- 将超时时间设置为3600秒

- 在Session级别设置

- 增加资源分配:

- 调整Worker内存大小或Mapper/Reducer数量,提升处理能力。例如:

set odps.stage.mapper.split.size=512; -- 调整Mapper输入数据量 set odps.stage.reducer.num=10; -- 增加Reducer数量

- 调整Worker内存大小或Mapper/Reducer数量,提升处理能力。例如:

2. 权限不足问题

如果报错信息中包含Authorization Failed或You have NO privilege,可能是权限配置问题。

原因分析:

- 当前用户缺少对表、资源或项目的操作权限。

- 如果项目启用了数据保护机制,可能禁止通过Tunnel下载数据。

解决措施:

- 检查权限配置:

- 确认当前用户是否具有

odps:Select、odps:CreateResource等必要权限。 - 联系项目所有者(Project Owner)授予相关权限。

- 确认当前用户是否具有

- 数据保护机制:

- 如果项目启用了数据保护机制,需联系项目所有者设置Exception Policy,允许特定用户下载数据。

3. SQL语法或UDTF使用问题

如果报错信息中包含Semantic analysis exception,可能是SQL语法或UDTF(用户自定义表函数)使用不当。

常见问题及解决措施:

- UDTF输出列名缺失:

- 报错信息:

expect 2 aliases but have 0 - 解决方法:在调用UDTF时,通过

as子句指定输出列名。例如:select udtffunction_name(paramname) as (col1, col2);

- 报错信息:

- UDTF与SELECT语句冲突:

- 报错信息:

only a single expression in the SELECT clause is supported with UDTF's - 解决方法:确保UDTF与其他表达式不同时出现在同一个SELECT语句中。

- 报错信息:

4. 内存或磁盘不足问题

如果报错信息中包含OutOfMemoryError或No space left on device,可能是资源不足导致的问题。

原因分析:

- Driver或Executor内存不足。

- Shuffle数据量过大,导致磁盘空间耗尽。

解决措施:

- 增加Driver内存:

- 设置

spark.driver.memory参数,例如:spark.driver.memory=8g

- 设置

- 增加Executor内存:

- 设置

spark.executor.memory参数,例如:spark.executor.memory=8g

- 设置

- 扩展磁盘空间:

- 调整

spark.hadoop.odps.cupid.disk.driver.device_size参数,例如:spark.hadoop.odps.cupid.disk.driver.device_size=50g

- 调整

- 优化数据分布:

- 如果存在数据倾斜,可减少单个Executor的核数(

spark.executor.cores),并增加Executor数量(spark.executor.instances)。

- 如果存在数据倾斜,可减少单个Executor的核数(

5. 表或视图不存在问题

如果报错信息中包含Table or view not found,可能是表或视图未正确创建。

原因分析:

- 表或视图在目标项目中不存在。

- Hive的catalog配置被错误启用。

解决措施:

- 检查表是否存在:

- 执行以下命令确认表名是否正确:

show tables;

- 执行以下命令确认表名是否正确:

- 禁用Hive支持:

- 如果启用了Hive支持,需移除

enableHiveSupport()配置。例如:spark = SparkSession.builder.appName(app_name).getOrCreate()

- 如果启用了Hive支持,需移除

6. 其他常见问题

如果以上情况均不适用,请参考以下补充说明:

-

身份验证失败:

- 报错信息:

User signature does not match - 解决方法:检查

spark-defaults.conf中的AccessKey ID和AccessKey Secret是否正确。

- 报错信息:

-

Session过期:

- 报错信息:

The download session is expired - 解决方法:重新创建Download Session以继续下载数据。

- 报错信息:

-

小文件过多:

- 报错信息:

StatusConflict - 解决方法:合并小文件,减少文件数量。

- 报错信息:

总结

请根据实际报错信息,结合上述分析逐一排查问题。如果仍无法解决,请提供具体的错误码或报错信息,以便进一步定位问题。您可以复制页面截图提供更多信息,我可以进一步帮您分析问题原因。

MaxCompute(原ODPS)是一项面向分析的大数据计算服务,它以Serverless架构提供快速、全托管的在线数据仓库服务,消除传统数据平台在资源扩展性和弹性方面的限制,最小化用户运维投入,使您经济并高效的分析处理海量数据。